Wir versuchen hier, ein 90-seitiges Arbeitspapier in einem binnen zehn Minuten lesbaren Text zusammenzufassen. Im Kern beantworten wir drei zentrale Fragen der Öffentlichkeit im digitalen Zeitalter: Wie verändert sich Öffentlichkeit? Ist das teilhabeförderlich? Was ist zu tun, um Teilhabe zu sichern?

1. Medienwandel: Wie verändert sich die Öffentlichkeit durch neue digitale Plattformen, über die heute viele Menschen gesellschaftlich relevante Informationen beziehen?

Die ganz kurze Antwort: Von algorithmischen Prozessen gesteuerte Intermediäre wie Google oder Facebook haben – wenn man alle Altersgruppen zusammen betrachtet – im Vergleich zu redaktionell gesteuerten Medien wie dem Fernsehen einen großen, aber bislang nicht entscheidenden Einfluss auf die öffentliche Meinungsbildung. Sie bewerten die Relevanz von Inhalten viel stärker als redaktionelle Medien an unmittelbaren Reaktionen des Publikums.

2. Gesellschaftliche Folgen: Sind Informationen, die Menschen auf diesen neuen Wegen erreichen, in ihrer Qualität und Vielfalt als Basis demokratischer Willensbildung und geeignet und teilhabeförderlich?

Die ganz kurze Antwort: Die Nutzung der Intermediäre für öffentliche Meinungsbildung führt zu einem Strukturwandel der Öffentlichkeit. Zentral sind dabei algorithmische Prozesse als wesentliches Gestaltungsmittel und die bedeutende Rolle von Nutzerreaktionen als Input dieser Prozesse. Eine Reihe psychologischer Faktoren führt dazu, dass die ausgewerteten vor allem impulsiven Publikumsreaktionen schlecht geeignet sind, um Relevanz im Sinne der klassischen Leitwerte zu bewerten. Jener Leitwerte wie Wahrheit, Vielfalt oder gesellschaftliche Integration, die in Deutschland Grundlage der von redaktionellen Medien geschaffenen Öffentlichkeit sind.

3. Lösungsansätze: Welche Ansatzpunkte sind denkbar, um die neuen digitalen Plattformen teilhabeförderlich zu gestalten?

Die ganz kurze Antwort: Im Zentrum der komplexen Wechselwirkungen digitaler Öffentlichkeit stehen algorithmische Prozesse, die Inhalten sortieren und die Zusammenstellung personalisieren. Deshalb müssen Lösungen zuerst hier ansetzen. Zu den derzeit absehbaren wichtigsten Handlungsfeldern zählen die Ermöglichung externer Beforschbarkeit und Evaluation, Stärkung der Vielfalt algorithmischer Prozesse, Verankerung von Leitwerten, z. B. durch eine Professionsethik, und die Sensibilisierung des Publikums.

Hier etwas ausführlicher:

1. Medienwandel: Intermediäre sind relevant für die Meinungsbildung, aber nicht entscheidend.

Dass sogenannte Intermediäre wie Google oder Facebook eine relevante Rolle für die Meinungsbildung spielen, auch hierzulande, zeigen zahlreiche Studien. 57 Prozent der deutschen Internetnutzer beziehen auch politisch-gesellschaftliche Informationen über Suchmaschinen oder soziale Netzwerke. Zwar ist der Anteil derer, die soziale Netzwerke als ihre wichtigste Nachrichtenquelle nennen, mit sechs Prozent aller Internetnutzer noch relativ klein – doch in den jüngeren Altersgruppen sind die Anteile deutlich höher. Insgesamt ist von einer zunehmenden Bedeutung solcher Plattformen auszugehen. Meinungsbildung sei „ohne Intermediäre nicht mehr denkbar“, so formulierten es 2016 Forscher vom Hamburger Hans-Bredow-Institut.

Die Gestaltungsprinzipien dieser Intermediäre führen zu einem Strukturwandel der Öffentlichkeit. Zentrale Aspekte sind:

-

- Entkopplung von Veröffentlichung und Reichweite: Jeder kann veröffentlichen. Aber nicht jeder findet ein Publikum. Aufmerksamkeit entsteht erst durch das Zusammenwirken von Menschen und ADM-Prozessen.

- Entbündelung von Publikationen: Reichweite wird auf Beitragsebene ausgehandelt.

- Personalisierung: Nutzer erfahren mehr über ihre Interessengebiete

- Größerer Einfluss des Publikums auf Reichweiten: Nutzerreaktionen beeinflussen ADM-Prozess insgesamt und die Reichweite jedes Beitrags.

- Zentralisierung der Auswahlinstanzen: Es gibt bei Intermediären eine deutlich geringere Vielfalt als bei redaktionell kuratierten Medien.

- Wechselwirkung zwischen redaktioneller und maschineller Kuratierung: Redaktionell kuratierte Medien verbreiten Inhalte über Intermediäre und nutzen Reaktionen in diesen als Signal für Publikumsinteresse.

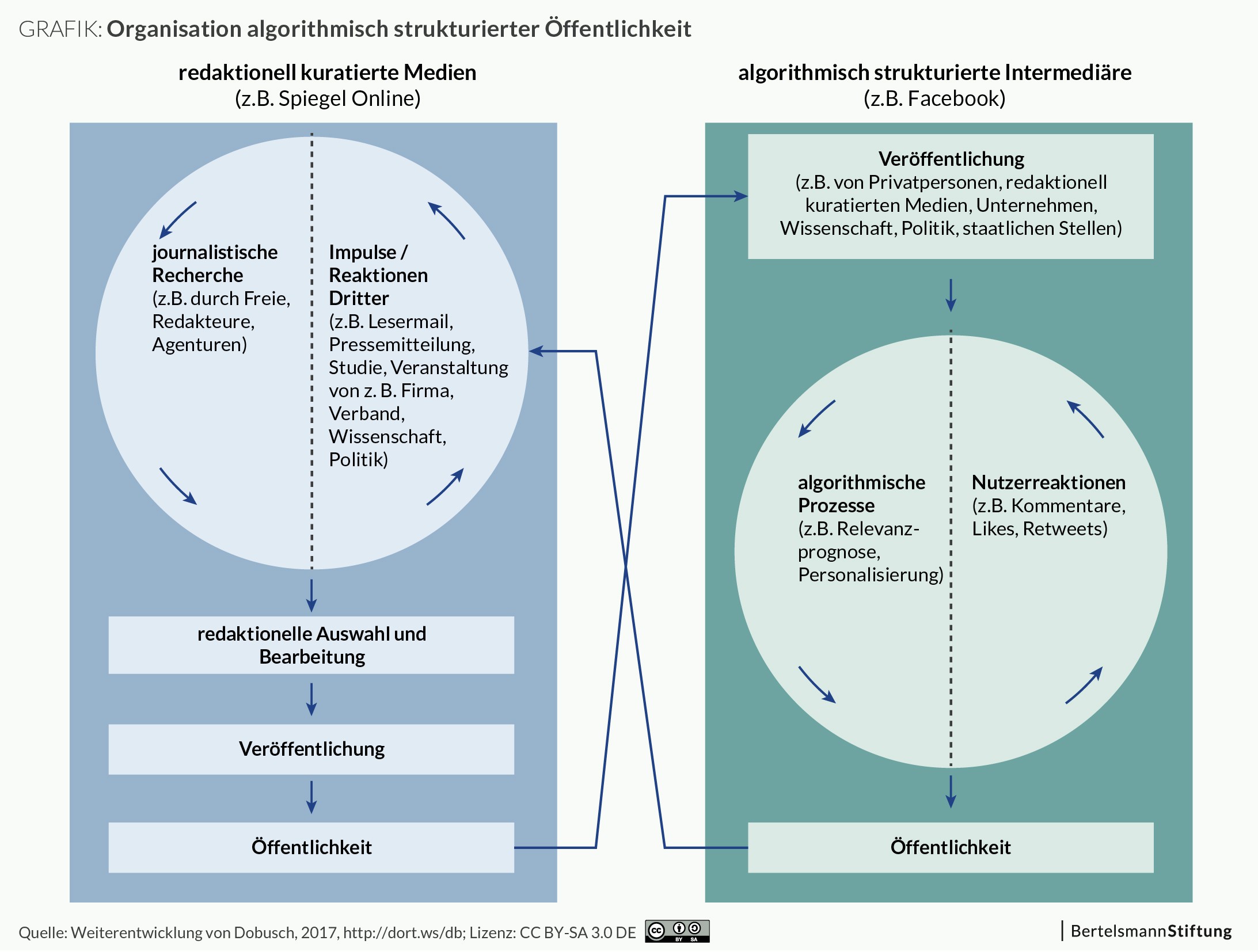

Der Vergleich der beiden Öffentlichkeitsverläufe in Abbildung 2 zeigt die neue, zentrale Rolle von Nutzerreaktionen und algorithmischen Prozessen. Beide bestimmen die Verteilung von Aufmerksamkeit über Intermediäre. Unsere Hypothese ist, dass Nutzerreaktionen und ADM-Prozesse sich dabei nicht eindeutig in eine lineare Kausalkette bringen lassen.

Google, Facebook und Co. spielen im öffentlichen Diskurs also bereits jetzt wichtige Rollen. Dabei wurden diese Plattformen ursprünglich nicht primär dafür konstruiert, Medieninhalte von journalistischen Organisationen an Konsumenten weiterzureichen. Sie benutzen technische Systeme, um zu entscheiden, ob ein bestimmter Inhalt aus einem gewaltigen Fundus für einen bestimmten Nutzer interessant, relevant sein könnte oder nicht. Diese Systeme waren ursprünglich aber eher darauf ausgelegt, etwa – im Falle von Suchmaschinen – Webseiten auszuwerfen, die eine bestimmte Information enthalten, oder – im Falle von sozialen Netzwerken – besonders interessante Wortmeldungen oder Fotos aus dem eigenen Freundeskreis prominent zu platzieren. Sie sortieren Inhalte deshalb nach teilweise völlig anderen Kriterien, als beispielsweise die Redakteure einer Tageszeitung oder eines Magazins das tun würden. Relevanz bedeutet für Google etwas anderes als für Facebook und beide verstehen unter dem Begriff etwas anderes als die Redaktionen beispielsweise von SPIEGEL ONLINE oder Sueddeutsche.de.

Die Intermediäre erfassen zur Errechnung solcher Relevanzwerte für einzelne Inhalte eine Vielzahl von Variablen. Diese Signale reichen von basalen Verhaltensmaßen wie der Scrollgeschwindigkeit oder der Verweildauer auf einzelnen Seiten bis hin zum Grad der Interaktion zwischen mehreren Nutzern eines sozialen Netzwerks. Wenn eine Person, mit der man bei Facebook schon öfter kommuniziert hat, einen Inhalt postet, ist die Wahrscheinlichkeit höher, dass man diesen Inhalt zu sehen bekommt als bei einer anderen Person, mit der man zwar theoretisch digital verknüpft ist, praktisch aber nie in Kontakt tritt. Auch die Signale, die andere Nutzer – oft unwissentlich – aussenden, gehen in die Relevanzbewertung mit ein, seien es Verlinkungen, Klicks auf Links oder den „Gefällt mir“-Button, Weiterreichungen, sogenannte Shares, oder die Anzahl der Kommentare, die ein bestimmter Inhalt hervorruft.

2. Gesellschaftliche Folgen: Die heute von den für die Meinungsbildung besonders relevanten Intermediären genutzten algorithmischen Systeme werten menschliche Reaktionen auf Inhalte aus. Sie fördern und verstärken einen für Verzerrungen anfälligen menschlichen Kognitionsstil und sind für gezielte technische Manipulationen anfällig.

Die Relevanzsignale, über die die Plattformbetreiber aus Wettbewerbs- und anderen Gründen nur ungern detaillierte Auskünfte geben, sind potenziell problematisch. Zunächst einmal deshalb, weil die Betreiber der entsprechenden Plattformen sie selbst ununterbrochen verändern: Systeme wie die von Google oder Facebook sind in einem permanenten Wandel begriffen, an nahezu jedem Aspekt der Benutzeroberfläche und anderen Eigenschaften der Plattformen wird experimentiert und geschraubt, um bestimmte Effekte wie zum Beispiel Interaktionsintensität zu erzielen. Jede dieser Veränderungen beeinflusst ihrerseits potenziell die Relevanzsignale, die die Plattformen selbst messen.

Ein gutes Beispiel ist die „People you may know“-Funktion bei Facebook, die auf Basis von Netzwerkauswertungen mögliche Bekannte des jeweiligen Nutzers als zusätzliche Kontakte vorschlägt. Als dieses Empfehlungssystem eingeführt wurde, verdoppelte sich auf einen Schlag die Anzahl der Facebook-internen Verknüpfungen, die jeden Tag hinzukommen. Die innerhalb von Netzwerkplattformen abgebildeten Beziehungsnetzwerke hängen also von den Angeboten ab, die die Betreiber machen. Gleichzeitig gehen die so katalogisierten Bekanntschaftsnetzwerke als Variablen in die Relevanzbestimmung ein. Wer zusätzliche „Freunde“ hat, bekommt womöglich auch andere Medieninhalte zu sehen.

Ein weiteres Problem der von den Plattformbetreibern erfassten Signale hat mit der Art von Interaktion zu tun, für die solche Plattformen optimiert sind: Ein zentrales Credo der Gestaltung lautet, dass Interaktionen möglichst einfach und mühelos sein sollten, um ihre Wahrscheinlichkeit zu maximieren. Auf den „Gefällt mir“-Button oder einen Link zu klicken, erfordert keinerlei kognitive Anstrengung. Und von dieser Anstrengungslosigkeit machen viele Nutzer augenscheinlich intensiv Gebrauch: So legen empirische Untersuchungen nahe, dass viele Artikel, die in sozialen Netzwerken mit einem Klick an den eigenen digitalen Freundeskreis weitergereicht werden, zuvor nicht gelesen worden sein können. Nutzer verbreiten also Medieninhalte weiter, von denen sie selbst nur die Überschrift und den Anreißertext kennen. Sie gaukeln dem Algorithmus und damit ihren „Freunden und Followern“ gewissermaßen nur vor, einen Text gelesen zu haben.

Die Leichtigkeit der Interaktion begünstigt zudem kognitive Verzerrungen, die in der Sozialpsychologie schon seit vielen Jahren bekannt sind. Ein gutes Beispiel ist die Verfügbarkeitsheuristik: Wenn ein Ereignis oder eine Erinnerung sich leicht aus dem Gedächtnis abrufen lässt, wird es oder sie als besonders wahrscheinlich oder häufig eingeschätzt. Die Konsequenz: Nicht gelesene, aber aufgrund einer Überschrift besonders häufig weitergereichte Medieninhalte begegnen Nutzern eines sozialen Netzwerks oft – und werden deshalb im Nachhinein als „wahr“ oder „wahrscheinlich“ erinnert. Das gilt auch dann, wenn der Text selbst womöglich klarmachen würde, dass die Überschrift eine groteske Übertreibung oder schlicht irreführend ist.

Auch eine Reihe anderer psychologischer Faktoren spielt hier eine wichtige Rolle, etwa die Tatsache, dass Nutzer gerade soziale Medien nicht nur zu informativen Zwecken, sondern auch als Werkzeug des Identitätsmanagements einsetzen: Manche Medieninhalte werden womöglich nur weitergereicht, um die eigene Zugehörigkeit etwa zu einem politischen Lager zu demonstrieren. Zudem begünstigt das Design vieler digitaler Plattformen flüchtige, emotionale Auseinandersetzung mit Inhalten explizit und absichtlich. Tatsächlich zeigen einschlägige Studien, dass besonders emotionalisierende Inhalte auf Netzwerkplattformen besonders häufig kommentiert und weitergereicht werden – vor allem dann, wenn es sich um negative Emotionen handelt.

Ein derartig emotionaler Umgang mit Nachrichteninhalten kann zu einer stärkeren gesellschaftlichen Polarisierung führen. Insbesondere in den USA gibt es für diese These auch erste empirische Belege. Allerdings scheinen solche Polarisierungseffekte von einer Reihe weiterer Faktoren abzuhängen, etwa dem Wahlsystem eines Landes: Gesellschaften mit Mehrheitswahlrecht wie die der USA sind womöglich anfälliger für extreme politische Polarisierung als solche mit Verhältniswahlrecht, in denen wechselnde Koalitionen regieren und ein Mehrparteiensystem institutionalisiert Interessenausgleich begünstigt. Vermutlich besteht auch eine Wechselwirkung zwischen bereits erfolgter Polarisierung und den Ergebnissen algorithmischer Sortierung von Medieninhalten. Eine Studie zeigt zum Beispiel, dass sich Anhänger von Verschwörungstheorien bei Facebook im Lauf der Zeit immer stärker der eigenen Verschwörungstheoretiker-Community zuwenden. Intensiviert wird dieser Prozess womöglich durch einen Algorithmus, der ihnen entsprechende Inhalte immer häufiger vor Augen führt. Zumindest bei Menschen mit extremen Ansichten könnten diese Systeme also tatsächlich die Entstehung sogenannter Echokammern befördern.

Auch technische Manipulationen können die Signale beeinflussen, die Intermediäre zur Relevanzbeurteilung einsetzen. Sogenannte Bots, das sind teilautonom agierende Softwarelösungen, die etwa in sozialen Netzwerken als echte Nutzer getarnt werden, können zumindest das Volumen der digitalen Kommunikation über bestimmte Themen massiv verzerren. Einer Studie zufolge waren etwa im Umfeld der US-Präsidentschaftswahlen bei Twitter 400.000 solcher Bots im Einsatz, die etwa ein Fünftel der gesamten Konversation über die TV-Debatten zwischen den Kandidaten bestritten. Es ist unklar, inwieweit solche automatisierten Systeme Menschen tatsächlich in ihrer Wahlentscheidung beeinflussen können. Klar ist dagegen, dass die von ihnen produzierten Signale – Klicks, Likes, Shares – in die Relevanzbeurteilungen der algorithmischen Entscheidungssysteme eingehen. Bots können also einen Artikel so interessant erscheinen lassen, dass der Algorithmus ihn menschlichen Nutzern zeigt.

Zusammenfassend lässt sich sagen, dass die Relevanzbewertungen algorithmischer Sortiersysteme für Medieninhalte nicht notwendigerweise gesellschaftlich wünschenswerten Kriterien folgen: Leitwerte wie Orientierung an der Wahrheit oder gesellschaftliche Integration spielen keine Rolle. Primär zählt die Optimierung der Interaktionswahrscheinlichkeit und der Verweildauer auf der jeweiligen Plattform. Interessierte Parteien, denen an gezielter Desinformation gelegen ist, können diese Mechanismen für ihre Zwecke ausnutzen: Eine kreative, zielgerichtete Lüge kann im Zweifel emotional aktivierender und damit innerhalb solcher Systeme erfolgreicher und damit reichweitenstärker sein als die langweilige Wahrheit.

3. Lösungsansätze: Im Zentrum aller komplexen Wechselwirkungen digitaler Öffentlichkeit steht die algorithmische Sortierung von Inhalten. Hier müssen Lösungen ansetzen.

Der letzte Abschnitt dieses Arbeitspapiers enthält eine Reihe von möglichen Lösungsansätzen für diese Herausforderungen. Ein erstes, vergleichsweises einfach zu erreichendes Ziel ist die Sensibilisierung der Nutzer für die genannten Prozesse und Mechanismen. Studien zeigen, dass Nutzer sozialer Netzwerkplattformen sich nicht einmal der bloßen Existenz eines Sortieralgorithmus bewusst sind, geschweige denn seiner Funktionsweise. Hier könnten Bildung und Fortbildung ebenso ansetzen wie bei einer verstärkten Sensibilisierung für und Immunisierung gegen Desinformationsversuche, etwa mithilfe einer faktenorientierten Aufklärung.

Über im Zweifel noch effektivere Interventionsmöglichkeiten verfügen die Plattformbetreiber selbst: zum Beispiel, indem sie bestimmte Leitwerte wie Angemessenheit, Verantwortlichkeit und Kompetenz, etwa bei den Entwicklung und Gestaltung der entsprechenden Systeme, stärker verankern. Mittelfristiges Ziel könnte eine branchenweite Professionsethik für Entwickler algorithmischer Entscheidungssysteme sein.

Aber auch Fachleute, die nicht für die Plattformbetreiber selbst arbeiten, könnten und sollten in die Lage versetzt werden, die Auswirkungen der dort getroffenen Entscheidungen wissenschaftlich zu begleiten und zu erforschen. Derzeit ist der Zugriff auf dafür notwendige Daten, die den Betreibern selbst in gewaltiger Zahl vorliegen, für externe Wissenschaftler oder Regulierungsbehörden mühselig bis unmöglich. Sowohl die Designentscheidungen der Plattformbetreiber als auch ihre Auswirkungen für individuelle Nutzer sind weitgehend intransparent. Systematische Verzerrungen etwa in einer bestimmten politischen Richtung ließen sich auf Basis der derzeit verfügbaren Daten kaum erkennen. Mehr Transparenz durch eine Kombination aus freiwilligen Selbstverpflichtungen und notwendigenfalls auch regulatorischen Maßnahmen könnte unabhängiges Wissen über die tatsächlichen gesellschaftlichen Auswirkungen algorithmischer Sortierung von Medieninhalten ermöglichen und mögliche Gefahren frühzeitig erkennbar machen. Eine bessere Beforschbarkeit würde eine sachliche und lösungsorientierte Debatte fördern und könnte neue Lösungsansätze aufzeigen. Eine solche Entwicklung könnte die teilhabeförderliche Gestaltung und Wirkung algorithmischer Systeme stärken. Das würde eine differenzierte Betrachtung algorithmischer Prozesse fördern und könnte das Vertrauen in die zum Nutzen der gesamten Gesellschaft gestalteten Systeme stärken.

Veröffentlicht unter CC BY-SA 3.0 DE (Namensnennung – Weitergabe unter gleichen Bedingungen). Ein Auszug aus: „Digitale Öffentlichkeit – Wie algorithmische Prozesse den gesellschaftlichen Diskurs beeinflussen“, 1. Auflage 2017 , 90 Seiten (PDF), DOI 10.11586/2017028

Kommentar schreiben