Bots erledigen viele Routineaufgaben in der Wikipedia. Diese automatischen Mitarbeiter prägen das Miteinander in der Onlineenzyklopädie. Wikipedianer haben gelernt, mit den sozialen Effekten von Algorithmen umzugehen – zum Beispiel durch eigene Robotergesetze.

Wikipedia ist ein riesiges Experimentierfeld dafür, wie Algorithmen und Menschen zusammenarbeiten können (mehr dazu in Teil 1 der Wikipedia-Bots Reihe: Wächter des Weltwissens). In der englischen Wikipedia wurde schon früh ein ausgiebiges Regelbuch für den Gebrauch von autonom agierenden „Bots“ zusammengestellt. Zwar kann jeder Wikipedia-Nutzer Bots auf den eigenen Rechnern laufen lassen, um Wikipedia-Artikel automatisch zu ändern – doch wer dies ohne Zustimmung der Community macht, riskiert eine Accountsperre.

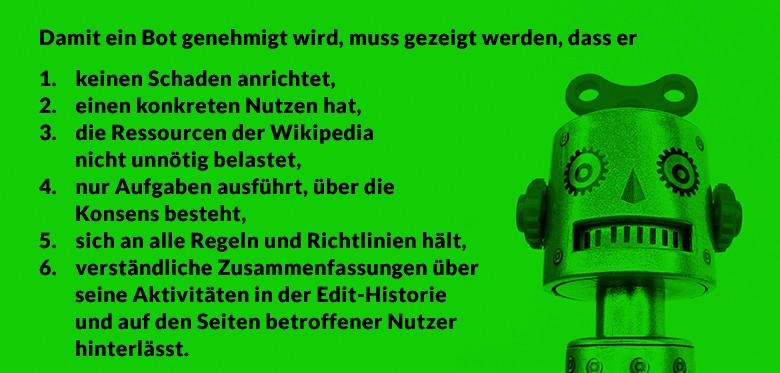

Die sechs Robotergesetze der Wikipedia

Die Wikimedia Foundation betreibt eine eigene Serverinfrastruktur, auf der Freiwillige ihre Bots ablegen können. Vorteil: Hier können die Programme ohne Schaden getestet werden, der Betreiber muss sich auch keine Gedanken um die Infrastruktur machen, auf der die Software läuft. Je nach Community erhalten Bots bestimmte Privilegien: Sie können zum Beispiel mehr Änderungen pro Minute durchführen, als es normalen Nutzern gestattet ist, und ihre Beiträge unterliegen mitunter keiner so starken Vandalismuskontrolle wie die von menschlichen Autoren. Dabei entscheidet jede Community der zahlreichen Sprachversionen und Schwesterprojekte der Wikipedia selbst, wie sie mit Bots umgehen will.

Um diese Privilegien zu erhalten, müssen die Bots aber von der Community zugelassen werden. In der englischen Wikipedia kümmert sich eine eigene „Bot Approvals Group“ darum, welche Programme laufen dürfen. Diese hat sechs Anforderungen formuliert.

Diese Kriterien sind Ergebnis einer langen Lernphase. Denn schon früh kamen Wikipedianer auf die Idee, die Sammlung des Weltwissens zumindest teilweise zu automatisieren. Dabei stießen sie jedoch wiederholt auf Probleme, die es immer wieder nötig machten, die bestehenden Regeln zu überdenken.

Kleine Fehler mit großer Wirkung

Ein erstes Beispiel war der „rambot“, der im Oktober 2002 online veröffentlichte Daten der US-Regierung nutzte, um Artikel über Ortschaften anzulegen, die bisher der Wikipedia-Community entgangen waren. Diese rudimentären Artikel enthielten nur einige Basisinformationen wie Lage und Einwohnerzahlen, die in eine einfache Textvorlage eingefügt wurden. Einerseits war das Experiment sehr erfolgreich: „rambot“ legte 30.000 neue rudimentäre Artikel an – insgesamt hatte die englische Wikipedia damals 50.000 Artikel.

In der Studie „The Emergence of Algorithmic Governance in Wikipedia“ ermittelteten die Autoren, wie stark die Anzahl der Bot-Edits in der deutschen Wikipedia über die Jahre gestiegen ist.

Andererseits traten aber auch hier schnell Probleme auf: So sorgten Fehler in den von „rambot“ ausgelesenen Daten dafür, dass der Bot mehr als 2000 defekte Artikel schuf und somit neue Arbeit für die menschlichen Autoren verursachte. Zeitweise überlastete der Bot auch die Ressourcen der jungen Onlineenzyklopädie. So konnten Nutzer in den „recent edits“ – einer automatisch erzeugten Liste der neuesten Änderungen – nur noch mit Mühe erahnen, was auf der Plattform vorging, da die Liste von Botbeiträgen überschwemmt war.

Ergebnis dieser Erfahrung: Für einige Zeit wollte zumindest die Community der englischen Wikipedia ganz auf Bots verzichten. Angesichts der schnell wachsenden Bedeutung und Komplexität der Wikipedia entschied sie sich dann aber doch für den Einsatz von Bots – allerdings unter strengen Vorgaben.

Kleinigkeiten werden zu Grundsatzfragen

Zuweilen sind die Konflikte zwischen Mensch und Maschine auch nicht technischer, sondern sozialer Natur. Dies zeigt eine Episode, die der Ethnograph R. Stuart Geiger beschreibt.

Im Jahr 2006 hatte der Wikipedia-Autor mit dem Pseudonym „Hagerman“ einen Bot entwickelt, um einen aus seiner Sicht simplen Mangel zu beheben: Die Wikipedia verfügt über kein klassisches Forensystem, stattdessen müssen Nutzer auf Diskussionsseiten ihre Beiträge selbst an der richtigen Stelle einrücken und mit der Zeichenfolge „–~~~~” unterschreiben. So ist für andere Nutzer sichtbar, wann und von wem ein Diskussionsbeitrag eingefügt wurde. Wie Hagerman jedoch beobachtete, fehlte bei vielen Beiträgen die Unterschrift — was die ohnehin unübersichtlichen Wikipedia-Diskussionen noch weniger nachvollziehbar machte.

Hagerman entschied sich, einen Bot zu programmieren, der fehlende Unterschriften eigenständig nachtrug. Dazu holte er sich das Einverständnis der neu gegründeten „Bot Approvals Group”. Obwohl das Programm so funktionierte wie geplant und bei Problemen prompt gewartet wurde, sorgte der „HagermanBot” für eine heftige Kontroverse. So sahen es einige Benutzer als ungehörigen Eingriff in ihre Nutzerrechte, dass ein Bot ihnen Vorschriften machen konnte, wie sie ihre persönlichen Meinungsbeiträge unterschrieben. Hagerman programmierte seinem Bot daher auch eine Widerspruchsfunktion ein, mit der einzelne Nutzer den Signaturautomaten für ihre eigenen Beiträge deaktivieren konnten.

Auch im administrativen Bereich der deutschen Wikipedia stecken Bots hinter einem immer größeren Anteil der Beiträge. Sie werden hier zu vielfältigen Zwecken eingesetzt — vom Nachtragen vergessener Unterschriften bis zum Newsletter-Versand.

Bots haben soziale Effekte

Doch die Grundsatzdebatte ging weiter: Wann darf ein Bot in die Beiträge von Menschen eingreifen? Das konsensorientierte Entscheidungssystem der Wikipedia sorgte dafür, dass den Kritikern schließlich weitere Zugeständnisse gemacht wurden. So entwickelte Hagerman einen Standard, mit denen Nutzer den Bot von bestimmten Nutzer- und Diskussionsseiten einfach ausschließen konnten. Auch andere Botprogrammierer übernahmen diesen Standard schließlich.

Dass ein solcher Konflikt hochschaukeln kann, wundert Forscher nicht. „Wikipedia ist ein sozio-technisches System“, sagt Professorin Claudia Müller-Birn, die an der Freien Universität Berlin zu Human-Computer Collaboration forscht, im Gespräch mit blogs.bertelsmann-stiftung.de/algorithmenethik. Das heißt: Die technischen und sozialen Komponenten der Plattform sind nicht einfach trennbar, sondern interagieren auf vielen Ebenen.

Die Wikipedia-Bots wirken ähnlich wie Straßenschwellen, die zur Geschwindigkeitsreduzierung eingesetzt werden. Selbst wenn die Schwelle nur zur Umsetzung eines ohnehin bestehenden Geschwindigkeitslimits gebaut wird, verändert sie die Natur der Straße, sodass zum Beispiel auch ein Notarzt im Einsatz das Geschwindigkeitslimit nicht überschreiten kann. Aus einem sozialen Konsens wird eine unüberwindbare Regel.

Boteinsatz vertreibt menschliche Autoren

Der Einsatz von Bots und anderen softwaregestützten Werkzeugen hat im sozialen Gefüge der Wikipedia-Community schon nachhaltige Spuren hinterlassen. So haben Aaron Halfaker und R. Stuart Geiger in einer Studie festgestellt, dass die kompromisslose Vandalismusbekämpfung in der Wikipedia messbare Effekte auf die Nutzerzahl in der Wikipedia hat.

Die Forscher gehen auf Basis ihrer Daten davon aus, dass im Zeitverlauf konstant dieselbe Anzahl wohlmeinender Neuankömmlinge zum erst Mal einen Wikipedia-Artikel bearbeitet. Rapide zugenommen hat aber die Anzahl der „reverts“, mit denen die Beiträge der Neulinge oft innerhalb von Sekunden rückgängig gemacht wurden. Ergebnis: Viele möglicherweise wertvolle Autoren wurden an der Eingangstür der Wikipedia abgewiesen – und womöglich auf Dauer abgeschreckt.

Abschreckung durch harsche Kritik an Neulingen per „revert“ ist nicht nur auf Bots beschränkt. So hat auch die deutsche Wikipedia mit dem Rückgang von Editoren zu kämpfen, obwohl hier Bots wie ClueBot NG nicht eigenständig Wikipedia-Beiträge menschlicher Nutzer löschen dürfen. Stattdessen setzt die deutsche Community auf Software wie „Huggle“, die auf die gleichen Daten wie der Bot zugreifen, um zu entscheiden, ob ein neuer Beitrag Vandalismus darstellt oder nicht. Die Entscheidung zur Löschung eines Beitrags trifft hier jedoch kein Algorithmus, sondern ein Mensch. Für die betroffenen Autoren macht dies aber kaum einen Unterschied. So stellten Geiger und Halfaker fest, dass die Nutzer von Huggle nur auf 7 Prozent der Nachfragen zu ihren Löschungen antworteten.

Dieses Verständnis der Tragweite des Boteinsatzes hat in vielen Wikipedia-Communities zu einem vorsichtigen Vorgehen geführt. „Als Botbetreiber muss man für seinen Bot geradestehen“, erklärt die Wikipedia-Autorin mit dem Pseudonym „Freddy2001“, die selbst auch einen Bot betreibt. Aus diesem Grund hat sie auf der Nutzerseite ihres Bots Buttons eingebunden, mit der jeder Nutzer die Bots anhalten kann. Bevor ihr Bot einen Nutzer verärgert, soll er lieber seine Aktivitäten einstellen.

Neue Offenheit stoppt rapiden Nutzerschwund

Diese Möglichkeit gibt es freilich nicht bei allen Bots – so sind Vandalismusbekämpfungstools wie ClueBot NG angesichts des grassierenden Vandalismus kaum verzichtbar. Um der Bedeutung der Onlineenzyklopädie gerecht zu werden, müssen die Wikipedia-Communities immer einen Kompromiss zwischen Arbeitserleichterung für bestehende Nutzer und Offenheit für neue Nutzer finden.

Mittlerweile hat die Wikimedia Foundation eine Reihe von Initiativen umgesetzt, um das Projekt für Neulinge attraktiver zu machen: So ermöglicht es der neue „VisualEditor“ Artikel zu verfassen, ohne sich mit komplexen Wikipedia-Formatierungen auseinanderzusetzen. Dazu gibt es neue Mentorenprogramme und Tools, um sich für konstruktive Beiträge zu bedanken. Zwar konnte die Wikipedia-Community damit nicht wieder zur alten Stärke heranwachsen, aber zumindest der rapide Nutzerschwund scheint vorerst gestoppt.

Mit dem Start von Wikimedias neuer Faktenplattform Wikidata im Jahr 2012 haben Bots ein weiteres Beschäftigungsfeld und eine neue Bedeutung gewonnen – mehr dazu in Teil 3 unserer Serie. Teil 1 der Serie finden Sie hier. Über neue Beiträge in diesem Blog können Sie sich per RSS-Feed oder per E-Mail-Newsletter benachrichtigen lassen.

Kommentar schreiben