Hollywoodszenarien und der Glaube an magische Technik: Wir über- und unterschätzen die Entwicklung künstlicher Intelligenz zugleich, argumentiert Roboteringenieur Rodney Brooks. Seine These: Systematisch verzerrte menschliche Intelligenz prägt die Debatte über künstliche.

Dies ist eine Übersetzung des Essays “The seven deadly sins of predicting the future of AI” des australischen Roboteringenieurs Rodney Brooks mit freundlicher Genehmigung des Autors.

Die sieben tödlichen Sünden:

Sünde 1: Über- und Unterschätzen

Sünde 2: Magische Vorstellungen

Sünde 3: Konkrete Leistung versus generelle Kompetenz

Sünde 4: Ein Wort – ein Koffer voller Bedeutungen

Sünde 5: Exponentialismus

Sünde 6: Hollywoodszenarien

Sünde 7: Das Tempo der Implementierung

Wir sind umgeben von Hysterie, wenn über die Zukunft der Künstlichen Intelligenz und der Robotik spekuliert wird. Wie groß wird ihr Einfluss sein, wie schnell wird er wachsen, wie werden sie die Arbeitswelt verändern? Hysterie prägt viele Antworten, die auf diese Fragen gegeben werden.

Ich schreibe diesen Text am 2. September 2017. Während ich daran arbeite, fallen mir zwei Nachrichten über die Entwicklung der KI ins Auge, die in den letzten 48 Stunden erschienen sind. Sie sind exemplarisch.

Gestern veröffentlichte Oren Etzioni, der Direktor des Allen Institute for Artificial Intelligence, in der New York Times einen Kommentar mit dem Titel „Wie sich Künstliche Intelligenz regulieren lässt“ („How to Regulate Artificial Intelligence“). Er findet überzeugende Argumente gegen die hysterische Angst, Künstliche Intelligenz sei eine existenzielle Bedrohung für die Menschheit. Während andere, die es eigentlich besser wissen sollten, verkünden, dass uns gerade der Himmel auf den Kopf fällt, stellt er einige sehr vernünftige Denkansätze für die Regulierung Künstlicher Intelligenz vor.

Heute berichtet MarketWatch, Roboter würden in zehn bis zwanzig Jahren etwa die Hälfte aller Menschen von ihren Arbeitsplätzen verdrängen, und präsentiert sogar eine Grafik, die diese Zahlen belegen soll.

Diese Behauptungen sind aberwitzig. (Ich versuche, mich seriös auszudrücken, aber was zu viel ist…) Die Autoren scheinen davon überzeugt zu sein, dass sich die Zahl der Beschäftigten im Grünflächendienst und der Gebäudepflege in den Vereinigten Staaten von gegenwärtig einer Million in zehn bis zwanzig Jahren auf 50.000 verringern wird, weil Roboter diese Arbeitsplätze übernehmen werden. Wie viele Roboter werden derzeit für solche Tätigkeiten eingesetzt? NULL. Wie viele ernstzunehmende Demonstrationen von Robotern für diesen Bereich gab es bisher? NULL. Ähnliches gilt für sämtliche anderen Berufsfelder, in denen der Grafik zufolge 90 oder sogar 97 Prozent der Menschen, auf deren physische Anwesenheit es heute noch ankommt, ihre Arbeitsplätze verlieren werden.

Falsche Voraussagen wecken Furcht vor Dingen, die gar nicht passieren werden. Wie kommt es zu solchen Fehlern in Prognosen über die Zukunft der KI und der Robotik, die Oren Etzioni, ich und ein paar andere dann ausräumen müssen?

Im Folgenden skizziere ich sieben Argumentationsweisen, die zu falschen Voraussagen über die Robotik und die KI führen. Beispiele für diese fehlerhaften Argumentationen tauchen in vielen Prognosen über unsere Zukunft mit Künstlicher Intelligenz auf. Ich beschreibe zunächst vier große Themenfelder, für die falsche Prognosen kursieren, und skizziere kurz den Stand der Forschung in diesen Bereichen.

A. Starke Künstliche Intelligenz („Artificial General Intelligence“).

Die Forschung zur starken KI versucht zu ergründen, wie sich eine denkende Einheit von aktuell verfügbaren KI-Technologien, wie dem maschinellen Lernen, unterscheiden müsste. Die Grundidee dabei ist, dass wir in der Lage sein werden, autonome Agenten zu bauen, die sich ähnlich wie natürliche Geschöpfe in der Welt bewegen werden. Dies war schon immer mein Antrieb, im Bereich Robotik und KI zu arbeiten, doch die jüngsten Erfolge der KI-Forschung sind noch weit von diesen Zielen entfernt.

Manche Menschen glauben, jede Art von KI sei zugleich eine Erscheinungsform der starken Künstlichen Intelligenz, doch wie das Wort „general“ in der englischen Bezeichnung bereits zeigt, strebt die Forschung zur starken Künstlichen Intelligenz nach grundsätzlicheren Erkenntnissen als wir sie gegenwärtig besitzen. Betrachtet man die heute verfügbaren KI-Technologien als Erscheiningsformen starker Künstlichen Intelligenz, so erweckt man den Eindruck, KI sei bereits viel weiter und umfassender entwickelt als sie es in Wirklichkeit ist.

Die aktuelle Forschung zur starken KI ist von ihrem Ziel, allgemeingültige Aussagen zu treffen und eine unabhängige Einheit mit einer dauerhaften Existenz zu erschaffen, noch weit entfernt. Sie scheint sich weitgehend mit denselben logischen Problemen herumzuschlagen, mit denen die KI seit mindestens 50 Jahren kämpft. Eine Schwierigkeit besteht darin, Computer mit einem Grundwissen über die Welt, einer Art gesundem Menschverstand, auszustatten. Andere Forschungsbereiche wie Künstliches Leben und die Simulation von Anpassungsverhalten kamen in den 80er und 90er Jahren der Erschaffung eigenständiger Wesen tatsächlich näher, stecken aber seitdem fest. (In diesen beiden Forschungszusammenhängen verbrachte ich in jenen Jahren meine Zeit.)

Meiner Meinung nach ist starke KI im Prinzip selbstverständlich möglich. Ohne diese Überzeugung hätte ich nicht begonnen, im Bereich Künstliche Intelligenz zu forschen. Doch vielleicht sind wir Menschen einfach nicht klug genug, um diese Aufgabe zu lösen – siehe hierzu meine Bemerkungen zur Demut in meinem Blogartikel zum gegenwärtigen Entwicklungsstand von KI-Anwendungen für Roboter. Es ist zwar möglich, starke KI zu entwickeln, aber wir verstehen noch längst nicht, wie es geht, und ich persönlich glaube, dass wir von einem solchen Verständnis noch viel weiter entfernt sind als viele andere Experten wahrscheinlich behaupten würden.

(Manche Menschen sprechen von „einer KI“, als gehe es stets darum, einen autonomen Agenten zu erschaffen. Ich halte das für verwirrend, und ebenso wie die Einheimischen in San Francisco ihre Stadt nicht „Frisco“ nennen, wird kein ernstzunehmender KI-Forscher von „einer KI“ sprechen.)

B. Die Singularität

Hier geht es um die Idee, dass die Entwicklung der KI irgendwann eine intelligente Einheit mit eigenen Zielen und Zwecken hervorbringen wird, die uns Menschen in der KI-Forschung überflügelt. Ab diesem Zeitpunkt, so der Gedanke, werde sich die KI selbständig weiterentwickeln. Die Verfechter dieser Vorstellung gehen außerdem davon aus, dass Computer schneller und schneller werden, weil Moores Gesetz unbegrenzt gilt. Und ebenso wenig wie die spekulative Physik die physikalischen Gegebenheiten der Singularität im Inneren eines Schwarzen Lochs definieren kann, wissen wir, wie sich die Dinge nach dem Eintreten der technologischen Singularität entwickeln werden.Menschen, die an die Singularität „glauben“, schreiben der KI allzu gern unglaubliche Kräfte zu, die sie in jener unvorhersehbaren Zukunft nach dem Eintreten der Singularität entfalten wird. Ich habe das Wort „glauben“ in Anführungsstriche gesetzt, weil der Glaube an die Singularität häufig wie ein religiöser Glaube anmutet. Manche knüpfen daran außerdem noch die frohe Erwartung, dass sie ihren Geist künftig auf einen intelligenten Computer hochladen können und auf diese Weise das ewige Leben erlangen, ohne sich mit gängigen Vorstellungen von einer übernatürlichen Gottheit herumschlagen zu müssen. Die allmächtige, technologiebasierte KI ist ihr neuer Gott. Eine Techno-Religion!

Manche Leute glauben, den Tag ihrer Errettung bereits zu kennen – die Anhänger eines bestimmten Propheten der Singularität sind sicher, dass es im Jahr 2029 so weit sein wird, ganz wie es geschrieben steht.

Dieser spezielle prognostische Irrtum gründet auf der Überzeugung, dass sich Computertechnik exponentiell entwickelt. Ich werde den „Exponentialismus“ als einen der sieben häufigen Denkfehler analysieren.

Trotz unserer leistungsfähigen Computer stehen wir keineswegs kurz vor der Entwicklung von Programmen, die Künstliche Intelligenz erforschen und ihren eigenen Code immer weiter verbessern können.

Was Programme betrifft, die Quelltext analysieren können, sind wir auf folgendem Stand: Derzeit gibt es keine Software, die ein Programm so gut analysiert wie ein Informatikstudent im ersten Semester, der seit einem Monat programmieren lernt. Wir sind also noch sehr weit davon entfernt, dass KI-Systeme bessere KI-Systeme entwickeln als Menschen.

Und wie gut sind wir darin, neuronale Strukturen des Gehirns zu simulieren? Dies ist die zweite Methode, auf die sich die Anhänger der Singularität häufig berufen. Seit ca. dreißig Jahren kennen wir den gesamten „Schaltplan“ der 302 Nervenzellen des Wurms C. elegans, inklusive aller 7000 Verknüpfungen zwischen ihnen. Dieses Wissen erweist sich als ungeheuer wertvoll für ein Verständnis des Zusammenwirkens von Verhalten und Neuronen. Es ist allerdings das Ergebnis dreißigjähriger Forschungsanstrengungen, in deren Rahmen hunderte Wissenschaftler sich über die geringe Zahl von 302 Nervenzellen den Kopf zerbrachen. Und wie das OpenWorm Projekt vermeldet, ist der Versuch, zunächst die neuronale und muskuläre und später die gesamte Zellstruktur von C. elegans zu simulieren, noch nicht einmal zur Hälfte gelungen. Um ein menschliches Gehirn mit 100 Milliarden Nervenzellen und einer riesigen Zahl von Verknüpfungen zu simulieren, müssen wir noch einen sehr weiten Weg zurücklegen. Wenn Sie sich also auf die Singularität verlassen, weil Sie vorhaben, Ihren Geist in eine Gehirnsimulation einzuspeisen, schlage ich vor, dass Sie sich mit dem Sterben noch ein paar Jahrhunderte Zeit lassen.

Sollte meine eigene Position zur Singularität nicht hinreichend klar geworden sein, so verweise ich auf meine Kommentare in der Zeitschrift IEEE Spectrum, die regelmäßig einen Themenschwerpunkt zur Singularität veröffentlicht. Hier das Dossier von 2008. Beachten Sie die Tabelle mit Standpunkten und Aussagen wichtiger Forscher. Und hier das Dossier von 2017, das ebenfalls Standpunkte und Aussagen wichtiger Forscher in Themenkästen präsentiert. Ich gebe zu, ich habe mich 2017 zu ein paar bissigen Kommentaren hinreißen lassen …

C. Falsche Wertvorstellungen.

Die dritte Gruppe von Zukunftsszenarien setzt voraus, dass KI-basierte Maschinen extrem gut gerüstet sein werden, bestimmte Aufgaben in einer komplexen Welt zu bewältigen, geradezu übermenschlich gut. Dabei teilen sie unsere menschlichen Werte nicht, und das führt zu allen möglichen Problemen.

In einigen Bereichen könnte sich solche Befürchtung meiner Meinung nach bewahrheiten – wenn ich mir ein Flugticket in eine bestimmte Stadt kaufe, so zeigen plötzlich alle durch Werbeeinnahmen finanzierten Webseiten, die ich aufrufe, Werbung für Flüge in eben dieser Stadt. Das ist natürlich dumm. Ich halte es aber nicht für ein Symptom einer unglaublich leistungsfähigen Intelligenz. Es ist eher ein Beispiel für schlecht programmierte Evaluationsfunktionen in den Algorithmen, die bestimmen, wer welche Werbung sieht.

Hier jedoch ein Zitat eines Verfechters dieser Art von Zukunftsszenarien (ich bin großmütig und wahre seine Anonymität):

Das bekannte Beispiel mit den Büroklammern zeigt, worum es geht: Wenn das einzige Ziel einer Maschine darin besteht, die Zahl der Büroklammern zu maximieren, könnte sie unglaubliche Technologien erfinden, um die gesamte verfügbare Masse des erreichbaren Universums in Büroklammern zu verwandeln; dennoch bleiben ihre Entscheidungen einfach dumm.

Einspruch, Euer Ehren. Niemals, unter keinen denkbaren Umständen in der realen Welt, wird eine Situation eintreten, in der ein solches Programm existieren könnte. Ein Programm, das klug genug ist, die menschliche Gesellschaft zu zerrütten, um seine von Menschen festgelegten Ziele zu erreichen, ohne jedoch zu verstehen, welche Schwierigkeiten es dadurch diesen Menschen bereitet. Die Vorstellung, dass Technologie sich auf diese Weise entwickelt, ist einfach dumm (netter Ausdruck …) und basiert auf einer Kombination einiger der sieben Irrtümer, die ich im Folgenden analysiere.

Derselbe Autor hat wiederholt die Ansicht vertreten (in dem Artikel, aus dem das obige Zitat stammt, und auch auf der großen International Joint Conference on Artificial Intelligence, IJCAI, die vor einigen Wochen im australischen Melbourne stattfand), die Forschung müsse mathematisch nachweisen, dass die Ziele von KI-Systemen mit menschlichen Zielen im Einklang stünden.

Meiner Meinung nach werden die Szenarien, die ich hier unter Punkt C zusammenfasse, von Wissenschaftlern thematisiert, die in ihnen interessante Herausforderungen für die Forschung sehen. Diese Forscher werfen dann ihre Bekanntheit in die Waagschale, um der Dringlichkeit der aufgeworfenen Fragen für die Forschung Nachdruck zu verleihen. Die Mitläufer im Bereich der KI machen sie sich zu eigen, verbreiten sie und geben sie als existenzielles Problem der Menschheit aus.

Übrigens halte ich die Forderung nach mathematischen Beweisen für vergeblich. Obwohl große Teams es über viele Jahre versucht haben, können wir nicht beweisen, dass ein Programm von tausend Zeilen nicht von externen Hackern geknackt werden kann. Umso weniger werden wir in der Lage sein, irgendetwas im Zusammenhang mit großen KI-Systemen zu beweisen. Die gute Nachricht ist, dass wir Menschen Tausende von Jahren in der Lage waren, erfolgreich mit Pferden zu koexistieren und sie sogar für unsere Zwecke zu nutzen. Auch Pferde sind ja autonome Agenten mit einer dauerhaften Existenz, eigenen Wünschen und übermenschlicher Körperkraft. Und wir hatten nicht ein einziges Theorem über Pferde und haben immer noch keins!

D. Wirklich böse schreckliche gemeine menschenmordende KI-Einheiten.

Diese letzte Kategorie ähnelt dem Themenkomplex C, doch hier nimmt man an, dass mit künstlicher Intelligenz ausgestattete Maschinen von einer aktiven Abneigung gegen Menschen erfasst werden und beschließen, sie zu vernichten und aus dem Weg zu räumen.

Mindestens seit den späten 60er Jahren war dies eine beliebte Fantasie in Hollywood. Sie brachte Filme hervor wie „2001: Odyssee im Weltraum“ (Kinostart 1968, doch die Handlung spielt 2001), wo sich die von Maschinen angerichtete Verwüstung auf ein einziges Raumschiff beschränkt, und „Colossus“ (Kinostart und ungefähre Zeit der Handlung 1970), in dem der gesamte Planet von Zerstörung bedroht ist. Das Thema tauchte im Lauf der Jahre immer wieder auf. Ein neueres Beispiel ist „I, Robot“ (Kinostart 2004, Zeit der Handlung 2035). Hier erobert der böse KI-Computer VIKI die Welt mittels der neuen, humanoiden NS-5 Roboter. (Übrigens setzt dieser Film die bizarre Konvention anderer Science-Fiction-Filme fort, große komplexe Maschinen in mehrere hundert Meter hohen Räumen anzusiedeln, sodass sich die menschlichen Helden, die den guten Kampf gegen die böse gewordenen Maschinen kämpfen, großen körperlichen Gefahren aussetzen …)

Vorhersagen nach diesem Muster sind noch irregeleiteter als die Szenarien in Gruppe C. Manche Leute finden es wohl prickelnd, sich diese furchtbaren, furchtbaren Gefahren auszudenken …

In diesem Blogartikel werde ich mich nicht mit dem Problem militärischer Killerroboter auseinandersetzen – dieses Thema wird von der Presse häufig mit dem Themenkomplex D vermengt und leider auch von Menschen benutzt, die mit den beschriebenen Szenarien Angst schüren wollen. Die beiden Themen haben nichts miteinander zu tun. Außerdem halte ich viele Argumente in der Debatte um militärische Roboter für falsch. Doch dies ist ein ganz anderes Thema und soll in einem eigenen Blogartikel behandelt werden.

Nun zu den sieben Denkfehlern, die meiner Meinung nach häufig vorkommen. Sie alle beeinflussen die Einschätzung des Zeitrahmens und der Wahrscheinlichkeit für die Szenarien A, B, C und D. Einige Denkfehler spielen bei bestimmten Zukunftsszenarien eine größere Rolle als andere. In den Überschriften habe ich angegeben, in welchem Bereich ein bestimmter Denkfehler meiner Meinung nach den größten Schaden anrichtet. Der erste Fehler wirkt sich allerdings überall verheerend aus.

I. Über- und Unterschätzen

Roy Amara war Futurist sowie Mitbegründer und Präsident des Institute for the Future in Palo Alto, wo neben der Stanford Universität zahllose Risikokapitalgeber ansässig sind und das intellektuelle Herz des Silicon Valley schlägt. Er ist vor allem durch ein Postulat bekannt geworden, das man inzwischen als „Amaras Gesetz“ kennt:

Wir neigen dazu, die kurzfristigen Auswirkungen einer Technologie zu überschätzen und die langfristigen Auswirkungen zu unterschätzen.

Diese 16 Worte, die leicht in einen Tweet passen und unterschiedlich ergänzt und ausgelegt werden können, haben es in sich. Ein Optimist kann sie vollkommen anders deuten als ein Pessimist. Einen Optimisten sollten sie ein wenig pessimistisch stimmen, einen Pessimisten dagegen vorsichtig optimistisch, zumindest für eine Weile, bevor jeder von ihnen zu seinen angestammten Denkgewohnheiten zurückkehrt.

Ein beeindruckendes Beispiel für die beiden Seiten von Amaras Gesetz ist das Global Positioning System (GPS) der Vereinigten Staaten, dessen Entwicklung wir seit dreißig Jahren beobachten können.[i] 1978 wurde der erste von insgesamt 24 Satelliten (30, wenn man die Ersatzsatelliten einrechnet) in die Erdumlaufbahn gebracht. Sobald eine Bodenstation vier dieser Satelliten gleichzeitig erfasst, kann sie ihre Koordinaten sowie, nach einem bestimmten Höhenbezugssystem, ihre Höhe über dem Meeresspiegel berechnen. Ein Operationszentrum an der Schriever Air Force Base in Colorado kontrolliert ständig die präzisen Umlaufbahnen der Satelliten und die Genauigkeit der Atomuhren an Bord. Es übermittelt kontinuierlich Anweisungen für geringfügige Korrekturen. Ohne diese Korrekturen könnte GPS schon nach ein, zwei Wochen nicht mehr Ihre korrekte Position auf einer bestimmten Straße in einer Stadt erfassen. Nach einigen Monaten könnte es nicht einmal mehr die Stadt angeben, in der Sie sich befinden.

GPS sollte es dem US-Militär ermöglichen, Bomben präzise auf bestimmte Ziele abzuwerfen. So lautete die Erwartung, die an das System gestellt wurde. 1991 wurde es während der Offensive „Desert Storm“ erstmalig zu diesem Zweck eingesetzt. Die Ergebnisse erschienen vielversprechend. Doch während der 90er gab es noch viele Misstrauen gegenüber GPS, da es die Versprechen der frühen Entwicklungsphase nicht einlöste. Erst in den frühen 2000er Jahren war sein Nutzen innerhalb der US-Streitkräfte allgemein anerkannt. Es dauerte also lange, bis GPS die Erwartungen der Frühphase einlöste, und das gesamte Programm wäre mehr als einmal beinahe gestrichen worden.

Heute ist GPS auf lange Sicht aus unserer Welt nicht mehr wegzudenken. Seine vielfältigen Anwendungen konnte sich niemand vorstellen, als die ersten Satelliten in die Erdumlaufbahn gebracht wurden. Meine Apple Watch Series 2 nutzt GPS, um mich zu lokalisieren, während ich jogge, und erkennt sogar, auf welcher Straßenseite ich laufe. Die Winzigkeit und der extrem günstige Preis des Empfängers hätten den Ingenieuren in der Frühphase von GPS Rätsel aufgegeben. GPS hat heute unzählige Anwendungen, an die seine Entwickler nie dachten. Es bestimmt das Timing von Physikexperimenten überall auf der Welt und ist inzwischen elementar für die Synchronisierung und das Funktionieren des US-amerikanischen Stromnetzes. Es bewahrt in der Regel die Hochfrequenzhändler, die in Wahrheit die Aktienmärkte kontrollieren, vor katastrophalen Fehlern beim Timing ihrer Geschäfte. All unsere Flugzeuge, große wie kleine, nutzen es für die Navigation, es wird verwendet, um Straftäter auf Bewährung zu lokalisieren, und es legt an vielen Orten weltweit fest, welche Variante eines bestimmten Saatguts auf welchem Teil eines Feldes ausgesät wird. Es verfolgt die Bewegungen von LKW-Flotten und übermittelt Informationen über die Leistung der Fahrer. GPS-Signale die vom Erdboden abprallen, geben Aufschluss über dessen Feuchtigkeit und steuern dadurch Bewässerungspläne.

Am Anfang sollte GPS einem bestimmten Ziel dienen, doch es erwies sich als äußerst schwierig, es für die ursprünglichen Zwecke zu optimieren. Nun ist es in so viele Aspekte unseres Lebens eingedrungen, dass wir ohne es nicht nur orientierungslos wären, sondern auch kalt, hungrig und wahrscheinlich sogar tot.

Die Entwicklung anderer Technologien im Verlauf der vergangenen dreißig Jahre zeigt ein ähnliches Muster: zuerst ein große Verheißung, dann Enttäuschung und schließlich Vertrauen, das langsam wächst, bis die ursprünglichen Erwartungen sogar übertroffen werden. Dies gilt für die Blockchain (die erste Anwendung war Bitcoin), die Sequenzierung individueller menschlicher Genome, die Solarenergie, die Windkraft und sogar für Lieferdienste, die Lebensmittel ins Haus bringen.

Das frappierendste Beispiel sind vielleicht die Computer selbst. Als in den fünfziger Jahren die ersten Computer auf den Markt kamen, war die Furcht weit verbreitet, dass sie die Menschen von sämtlichen Arbeitsplätzen verdrängen würden (siehe z.B. der Film „Eine Frau, die alles weiß“ aus dem Jahr 1957). Doch während der folgenden dreißig Jahre beeinflussten Computer den Alltag nur wenig, und noch 1987 gab es kaum Mikroprozessoren in Konsumergeräten. Dies alles veränderte sich während der zweiten Entwicklungsphase in den nächsten dreißig Jahren, und heute schmücken wir unsere Körper mit Computern und unsere Autos und Häuser sind voll von ihnen.

Um zu verstehen, wie konsequent die langfristigen Auswirkungen der Computertechnologie unterschätzt wurden, muss man sich nur Darstellungen in alten Science-Fiction-Filmen oder TV-Sendungen über die Zukunft anschauen. Als Raumschiff Enterprise 1966 ins Fernsehen kam, sollte die Serie die Zukunft in 300 Jahren zeigen, doch der Bordcomputer war schon dreißig Jahre später eine altmodische Lachnummer. Und in „Raumschiff Enterprise – Das nächste Jahrhundert“ und der Nachfolgeserie „Star Trek: Deep Space Nine“, die in den Jahren 1986 bis 1999 produziert wurden, mussten große Datenmengen noch von Menschen durch das Raumschiff oder die Raumstation getragen werden, weil sie nicht durch das Netzwerk verschickt werden konnten (es ähnelte dem AOL-Netz jener Tage). Die Datenbestände, in denen Menschen nach Informationen suchen konnten, waren spärlich, und die Suchmaschinen der Zukunft wussten noch nichts vom Web.

Kurzfristig werden die meisten Technologien überschätzt. Anfangs erscheinen sie verheißungsvoll und neu. Das Besondere im Fall der KI ist, dass sie mehrfach als das Neueste vom Neuen galt und überschätzt wurde, in den 60er Jahren, in 80er Jahren und heute meines Erachtens erneut. (Einige große Unternehmen verbreiten wirklich irreführende Werbebotschaften über ihre KI-Produkte. Das könnte ihnen in nicht allzu ferner Zeit empfindlich schaden.)

Zwar werden die langfristigen Auswirkungen nicht bei allen Technologien unterschätzt, doch bei der KI ist dies wahrscheinlich der Fall. Die Frage ist, was „langfristig“ hier bedeutet, wie lange es also dauert, bis die KI ihr Potential entfaltet und die Erwartungen übertrifft. Die sechs Denkfehler, die ich im Folgenden analysiere, tragen dazu bei, dass diese Zeitspanne extrem unterschätzt wird.

Sünde 1 “Das Über- und Unterschätzen” hat einen Einfluss darauf, wie man den Zeitrahmen und die Wahrscheinlichkeit dieser Szenarien einschätzt:

A. Starke Künstliche Intelligenz („Artificial General Intelligence“).

B. Die Singularität.

C. Falsche Wertvorstellungen.

D. Wirklich böse schreckliche gemeine menschenmordende KI-Einheiten.

II. Magische Vorstellungen

Während meiner Teenagerzeit war Arthur C. Clarke einer der „drei großen“ Science-Fiction-Autoren, neben Robert Heinlein und Isaac Asimov. Doch Clarke war mehr als ein Science-Fiction-Schriftsteller. Er war auch Erfinder, Wissenschaftsautor und Futurist.

Im Februar 1945 erläuterte er in einem Brief an die Zeitschrift Wireless World[i] die Idee, geostationäre Satelliten für die Forschung einzusetzen, und im Oktober desselben Jahres beschrieb er in einem Aufsatz[ii], wie diese Satelliten einen weltweiten Radioempfang ermöglichen könnten. Seine Kurzgeschichte „Der Wächter“ aus dem Jahr 1948 enthält die Grundidee für Stanley Kubricks Filmepos über Künstliche Intelligenz „2001: Odyssee im Weltraum“. Zeitgleich mit den Dreharbeiten verfasste Clarke ein Buch mit demselben Titel. Darin erklärte er vieles, das für das Filmpublikum rätselhaft blieb.

In den Jahren 1962 bis 1973 formulierte Clarke drei Regeln, die als die drei „Clarkeschen Gesetze“ bekannt werden sollten (Clarke erklärte, da Newton nur drei Gesetze formuliert habe, seien auch ihm drei genug):

- Wenn ein angesehener, doch älterer Wissenschaftler etwas für möglich hält, so hat er mit an Sicherheit grenzender Wahrscheinlichkeit recht. Behauptet er hingegen, etwas sei unmöglich, so irrt er sich höchstwahrscheinlich.

- Die einzige Möglichkeit, die Grenzen des Möglichen auszuloten, besteht darin, ein wenig über sie hinaus ins Unmögliche vorzustoßen.

- Jede hinreichend weit entwickelte Technologie ist von Magie nicht zu unterscheiden.

Vielleicht sollte mich der zweite Satz seines ersten Gesetzes stutzig machen, denn in meiner Einschätzung des Tempos, mit dem die KI sich durchsetzen wird, bin ich skeptischer und zurückhaltender als andere. Hier möchte ich mich jedoch zu Clarkes drittem Gesetz äußern.

Stellen wir uns vor, wir besäßen eine Zeitmaschine (ebenfalls ein mächtiges magisches Ding …) und wir könnten Isaac Newton aus dem späten 17. Jahrhundert in die Kapelle des Trinity College der Universität Cambridge befördern. Zu Newtons Zeit war die Kapelle bereits 100 Jahre alt. Deshalb wäre sein Schock nicht allzu groß, wenn er sich in ihr wiederfände. Er wüsste nicht, welches Jahr wir gerade schreiben.

Zeigen Sie Newton nun ein Apple Gerät. Ziehen Sie ein iPhone aus der Tasche, schalten Sie es ein, so dass das Display voller Icons leuchtet, und reichen Sie es ihm. Der Mann, der bewies, dass weißes Licht sich aus Lichtstrahlen unterschiedlicher Farbe zusammensetzt, indem er das Sonnenlicht mit einem Prisma aufgefächerte und die Strahlen dann wieder zusammenführte, wäre zweifellos überrascht, weil ein so kleiner Gegenstand im Dunkel der Kapelle so lebhafte Farben hervorbringt. Spielen Sie ihm nun eine Filmszene über das ländliche England vor, vielleicht mit ein paar Tieren, die er kennt – nichts darf verraten, dass es ihn in die Zukunft verschlagen hat. Spielen Sie als nächstes Kirchenmusik ab, die er kennt. Und dann zeigen Sie ihm eine Webseite mit den über 500 Seiten der Ausgabe seines Meisterwerkes „Principia“, die er persönlich mit Anmerkungen versehen hat, und bringen Sie ihm bei, wie er Details heranzoomen kann, indem er Daumen und Zeigefinger auseinanderzieht.

Wäre Newton in der Lage, auch nur ansatzweise zu erklären, wie dieses kleine Gerät all dies bewerkstelligt? Newton entwickelte die Infinitesimalrechnung und erläuterte die Grundlagen der Optik und der Schwerkraft, doch Chemie und Alchemie stellten ihn vor unlösbare Rätsel. Deshalb vermute ich, er wäre verblüfft und unfähig, das Gerät auch nur ansatzweise zu erklären. Für ihn wäre es nichts anderes als die Verkörperung des Okkulten – etwas, das ihn Zeit seines Lebens sehr interessiert hat. Das Gerät wäre für ihn von Magie nicht zu unterscheiden. Und vergessen Sie nicht, welch ein kluger Kopf Newton war.

Wenn etwas magisch ist, so sind die Grenzen seiner Möglichkeiten schwer zu erfassen. Nehmen wir nun an, dass wir Newton noch zeigen, wie das Gerät das Dunkel erhellt, dass es Fotos und Filme machen und Geräusche aufnehmen kann, dass es als Vergrößerungsglas und als Spiegel dienen kann. Dann zeigen wir ihm, wie unglaublich schnell es Rechenaufgaben bis auf viele Stellen hinter dem Komma löst. Und wir zeigen ihm, wie es seine Schritte zählt, während er es trägt.

Welche anderen Fähigkeiten würde Newton dem Gerät wohl zuschreiben? Käme er auf die Idee, dass er damit sofort von seinem Standort in der Kapelle mit Menschen überall auf der Welt sprechen kann? Ein Prisma funktioniert in alle Ewigkeit. Würde Newton annehmen, dass ein iPhone ewig so funktioniert wie in diesem Moment? Würde ihm die Tatsache entgehen, dass es aufgeladen werden muss (bedenken Sie, dass wir ihn aus einer Zeit hundert Jahre vor der Geburt Michael Faradays entführt haben, als Elektrizität noch unerforscht war). Wenn das Gerät Licht ohne Feuer erzeugt, könnte es dann nicht auch Blei in Gold verwandeln?

Vor solchen Problemen stehen wir alle, wenn wir uns Technologien der Zukunft vorstellen. Unterscheiden sie sich stark genug von den Technologien, die wir heute nutzen und verstehen, dann kennen wie ihre Grenzen nicht. Sie lassen sich von Magie nicht unterscheiden.

Überschreitet eine Technologie diese magische Linie, so sind Aussagen über sie nicht mehr widerlegbar, denn es handelt sich ja um Magie.

Wenn ich mit Leuten darüber diskutiere, ob wir starke KI an sich oder, schlimmer noch, die Szenarien unter C oder D fürchten müssen, stoße ich regelmäßig auf dieses Problem. Man hält mir entgegen, ich verstünde nicht, wozu starke KI in der Lage sein wird. Das ist kein Argument. Wir wissen gar nicht, ob es starke KI überhaupt geben kann. Alle empirischen Ergebnisse, die ich kenne, weisen darauf hin, dass wir noch keine praktikable Idee haben, wie wir ein starkes KI-System bauen können. Die Eigenschaften starker KI sind daher vollständig unbekannt. Wenn wir über sie sprechen, erscheint sie deshalb rasch magisch und übermächtig. Grenzenlos.

Nichts im Universum ist grenzenlos. Nicht einmal die magische KI der Zukunft.

Vorsicht vor Argumenten, die künftige Technologien als magisch erscheinen lassen. Solche Argumente lassen sich nicht widerlegen. Sie entspringen Glaubensüberzeugungen, nicht der Wissenschaft.

Sünde 2 “Magische Vorstellungen” haben Einfluss darauf, wie man die Eintrittswahrscheinlichkeit und den Zeitrahmen dieser Szenarien einschätzt:

B. Die Singularität.

C. Falsche Wertvorstellungen.

D. Wirklich böse schreckliche gemeine menschenmordende KI-Einheiten.

III. Konkrete Leistung versus generelle Kompetenz

Wir alle lernen, die Fähigkeiten verschiedener Menschen einzuschätzen, mit denen wir zu tun haben. Das gehört zu unserer sozialen Kompetenz. Manchmal allerdings wird unser Urteilsvermögen dadurch außer Kraft gesetzt oder getrübt, dass wir Menschen als „die anderen“ wahrnehmen. Niederträchtige Gesinnungen wie Rassismus, Sexismus, Klassendünkel etc. haben hier ihre Wurzeln. Gemeinhin ziehen wir jedoch aus der Art, wie jemand eine bestimmte Aufgabe löst, Schlüsse darauf, wie gut diese Person eine andere Aufgabe meistern würde. Wenn wir jemanden beim Lösen einer Aufgabe beobachten, sind wir in der Lage zu verallgemeinern und auf die Kompetenz dieser Person in einem viel größeren Aufgabenfeld zu schließen. Uns ist intuitiv klar, wie wir ausgehend von der konkreten Leistung auf die Kompetenz in verwandten Bereichen schließen können.

Wenn wir in einer fremden Stadt einen Unbekannten auf der Straße nach dem Weg fragen und er uns in derselben Sprache antwortet und uns mit einigem Selbstvertrauen auf anscheinend sinnvolle Weise den Weg beschreibt, dann gehen wir auch das Risiko ein, ihn zu fragen, wie man in dieser Stadt eine Busfahrkarte kauft.

Wenn unsere Tochter oder unser Sohn im Teenageralter in der Lage ist, eine neue Spielekonsole mit dem WLAN des Haushalts zu verbinden, dann vermuten wir, dass unser Kind bei entsprechender Motivation auch fähig sein wird, uns zu helfen, unseren neuen Tablet-Computer an das Netzwerk anzuschließen.

Wenn wir sehen, dass jemand ein Auto mit manueller Schaltung fahren kann, sind wir ziemlich sicher, dass die Person in der Lage sein wird, einen Automatikwagen zu fahren. Kommt die Person allerdings aus Nordamerika, ist der Umkehrschluss vielleicht nicht gerechtfertigt.

Wenn wir einen Mitarbeiter in einem großen Baumarkt fragen, wo sich ein gesuchtes Produkt befindet, z.B. ein Elektrobauteil für unser Eigenheim, und derjenige uns zu den Gartengeräten schickt, so werden wir wahrscheinlich nicht zurückkehren, um genau dieselbe Person zu fragen, wo wir eine Badezimmerarmatur finden. Wir werden vermuten, dass die Person nicht nur keine Ahnung hat, wo sich Steckdosen, Lichtschalter u.ä. befinden, sondern die Anordnung des Gesamtsortiments nicht kennt, und wir werden uns nach jemand anderem umsehen, dem wir unsere zweite Frage stellen können.

Betrachten wir nun ein Beispiel, das mehr mit bestimmten Leistungen heute verfügbarer KI-Systeme zu tun hat.

Nehmen wir an, jemand erzählt uns, ein Foto zeige Menschen, die in einem Park Frisbee spielen. Wir setzen dann selbstverständlich voraus, dass diese Person Fragen beantworten kann wie z.B.: „Wie ist eine Frisbee geformt?“, „Wie weit kann ein Mensch eine Frisbee ungefähr werfen?“, „Kann ein Mensch eine Frisbee essen?“, „Wie viele Menschen ungefähr spielen gleichzeitig mit der Frisbee?“, „Kann ein Mensch im Alter von drei Monaten mit einer Frisbee spielen?“, „Eignet sich das Wetter heute, um Frisbee zu spielen?“; von einer Person aus einem anderen Kulturkreis, die erklärt, sie habe keine Ahnung, was auf dem Bild geschieht, würden wir dagegen keine Antworten auf all diese Fragen erwarten. Heutige Systeme zur Bildanalyse, die Fotos im Netz routinemäßig mit zutreffenden Beschreibungen wie „Menschen spielen in einem Park Frisbee“ versehen, haben keine Möglichkeit, diese Fragen zu beantworten. Abgesehen von der Tatsache, dass sie ausschließlich Bilder benennen und keine Fragen beantworten können, haben sie keine Vorstellung davon, was ein Mensch ist, dass Parks sich in der Regel draußen befinden, dass Menschen ein Alter haben, dass Wetter aus mehr besteht als den Lichtverhältnissen auf einem Foto usw. usw.

Das macht solche Systeme keineswegs nutzlos. Für Betreiber von Suchmaschinen sind sie von großem Wert, denn mithilfe korrekter Bildbenennungen können Suchmaschinen als Suchergebnis für bestimmte Begriffe auch Bilder präsentieren. In diesem Zusammenhang ist außerdem wichtig, dass Suchmaschinen in der Regel viele unterschiedliche Antworten auf eine Suchanfrage liefern und es dem Nutzer überlassen, die vorderen Ergebnisse zu prüfen und zu entscheiden, welche von ihnen relevant sind. Die Betreiber von Suchmaschinen bemühen sich, ihre Systeme so zu optimieren, dass das beste Ergebnis möglichst unter den ersten fünf erscheint. Sie vertrauen jedoch auf die kognitiven Fähigkeiten der menschlichen Nutzer, und deshalb muss die passende Antwort nicht stets als erste erscheinen. Wenn Suchmaschinen nur eine Antwort bereithielten, z.B. nur einen Hoteltipp bei einer Suche nach „großen Hotels in Paris“ oder nur ein Bild einer „flippigen Krawatte“ bei einer entsprechenden Suche in einem Online-Vertrieb, dann wären Suchmaschinen nicht so nützlich wie sie es sind.

Hier liegt also die Fehlerquelle. Menschen erfahren, dass irgendein Roboter oder ein KI-System eine bestimmte Aufgabe gemeistert hat. Dann verallgemeinern sie und schließen von dieser konkreten Leistung auf eine generelle Kompetenz, wie sie vermutlich ein Mensch besäße, der in der Lage wäre, dieselbe Aufgabe zu lösen. Und diese Verallgemeinerung übertragen sie auf den Roboter oder das KI-System.

Die Roboter und KI-Systeme, über die wir derzeit verfügen, sind auf ein unglaublich enges Aufgabenspektrum beschränkt. Verallgemeinerungen, die bei Menschen zutreffen, sind für Roboter und KI-Systemen nicht zulässig. Menschen, die solche verallgemeinernden Schlüsse ziehen, haben nichts verstanden.

Sünde 3 “Konkrete Leistung versus generelle Kompetenz” hat Einfluss darauf, wie man die Eintrittswahrscheinlichkeit und den Zeitrahmen dieser Szenarien einschätzt:

A. Starke Künstliche Intelligenz („Artificial General Intelligence“).

B. Die Singularität.

C. Falsche Wertvorstellungen.

IV. Ein Wort – ein Koffer voller Bedeutungen

In meinem Blogartikel zur Funktionsweise selbstlernender Maschinen bin ich bereits kurz darauf eingegangen, dass manche Worte gewissermaßen einen Koffer voller Bedeutungen mit sich herumtragen. (Marvin Minsky hat für dieses Phänomen den Begriff „suitcase word“ geprägt.[4]) Dort erkläre ich, dass das Wort „lernen“ eine Vielzahl unterschiedlicher Lernformen bezeichnen kann, wenn es um Menschen geht. Denn wie ich dort ebenfalls erläutere, nutzen Menschen unterschiedliche Mechanismen, um unterschiedliche Dinge zu lernen. Wenn man lernt, mit Stäbchen zu essen, so macht man eine ganz andere Erfahrung, als wenn man die Melodie für ein neues Lied lernt. Lernt man zu programmieren, so erlebt man etwas ganz anderes als beim Kennenlernen einer neuen Stadt.

Wenn Menschen hören, das maschinelle Lernen mache große Fortschritte, und sie sich vorstellen, wie eine Maschine in einem neuen Bereich etwas lernt, dann legen sie als mentales Modell meist die Art zugrunde, in der ein Mensch sich diesen neuen Bereich erschließen würde. Maschinelles LernenMachine Learning Ein Teilbereich der KI, bei dem Systeme aus Daten lernen und sich verbessern, ohne explizit programmiert zu werden. ist jedoch sehr anfällig für Fehler und Störungen und erfordert umfangreiche Vorarbeiten durch menschliche Forscher oder Ingenieure. Die Codierung für die Verarbeitung der Inputdaten und die Auswahl der Trainingsdatensätze müssen den Lernzielen entsprechen. Für jedes neue Problemfeld muss eigens eine spezielle Lernstruktur entwickelt werden. Maschinelles Lernen ist derzeit mit menschlichem Lernen nicht vergleichbar, denn Menschen saugen Neues auf wie ein Schwamm und machen rasche Fortschritte in neuen Bereichen, ohne dass sie chirurgisch verändert oder passgerecht umgebaut werden müssten.

Zu ähnlichen Missverständnissen kommt es, wenn Menschen erfahren, dass Computer nun den Schachweltmeister (1997) oder den Weltmeister im Go (2016) schlagen können. Die Leute stellen sich in der Regel vor, der Computer „spiele“ das Spiel so wie ein Mensch es tun würde. Selbstverständlich hatten die Programme in Wirklichkeit weder eine Vorstellung davon, was ein Spiel eigentlich ist (siehe hierzu erneut meinen Blogartikel über maschinelles Lernen), noch wussten sie, dass sie selbst gerade spielten. Außerdem brauchte, wie in einem Artikel des The Atlantic erwähnt, der menschliche Spieler Lee Sedol während des jüngsten Go-Wettbewerbs lediglich ein Drittel Liter Kaffee zur Stärkung seiner Denkfähigkeit, während das KI-Programm AlphaGo als verteilte Anwendung auf mehreren Computern lief und durch ein Team von über hundert Wissenschaftlern unterstützt wurde.

Wenn Menschen ein Spiel spielen, so bringt eine kleine Veränderung der Regeln sie nicht aus dem Konzept – ein guter Spieler kann sich daran anpassen. Für AlphaGo oder Deep Blue, das Programm, das 1997 Garry Kasparov schlug, gilt das nicht.

Wenn Worte, die im menschlichen Kontext einen Koffer voller Bedeutungen mit sich herumtragen, auf Computer angewendet werden, wecken sie falsche Vorstellungen darüber, wie gut die Maschinen Aufgaben übernehmen können, die bisher Menschen bewältigen. Doch KI-Forscher und insbesondere die Pressestellen ihrer Forschungseinrichtungen legen Wert auf die Feststellung, dass eine Maschine durch ihre jüngsten Erfolge eine Fähigkeit erlangt hat, die einem Aspekt der vielfältigen Bedeutungen eines Wortes entspricht. Das wichtige Wort in diesem Zusammenhang ist „ein Aspekt“. Ganz gleich, wie vorsichtig sich Wissenschaftler ausdrücken – und unglücklicherweise sind nicht alle von ihnen besonders vorsichtig -, geht die Information, dass es sich nur um einen Aspekt handelt, in der Pressestelle oder in schlecht recherchierten Artikeln bald verloren. Schlagzeilen verkünden ein bestimmtes, vieldeutiges Wort und erzeugen dadurch in der Öffentlichkeit falsche Vorstellung über den Forschungsstand der KI und die Schwierigkeit, größere Ziele zu erreichen.

Dabei haben es viele der facettenreichen Worte, vor denen Minsky im Zusammenhang mit KI-Systemen warnt, noch gar nicht in die Schlagzeilen geschafft; Bewusstsein, Erfahrung oder Denken sind solche Worte. Wir Menschen können uns schwer vorstellen, Schach zu spielen, ohne ein Bewusstsein zu haben, das Spiel zu erleben oder über den nächsten Zug nachzudenken. Bislang hat keins unserer KI-Systeme annähernd ein Niveau erreicht, auf das sich auch nur einzelne Bedeutungsaspekte dieser Worte aus der menschlichen Sphäre anwenden lassen. Wenn wir, wie ich annehme, schließlich doch an den Punkt gelangen, an dem wir einige dieser Worte zur Beschreibung bestimmter KI-Systeme wählen, so werden die Presse und die meisten Menschen sie wieder auf unzulässige Weise verallgemeinern.

Selbst für den Fall, dass wir nur für einen kleinen Teilbereich der Bedeutung eines Wortes zeigen können, dass eine Maschine zu einer ähnlichen Leistung in der Lage ist, befürchte ich, dass die Leute wieder falsche verallgemeinernde Schlüsse ziehen werden. Sie werden denken, Maschinen seien kurz davor, in diesen Aspekten der Intelligenz menschenähnlichen Fähigkeiten zu erlangen.

Worte sind wichtig, doch jedes Mal, wenn wir eine Eigenschaft eines KI-Systems mit einem Wort beschreiben, das auch auf Menschen anwendbar ist, stellen wir fest, dass Menschen die Tragweite einer solchen Aussage überschätzen. Wenn Worte aus der menschlichen Sphäre auf Maschinen übertragen werden, so ist dies bislang bildhaft gemeint und die intendierte Bedeutung ist ein mikroskopisch kleiner Bereich dessen, was dasselbe Wort bedeutet, wenn von Menschen die Rede ist.

Hier folgen einige Verben, die zur Beschreibung von Maschinen verwendet wurden; die entsprechenden Fähigkeiten der Maschinen sind mit menschlichen Fähigkeiten in keiner Weise zu vergleichen:

voraussehen, besiegen, klassifizieren, beschreiben, einschätzen, erklären, halluzinieren, hören, sich vorstellen, beabsichtigen, lernen, entwickeln, planen, spielen, erkennen, lesen, nachdenken, reflektieren, sehen, verstehen, gehen, schreiben

All diese Worte sind in wissenschaftlichen Veröffentlichungen über Fähigkeiten von Maschinen aufgetaucht, die einzelnen, begrenzten Aspekten der Wortbedeutung in der menschlichen Sphäre entsprechen. Leider suggeriert die Verwendung dieser Worte mehr als in Wirklichkeit da ist.

Dies führt Menschen in die Irre und lässt sie die Fähigkeiten, über die Künstliche Intelligenz heute verfügt, überschätzen.

Sünde 4 “Ein Wort – ein Koffer voller Bedeutungen” hat Einfluss darauf, wie man die Eintrittswahrscheinlichkeit und den Zeitrahmen dieser Szenarien einschätzt:

A. Starke Künstliche Intelligenz („Artificial General Intelligence“).

B. Die Singularität.

V. Exponentialismus

Viele Menschen leiden unter einer schweren Form von „Exponentialismus“.

Jeder hat eine vage Vorstellung von Moores Gesetz und glaubt zu wissen, dass Computer in bestimmten vorhersehbaren Zeitabständen besser und besser werden.

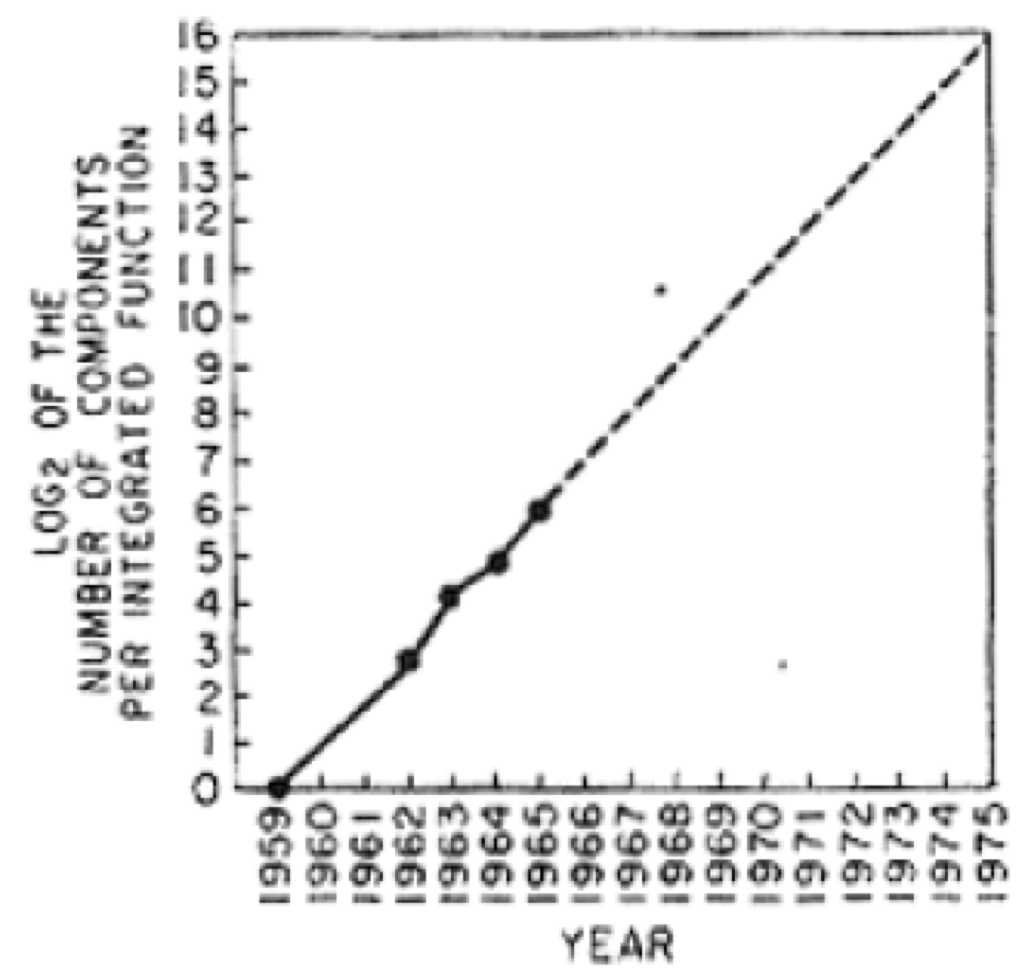

Was Gordon Moore tatsächlich gesagt hat ist, dass sich die Zahl der Komponenten, die auf einen Mikrochip passen, jedes Jahr verdoppeln wird. Ich habe im Februar einen Blogartikel über Moores Gesetz veröffentlicht, in dem ich erkläre, warum es nach gut 50 Jahren seine Gültigkeit verliert. Moore traf seine Voraussage 1965 und untermauerte sie mit der folgenden Grafik, die nur vier Datenpunkte enthält.

Er extrapolierte seine Daten nur zehn Jahre in die Zukunft, doch seine Prognose erwies sich fünfzig Jahre lang als gültig. Allerdings verlängerte sich die Zeitkonstante für die Verdopplung allmählich von einem Jahr auf über zwei Jahre. Nun läuft die Gültigkeit von Moores Vorhersage ab.

Die Verdopplung der Komponentenzahl bewirkte, dass die Rechenleistung von Computern sich wieder und wieder verdoppelte. Und sie ermöglichte Speicherchips, deren Speichervolumen sich alle zwei Jahre vervierfachte. Sie war außerdem die Grundlage für Digitalkameras mit immer höherer Auflösung und LCD-Bildschirme mit einer exponentiell wachsenden Zahl von Pixeln.

Moores Gesetz blieb gültig, weil es sich auf eine digitale Abstraktion von richtig und falsch bezog. Gab es eine elektrische Ladung oder Spannung oder nicht? Die Antwort auf diese Ja/Nein-Frage bleibt gleich, auch wenn die Anzahl der Elektronen wieder und wieder halbiert wird. Sie bleibt so lange gleich, bis die Anzahl der Elektronen durch die Halbierungen derart gering geworden ist, dass Quanteneffekte überwiegen. Diesen Punkt haben wir nun mit unseren Siliziumchips erreicht.

Moores Gesetz und vergleichbare exponentielle Gesetze können aus drei verschiedenen Gründen ihre Gültigkeit verlieren:

(a) Eine physische Grenze wird erreicht, sodass der Prozess des Halbierens/Verdoppelns nicht mehr funktioniert.

(b) Die Marktnachfrage ist weitgehend befriedigt, sodass die ökonomischen Anreize fehlen, die nötig wären, damit die reale Entwicklung weiter dem Gesetz folgt.

(c) Es handelte sich möglicherweise von vornherein nicht um einen exponentiellen Prozess.

Menschen, die an „Exponentialismus“ leiden, schieben nicht selten alle drei Gründe beiseite und glauben, die exponentiellen Prozesse, mit denen sie so gern argumentieren, wären weiterhin in Gang.

Derzeit verliert Moores Gesetz wegen Grund (a) seine Gültigkeit, doch fünfzig Jahre lang trieb es die Innovationen in der Technologieindustrie unablässig voran, beflügelte den Aufstieg des Silicon Valley und des Risikokapitals und sorgte dafür, dass einige Computerfreaks nun zu den reichsten Leuten weltweit gehören. Und heute glauben allzu viele Leute, alles in der Technologie, auch die KI, entwickle sich exponentiell.

Inzwischen weiß man sehr genau, dass exponentielle Prozesse in vielen Fällen eigentlich Teil einer „S-Kurve“ sind, dass sich also das extrem schnelle Wachstum ab einem bestimmten Punkt abschwächt. Der exponentielle Anstieg der Nutzerzahlen sozialer Plattformen wie Facebook oder Twitter muss schließlich in eine S-Kurve münden, da die Anzahl lebender Menschen, die zu neuen Nutzern werden können, begrenzt ist, weshalb das exponentielle Wachstum nicht ewig andauern kann. Dies ist ein Beispiel für Grund (b).

Es gibt jedoch noch andere Fälle. Manchmal kann die Nachfrage einzelner Nutzer für eine gewisse Zeit wie ein exponentiell ansteigender Nachfragesog erscheinen, doch irgendwann ist sie befriedigt.

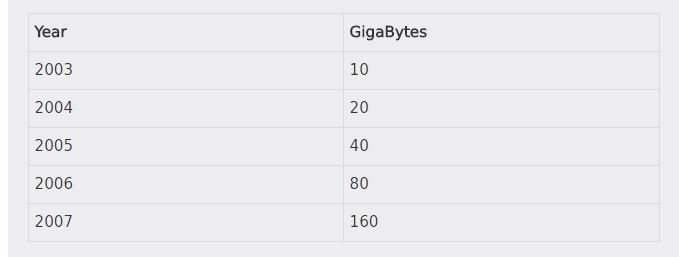

In den ersten Jahren dieses Jahrhunderts, als ich ein sehr großes Labor am M.I.T. (CSAIL) leitete und Hilfe brauchte, um Forschungsmittel für mehr als neunzig unterschiedliche Forschungsgruppen einzuwerben, versuchte ich den Sponsoren zu demonstrieren, dass die technische Entwicklung auch in Zukunft rasant voranschreiten würde. Als Beispiel wählte ich die wachsende Speicherkapazität von iPods. Anders als Gordon Moore hatte ich immerhin fünf Datenpunkte in meiner Grafik! Sie zeigte, wie viel iPod-Speicherplatz für die eigene Musik man für ca. 400 Dollar bekam. Ich vermerkte die Erscheinungsdaten der neuen Modelle, die fünf Jahre hintereinander regelmäßig im Zeitraum von Juni bis September auf den Markt kamen. Hier die Daten:

Die Daten ergaben eine perfekte exponentielle Kurve (Gregor Mendel wäre stolz gewesen…). Ich extrapolierte sie einige Jahre in die Zukunft und fragte meine Zuhörer, was wir mit all dem Arbeitsspeicher in unseren Taschen wohl anfangen würden.

Wenn ich meine Daten von damals bis zum heutigen Tag extrapoliere, dann sollte ein iPod für 400 Dollar inzwischen über einen Speicher von 160.000 Gigabytes (oder 160 Terabytes) verfügen. Doch das derzeit teuerste iPhone (es kostet mehr als 400 Dollar) hat 256 Gigabytes, nicht einmal doppelt soviel wie der iPod von 2007, während der teuerste iPod (iPod touch) nur über 128 Gigabytes verfügt, also über weniger Speicherkapazität als das Modell, das 2007, vor zehn Jahren, auf den Markt kam.

In diesem besonderen Fall brach die exponentielle Entwicklung sehr plötzlich in sich zusammen, als der Speicher so groß war, dass so gut wie jeder seine gesamte Musikbibliothek auf einem iPhone oder iPod in der Hand halten konnte. Exponentielle Entwicklungen können abbrechen, wenn die Nachfrage aufhört.

In den folgenden Jahren erlebten wir rasche Leistungszuwächse bei KI-Systemen, die durch den Erfolg von Deep Learning, einer Form des maschinellen Lernens, ermöglicht wurden. Viele Menschen scheinen deshalb auch für die Zukunft regelmäßig exponentielle Leistungsanstiege im Bereich der KI zu erwarten. Doch dem Erfolg von Deep Learning gingen dreißig Jahre Forschung voraus. Niemand war in der Lage, ihn vorherzusagen oder auch nur vorauszuahnen. Es handelte sich um ein isoliertes Ereignis.

Dies bedeutet nicht, dass es keine weiteren isolierten Ereignisse geben wird. Auch in Zukunft können wenig beachtete Bereiche der KI-Forschung plötzlich zur Triebfeder einer beschleunigten Leistungsentwicklung bei vielen KI-Anwendungen werden. Es existiert jedoch kein „Gesetz“, das angibt, wie häufig so etwas eintritt. Es gibt keinen physikalischen Prozess, wie das Halbieren der Masse des verwendeten Materials bei Moores Gesetz, der den Innovationsprozess im Bereich der KI vorantreibt. Dies ist ein Beispiel für Grund (c).

Wenn mit exponentiellen Entwicklungen argumentiert wird, um Prognosen für die Künstliche Intelligenz zu rechtfertigen, sollten Sie wissen, dass erstens nicht alle angeblich exponentiellen Prozesse tatsächlich exponentiell verlaufen und zweitens die tatsächlich exponentiellen Prozesse plötzlich abbrechen können, wenn eine physische Grenze erreicht wird oder die ökonomischen Anreize wegfallen, die den Prozess vorantreiben.

Sünde 5 “Exponentialismus” hat Einfluss darauf, wie man die Eintrittswahrscheinlichkeit und den Zeitrahmen dieser Szenarien einschätzt:

A. Starke Künstliche Intelligenz („Artificial General Intelligence“).

B. Die Singularität.

VI. Hollywoodszenarien

Viele Science-Fiction-Filme aus Hollywood spielen in einer Welt, die genauso aussieht wie unsere heute, mit Ausnahme einer einzigen neuen und überraschenden Wendung. Ein Paradebeispiel hierfür sind Filme, in denen Außerirdische die Erde besuchen. Alles ist wie immer, doch eines Tages stehen unversehens die Aliens vor der Tür.

Dass sich nur ein Aspekt der Welt verändert, erscheint bei einem Besuch von Außerirdischen logisch. Doch was, wenn es um neue Technologien geht? In der Realität entwickeln sich stets viele neue Technologien mehr oder weniger gleichzeitig.

Manche Filme bieten eine – zumindest in der Welt à la Hollywood – rationale Erklärung dafür, dass das technologische Gefüge unserer Welt nur an einer einzigen Stelle aus den Fugen gerät. In den Terminator-Filmen kam die Supertechnologie per Zeitreise aus der Zukunft. Es erübrigte sich also, die Entwicklung zu zeigen, aus der der Superroboter, der von Arnold Schwarzenegger gespielt wurde, hervorging.

In anderen Filmen jedoch kann das isolierte Auftreten einer einzigen Neuerung ein wenig dümmlich erscheinen.

In „Der 200 Jahre Mann“ wird Richard Martin, gespielt von Sam Neill, beim Frühstück von einem gehenden und sprechenden humanoiden Roboter bedient, den Robin Williams darstellt. Beim Frühstück nimmt Richard Martin eine Zeitung zur Hand. Eine Zeitung! Auf Papier gedruckt. Es gibt keinen Tabletcomputer, kein Audiogerät nach dem Vorbild von Amazon Echo, das einen Podcast abspielt, keine direkte neuronale Verbindung zum Internet.

In „Blade Runner“ will der Polizist Rick Deckard, gespielt von Harrison Ford, Kontakt mit dem Roboter Rachael aufnehmen, den Sean Young spielt. In der Filmhandlung agiert Rachael genau wie ein menschliches Wesen. Wie nimmt Deckard Kontakt zu ihr auf? Er ruft sie von einem Münztelefon aus an. Er wirft Münzen in ein Telefon – eine Merkwürdigkeit, auf die Tim Harford kürzlich in einem Blogartikel hingewiesen hat. Das Münztelefon ist eine Technologie, die viele Leser dieses Blogs vielleicht gar nicht mehr kennen. (Tim Harford merkt übrigens im selben Blockartikel an: „Die Zukunft der Technologie vorherzusagen war schon immer ein unterhaltsames aber fruchtloses Spiel.“ Eine zutreffende Einsicht.)

Dies sind zwei Beispiele für Hollywoodfilme, deren Drehbuchautoren, Regisseure und Produzenten einen humanoiden Roboter entwarfen. Sie stellten sich einen Roboter vor, der in der Lage ist, zu sehen, zu hören, sich zu unterhalten und in der Welt zu handeln wie ein Mensch – beinahe eine starke KI. Welche wundersamen Materialien und Mechanismen dabei zum Einsatz kommen, ist hier nicht von Belang. Doch diesen kreativen Menschen fehlt die nötige Vorstellungskraft oder der Wille, darüber nachzudenken, wie die Welt sich noch verändert haben könnte, während dieses Wunderwerk der Technik entwickelt wurde.

Viele Forscher und Experten im Bereich Künstliche Intelligenz, insbesondere die Pessimisten, die an die Szenarien C und D glauben, leiden offenbar an einer ähnlichen Hemmung der Vorstellungskraft.

Nicht nur der Zeitrahmen ist bei vielen Zukunftsszenarien unter Punkt C und D unrealistisch. Sie lassen auch die Tatsache außer Acht, dass die Welt sich verändern haben wird, wenn wir in der Lage sein werden, solche intelligenten Geräte zu bauen. Die Existenz solcher Superintelligenzen wird uns nicht plötzlich überraschen. Sie werden sich technologisch im Lauf der Zeit entwickeln, und wenn sie existieren, wird unsere Welt eine andere sein, es wird viele Intelligenzen geben und wir werden mit ihnen schon viel Erfahrung gesammelt haben.

Nimmt man z.B. Szenario D ernst (böse Superintelligenz will uns aus dem Weg räumen), so müssten lange vor dem Auftauchen solcher Maschinen andere, etwas weniger intelligente und feindselige Maschinen auf der Bildfläche erscheinen. Davor wiederum werden wir richtig griesgrämige Maschinen erleben. Und davor ziemlich nervige Maschinen. Und davor wiederum arrogante, unangenehme Maschinen.

Wir werden unsere Welt kontinuierlich verändern und dabei sowohl das Umfeld neuer Technologien als auch die neuen Technologien selbst abwandeln. Ich behaupte nicht, dass uns das nicht vor Herausforderungen stellen kann. Ich behaupte aber, dass diese Herausforderungen nicht so absolut unerwartet auftreten werden, wie viele Leute meinen. Wilde Schreckensphantasien helfen nicht weiter – sie werden nie eintreten, sie kommen der Wirklichkeit nicht einmal nahe.

„Hollywoodszenarien“ lassen sich rhetorisch hervorragend nutzen, doch ihnen fehlt jeder Bezug zur zukünftigen Realität.

Sünde 6 “Hollywoodszenarien” hat Einfluss darauf, wie man die Eintrittswahrscheinlichkeit und den Zeitrahmen dieser Szenarien einschätzt:

C. Falsche Wertvorstellungen.

D. Wirklich böse schreckliche gemeine menschenmordende KI-Einheiten.

VII. Tempo der Implementierung

Seit Software unser Leben in allen Bereichen prägt, lösen neue Versionen einander in manchen Wirtschaftszweigen sehr schnell ab. Fast stündlich kommen neue Features für Plattformen wie Facebook zum Einsatz. Wenn neue Features, die die Integrationstests bestanden haben, wegen eines Anwendungsproblems zurückgezogen werden müssen, ist der ökonomische Schaden oft sehr gering

– ich stelle häufig fest, dass Features, die ich auf solchen Plattformen nutze, plötzlich für eine Stunde nicht funktionieren (heute Morgen fiel z.B. das Dropdown-Menü für Facebook-Benachrichtigung aus), und ich vermute, dass diese Fehler durch die Implementierung neuer Features entstehen. Bei Softwarekomponenten, die Einkünfte generieren, indem sie z.B. Werbung platzieren, wird mehr Sorgfalt aufgewendet. Hier treten Veränderungen eher im Wochenrhythmus auf.

An dieses Tempo haben sich das Silicon Valley und die Entwickler von Internetsoftware gewöhnt. Es ist möglich, weil die Grenzkosten für die Bereitstellung neuer Software gegen Null gehen.

Die Grenzkosten für neue Hardware sind dagegen erheblich. Das wissen wir aus dem täglichen Leben. Die Mehrzahl der Autos, die wir heute kaufen, sind nicht selbstfahrend, und bei den meisten wird die Software nicht automatisch aktualisiert. (Sie sind nicht „software enabled“). Im Jahr 2040 werden diese Autos wahrscheinlich immer noch auf der Straße sein. Dieser Umstand begrenzt das Tempo, in dem selbstfahrende Autos sich durchsetzen und alle anderen PKWs verdrängen. Wenn wir heute ein neues Haus bauen, so können wir davon ausgehen, dass es in hundert Jahren noch steht. Das Haus, in dem ich wohne, wurde 1904 gebaut und ist bei weitem nicht das älteste Gebäude in meinem Viertel.

Die Investitionskosten sorgen dafür, dass physische Hardware lange Zeit in Benutzung bleibt, selbst dann, wenn sie Hightech-Komponenten enthält, und sogar, wenn sie von existenzieller Bedeutung für unser Leben ist.

Die US-Luftwaffe fliegt immer noch das Modell B-52H des B-52-Bombers. Dieses Modell wurde 1961 eingeführt, ist also 56 Jahre alt. Die letzte Maschine dieses Typs wurde 1963 gebaut, vor schlappen 54 Jahren. Derzeit geht man davon aus, dass diese Flugzeuge noch mindestens bis 2040 in Betrieb bleiben, vielleicht sogar länger – es wird erwogen, ihre Lebensdauer auf hundert Jahre zu auszudehnen (vgl. The Millenium Falcon in Star Wars!)

Die Flotte bodengestützter ballistischer Interkontinentalraketen der US-Streitkräfte (ICBM) besteht vollständig aus Raketen des Typs Minuteman III, der 1970 eingeführt wurden. Es gibt 450 solcher Raketen. Die Startanlagen funktionieren mit 8-Zoll-Diskettenlaufwerken, und ein Teil der beim Starten erforderlichen digitalen Kommunikation findet mittels analoger Festnetzverbindungen statt.

Ich entdecke regelmäßig jahrzehntealtes Gerät in Fabriken überall auf der Welt. Ich habe in Fabriken sogar PCs mit Windows 3.0 in Betrieb gesehen – eine Softwareversion, die 1990 auf den Markt kam. Die Logik dahinter ist: „Man soll nichts reparieren, was nicht kaputt ist.“ Diese PCs und die auf ihnen installierte Software führen seit mehr als zwei Jahrzehnten zuverlässig dieselben Anwendungen durch und erledigen damit die immer gleichen Aufgaben.

Die wichtigsten Kontrollmechanismen in Fabriken, und zwar auch in neuen Werken in den Vereinigten Staaten, Europa, Japan, Korea und China, basieren auf speicherprogrammierbaren Steuerungen (SPS). Sie wurden 1968 eingeführt, um elektromechanische Relais zu ersetzen. Die „Spule“ ist immer noch die wichtigste abstrakte Grundeinheit heutiger SPS. SPS-Steuerungen sind so programmiert als wären sie Netzwerke von elektromechanischen Relais mit 24-Volt-Spannung. Immer noch. Die direkte Verdrahtung wurde teilweise durch Ethernet-Kabel ersetzt. Sie ahmen ältere Netzwerke nach, die auf dem RS485 Protokoll für serielle Datenübertragung mit 8 Bit basierten. Diese Netzwerke (zu ihrer Zeit ein großer Fortschritt) wiesen selbst wiederum Züge von 24-Volt-Schaltkreisen auf. Die Ethernet-Kabel sind in den SPS nicht Teil eines offenen Netzwerks, sondern verbinden einzelne Punkte und verkörpern so physisch die Kontrollwege in diesen brandneuen uralten Steuerungen. Will man den Informationsfluss oder die Kontrollwege verändern, so dauert dies in den meisten Fabriken auf der Welt Wochen, in denen Fachleute das vorhandene System enträtseln und neue Anordnungen entwerfen. Als nächstes erneuern Handwerkerteams die Hardwareverbindungen. Einer der großen Hersteller von SPS erklärte mir kürzlich, sein Unternehmen strebe jeweils drei Software-Upgrades in zwanzig Jahren an.

Im Prinzip wären andere Lösungen möglich. In der Praxis werden sie nicht umgesetzt. Und ich spreche hier nicht nur von technologisch rückständigen Bereichen. Gerade eben habe ich Stellenangebote gelesen, und noch heute, während ich dies schreibe, sucht Tesla nach SPS-Technikern in Vollzeit für sein Werk in Fremont. Um die Produktion der Automarke mit der derzeit fortschrittlichsten KI-Software zu automatisieren, werden elektromagnetische Relais nachgeahmt.

Viele Forscher und Experten im Bereich Künstliche Intelligenz glauben, die Welt sei bereits digital und es genüge, neue KI-Systeme einzuführen, um damit unmittelbar Abläufe in der Praxis, in der Zuliefererkette, im Werk, in der Produktgestaltung, zu verändern.

Die Wirklichkeit sieht vollkommen anders aus.

Das Ausmaß, in dem Widerstände bei der Neukonfiguration der Automation Flexibilität verhindern, ist ebenso schockierend wie verblüffend.

Es ist schwer, in diesem Bereich eine gute Idee an die Frau oder den Mann zu bringen. Er verändert sich extrem langsam. Das Beispiel, in dem ein KI-System sich Ressourcen aller Art einverleibt, um auf Kosten anderer menschlicher Bedürfnisse immer mehr Büroklammern herzustellen, ist in Wirklichkeit eine verrückte Fantasie. Noch jahrzehntelang werden Menschen sich über physische Verkabelung den Kopf zerbrechen.

Fast alle Innovationen in der Robotik und der KI brauchen viel länger bis zur Marktimplementierung als KI-Experten und Laien es sich vorstellen. Selbstfahrende Autos sind ein Beispiel. Plötzlich hat jeder von ihnen gehört und glaubt, sie kämen bald auf den Markt. Das jedoch dauert länger als wir denken. Es dauert Jahrzehnte, nicht bloß Jahre. Und wenn Sie diese Aussage für pessimistisch halten, denken Sie bitte daran, dass die ersten Vorführungen solcher Autos auf der Straße nachweislich schon 30 Jahre zurückliegen und wir immer noch auf die Markteinführung warten. 1987 ließen Ernst Dickmanns und sein Team an der Universität der Bundeswehr in München einen autonom fahrenden Lieferwagen mit einer Geschwindigkeit von 90 km/h zwanzig Kilometer auf einer Schnellstraße zurücklegen. Im Juli 1995 brachte ein Team an der Carnegie Mellon University unter Leitung von Chuck Thorpe und Takeo Kanade einen Kleinbus auf die Straße, der ohne Hände am Steuer und ohne Füße auf den Pedalen die Vereinigten Staaten von Küste zu Küste durchquerte. Google/Waymo arbeitet seit acht Jahren an fahrerlosen Autos, und es zeichnet sich immer noch kein gangbarer Weg für eine breite Vermarktung ab. Möglicherweise werden seit der ersten Demonstration im Jahr 1987 vier, fünf oder gar sechs Jahrzehnte vergehen, ehe wir den Einsatz selbstfahrender Autos in der Praxis erleben.

Es dauert sehr lange, bis neue Ideen der Robotik und der KI realisiert und praktisch umgesetzt werden.

Sünde 7 ” das Tempo der Implementierung” hat Einfluss darauf, wie man die Eintrittswahrscheinlichkeit und den Zeitrahmen dieser Szenarien einschätzt:

B. Die Singularität.

C. Falsche Wertvorstellungen.

D. Wirklich böse schreckliche gemeine menschenmordende KI-Einheiten.

Epilog

Wenn Experten vor den künftigen Wundern oder Schrecken der Robotik und der Künstlichen Intelligenz warnen, so empfehle ich, ihre Argumente sorgfältig auf die hier beschriebenen sieben logischen Fehler zu untersuchen. Meiner Erfahrung nach lassen sich stets zwei, drei oder vier dieser Denkfehler in ihren Argumenten entdecken.

Es ist wirklich schwierig, die Zukunft vorherzusagen, besonders im Voraus.

[1] Pinpoint: How GPS is Changing Technology, Culture, and Our Minds, Greg Milner, W. W. Norton, 2016.

[2] “V2s for Ionosphere Research?”, A. C. Clarke, Wireless World, S. 45, Februar 1945.

[3] “Extra-Terrestrial Relays: Can Rocket Stations Give World-wide Radio Coverage”, Arthur C. Clarke, Wireless World, 305–308, Oktober 1945.

[4] The Emotion Machine: Commonsense Thinking, Artificial Intelligence, and the Future of the Human Mind, Marvin Minsky, Simon und Schuster, 2006.

Ein „Kofferwort“ ist laut Duden : eine Zusammenziehung von (meist zwei) Wörtern, die formal und/oder inhaltlich verwandt sind.

Kommentar schreiben