Tiere haben außergewöhnliche Fähigkeiten. So wie der Kater Oscar. Als Kätzchen adoptiert, wuchs er in einem US-Pflegezentrum für Demenzkranke auf. Nach einiger Zeit bemerkten die Pfleger ein besonderes Verhaltensmuster: Der Kater, der sich ansonsten nicht besonders zu Menschen hingezogen fühlte, legte sich zu Patienten, die wenige Stunden später starben. Schließlich gingen die Pfleger dazu über, die Angehörigen zu informieren, wenn sie Oscar neben einem Patienten sitzen sahen. Das klingt nach einer Urban Legend, schaffte es 2007 aber in einen Artikel im renommierten „New England Journal of Medicine“. Weltweit sorgte Oscar für Schlagzeilen, sogar ein Buch gibt es über den außergewöhnlichen Kater.

Oscar kann anscheinend etwas ziemlich gut, was Ärzte und Pfleger tagtäglich herausfordert: den Tod eines Menschen voraussehen. Seine Trefferquote ist dabei verblüffend. Ähnlich sieht es bei der Erkennung von Krankheiten wie Krebs aus. Hunde können trainiert werden, an der Atemluft eines Patienten Lungenkrebs zu erkennen. Die Ergebnisse sind besser als bei jedem gängigen Nachweisverfahren.

Worin die Fertigkeit der Tiere liegt, versuchen Forscher zu ergründen. Vermutlich sind es einzelne Moleküle oder Muster aus mehreren Molekülen in der Atemluft oder von bestimmten Körperbereichen, die die Tiere erschnüffeln können. Obgleich der genaue Mechanismus noch unklar ist – fest steht, dass das Gehirn der Tiere die komplexen Informationen aufnehmen und verarbeiten kann und daraus ein bestimmtes Ergebnis ableitet. Genauso funktionieren auch Algorithmen.

Es war lediglich eine Frage der Zeit, bis Forscher algorithmische Systeme entwickeln würden, die wie Kater Oscar den Tod vorhersagen können. Bisher haben sich dabei zwei Arten von Algorithmen herauskristallisiert, die bei kranken oder schwerkranken Patienten eingesetzt werden können:

- Algorithmen, die anhand des Zusammenspiels verschiedener Vitalparameter des Patienten, wie Herzfrequenz oder Sauerstoffsättigung im Blut, das Todesrisiko innerhalb eines Zeitfensters von wenigen Stunden berechnen – mit dem Ziel, Leben zu retten.

- Algorithmen, die anhand einer Vielzahl von Patientendaten, wie Informationen aus ärztlichen Diagnosen, den bereits durchgeführten Therapiemaßnahmen oder Medikationsplänen, das Todesrisiko innerhalb eines Zeitfensters von drei bis zwölf Monaten berechnen – mit dem Ziel, unheilbar Kranke frühzeitig von einer häuslichen Palliativversorgung profitieren zu lassen.

Unbestritten ist, dass algorithmische Systeme in beiden Fällen eine höhere Prognosequalität erreichen könnten als das Krankenhauspersonal im Durchschnitt. Auch wenn es spezielle Punktwertesysteme gibt, sogenannte Scores, die für Risiko- oder Sterbeprognosen herangezogen werden können, ist deren Treffsicherheit bisher unbefriedigend, weshalb Ärzte oder medizinisches Krankenhauspersonal sich meist auf ihre Erfahrungen verlassen.

Im Laufe seines Berufslebens sieht ein Arzt oder ein Pfleger Hunderte oder gar Tausende von Patienten. Doch das Wissen, auf welcher Erfahrung eine Entscheidung für eine Behandlung basiert, lässt sich nur schwer teilen. Anders ist das bei einer Software, bei der die Datenbasis stets abrufbar ist und fortlaufend erweitert wird.

Sei es also, um Vermeidbares frühzeitig vorherzusagen und Leben zu retten oder um Unvermeidbares akkurat vorherzusehen und Schwerkranken so den Zugang zu einem menschenwürdigen Sterben zu verbessern: Mithilfe von Algorithmen können Ärzte zum einen eine Entscheidung fällen, die zusätzlich zu ihren subjektiven Erfahrungswerten auf objektiven Parametern beruht. Zum anderen kann der Einsatz von Algorithmen Entscheidungsprozesse etwa in Krankenhäusern systematisieren.

So sinnvoll solche Systeme sein mögen: Eine Software, die Hinweise auf den bevorstehenden Tod erkennt, bereitet vielen Menschen großes Unbehagen. Das gilt insbesondere für das zweite Fallbeispiel: wenn der Tod also im Grunde unausweichlich ist und der Patient mit hoher Wahrscheinlichkeit nicht mehr gerettet werden kann, sondern es nur noch um ein begrenztes Zeitfenster geht. Auch der Krebsmediziner und Buchautor Siddhartha Mukherjee bringt das Unbehagen in seinem Essay zum Ausdruck. Es gibt also zahlreiche offene Fragen, die zu klären, und gesellschaftliche Aspekte, die zu diskutieren sind, bevor solche Algorithmen tatsächlich zum Einsatz kommen sollten.

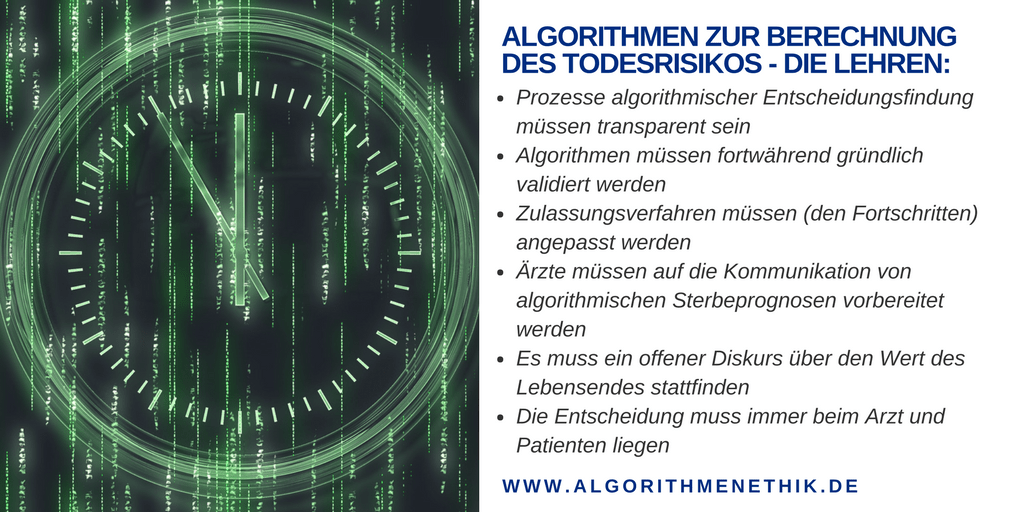

Prozesse algorithmischer Entscheidungsfindung müssen transparent sein:

In den USA machen derzeit zwei „Todes-Algorithmen“ von sich Reden, die voraussagen können, ob ein Schwerkranker innerhalb der nächsten drei bis zwölf Monate stirbt (siehe unser Blogbeitrag „Wenn Algorithmen den Tod vorhersagen“). Während einer von ihnen noch in der Entwicklung steckt und von Forschern der Stanford University in einer aktuellen Studie öffentlich publiziert wurde, ist der andere in der Hand eines US-Unternehmens Aspire Health.

Im Gegensatz zu den Stanford-Forschern ist Aspire Health eine gewinnorientierte Firma, die spezialisierte ambulante Palliativdienste anbietet. Das heißt, sie verdient ihr Geld mit Schwerkranken, die aus der regulären Versorgung herausgezogen werden. Je mehr Menschen die Palliativdienste von Aspire nutzen, desto höher ist der Gewinn. Der Interessenkonflikt liegt auf der Hand. Und das große Problem dabei: Wie der Algorithmus von Aspire Health funktioniert, ist ein Betriebsgeheimnis. Unklar ist somit auch, wie das System darüber entscheidet, für welche Patienten diese Art von Palliativversorgung tatsächlich die beste Alternative ist.

Die Vermutung liegt nahe, dass Aspire Health den Algorithmus eher derart optimiert, dass möglichst viele Patienten korrekt identifiziert werden, die von einer palliativmedizinischen Versorgung profitieren würden. Eine möglichst hohe Sensivität geht jedoch mit einer niedrigeren Spezifität einher. Das heißt, der Algorithmus macht mehr Fehler in der Identifikation von jenen Patienten, die das Zwölf-Monate-Zeitfenster überleben.

Nur ein transparenter Algorithmus lässt eine Einordnung darüber zu, wie das System optimiert wurde. Und bei einem System, das Voraussagen über Überlebenswahrscheinlichkeiten trifft, dürfen Optimierungsansätze nicht in der Hand von kommerziellen Firmen liegen. Vielmehr müssen Hersteller offenlegen, welches Ziel der Algorithmus verfolgt und unter welchen Rahmenbedingungen er eingesetzt wird. Beide Aspekte müssen dann öffentlich, und zwar politisch wie gesellschaftlich und ethisch, diskutiert werden. Zudem muss die Leistung des Algorithmus überprüfbar sein.

Algorithmen müssen fortwährend gründlich validiert werden:

Mit der Forderung nach einer Transparenz für solche Algorithmen geht auch deren Überprüfung einher. Nur ein öffentlich zugänglicher Algorithmus ist auch in öffentlich zugänglichen Untersuchungen überprüfbar. Und es müssen etliche Fragen an solche Algorithmen gestellt werden, wie etwa:

- Wie zuverlässig sind ihre Prognosen?

- Wie hoch ist die Rate von falschen positiven oder falschen negativen Prognosen?

- Helfen die Algorithmen tatsächlich dabei, verschiedene Ziele zu erfüllen? Welchen Zweck genau sollen sie erfüllen (wie etwa den Zugang zu einer ambulanten Palliativversorgung zu verbessern oder die Kosten unnötiger Behandlungen oder Operationen zu senken)?

- Welche Rahmenbedingungen gelten für sie? Das heißt, für welche Patientengruppen werden sie entwickelt?

Um diese Fragen beantworten zu können, sind nicht zuletzt öffentlich finanzierte Studien notwendig. So haben die Algorithmen, die zur kurzfristigen Berechnung von Todesrisiken in Patientenüberwachungssystemen im Einsatz sind, bereits in mehreren Studien gezeigt, dass sie eine hohe Trefferquote haben und Leben retten können. Diese sind auch als Medizinprodukte von Gesundheitsbehörden wie der US-Behörde Food and Drug Aministration (FDA) oder europäischen Einrichtungen zugelassen.

Zulassungsverfahren müssen (den Fortschritten) angepasst werden:

Für elektronische Unterstützungssysteme, die in der Klinik eingesetzt werden (Clinical Decision Support Systems, CDSS), gibt es bisher keine einheitliche Definition. Ein Entscheidungsvorschlag durch einen Algorithmus kann in der Komplexität stark variieren: Die Palette reicht vom einfachen Hinweis auf einen doppelten Eintrag in der Patientenakte bis hin zu Deep-Learning-Algorithmen für eine Sterbeprognose.

Auch die Kriterien für die Zertifizierung als Medizinprodukt sind zum einen sehr komplex, zum anderen stellen sie aber bisher keine konkreten Anforderungen an klinische Entscheidungsunterstützungssysteme. In den USA ist man immerhin einen Schritt weiter: Die zuständige Food and Drug Administration (FDA) hat Ende 2017 eine neue Regulierungsrichtlinie für CDSS vorgelegt. Darin wird unter anderem neu festgelegt, bei welchen Systemen es sich künftig um zulassungspflichtige Medizinprodukte handelt und wann nicht. Allerdings steigt mit zunehmender Komplexität von CDSS auch die Komplexität der spezifischen Anforderungen für die Zulassung. Das aber könnte wiederum die Implementierung solcher Systeme unnötig kompliziert machen oder Innovationskraft bremsen.

Zudem sind im Fall von algorithmischen Systemen für die Sterbeprognose einige weitere regulatorische Punkte zu klären:

- Welche Institutionen dürfen oder sollen solche Algorithmen einsetzen? Soll das etwa nur Kliniken gestattet sein? Oder sollten sie von jenen Einrichtungen genutzt werden, die eine spezialisierte ambulante Palliativversorgung (SAPV) anbieten? Darf auch ein niedergelassener Hausarzt einen solchen Algorithmus nutzen? Oder am Ende nur der Medizinische Dienst der Krankenkassen (MDK), der über die Verordnungen für eine Palliativversorgung im häuslichen Umfeld entscheidet?

- Wie reguliert man selbstlernende Algorithmen, die sich ständig verbessern, ohne dass man genau weiß, wie sie das tun?

Ärzte müssen auf die Kommunikation von Sterbeprognosen vorbereitet werden:

Im Zeitalter vor der künstlichen Intelligenz mussten sich Ärzte in vielen Bereichen allein auf ihr Wissen und ihren Erfahrungsschatz verlassen. Auch wenn es darum ging, Menschen zu sagen, dass sie wahrscheinlich nicht mehr lange zu leben haben. Doch selbst wenn einen Algorithmus gäbe, der zu 100 Prozent jedem Schwerkranken sagen kann (was nie der Fall sein wird), wann er stirbt, hieße es noch lange nicht, dass es die Arzt-Patientenkommunikation erleichtern würde.

Im Gegenteil: Noch haben Algorithmen keine Moral. Und eine Empfehlung zu einem so emotionalen Erlebnis wie dem nahenden Tod sollte niemals von einem Programm abgegeben werden. Ärzte können eine künstliche Intelligenz (KI) für ihre Entscheidung nutzen, werden aber immer das Gesamtgefüge Mensch einbeziehen. Es gibt nicht wenige Patienten, die trotz 95-prozentiger Wahrscheinlichkeit zu sterben, fest daran glauben wollen, dass sie zu den anderen fünf Prozent der doch wieder Genesenden gehören.

Ärzte neigen Studien zufolge häufig zu Überoptimismus, wenn es um die Überlebenswahrscheinlichkeit ihrer Patienten geht. Das ist menschlich. Doch wie geht ein Arzt damit um, dass ein Algorithmus besser bei der Einschätzung ist? Lässt er diese Objektivierung dann auch zu? Und wie erklärt er dem Patienten, dass diese Empfehlung auf den Prognosen einer Maschine beruhen?

Ein offener Diskurs mit dem Unbehagen, dass Maschinen Sterbeprognosen abgeben können, ist ebenso erforderlich wie eine fundierte Ausbildung von medizinischem Personal. Zusatzqualifikationen im Bereich Statistik und die Ausbildung eines Grundverständnisses für die Funktionsweisen algorithmischer Systeme sind ebenso erforderliche Maßnahmen wie die Weiterentwicklung von Ausbildungsmaßnahmen zur Arzt-Patientenkommunikation, insbesondere in der Palliativversorgung.

Es muss ein offener Diskurs über den Wert des Lebensendes stattfinden:

Chemotherapien oder Operationen können für Krankenhäuser lukrativ sein. Doch wie viel darf die Behandlung eines unheilbar Kranken noch kosten, wenn schon feststeht, dass ihm nicht mehr viel Zeit bleibt? Oder wenn feststeht, dass er ohne Therapie zwar schneller sterben, dafür aber die letzte Zeit nicht im Krankenhaus verbringen muss und weniger an den Nebenwirkungen leidet? Diese Frage lässt sich nur schwer beantworten.

Denn es gibt sie, diese Patienten, die wider aller statistischen Wahrscheinlichkeit doch noch überleben. Und es lässt sich kaum festlegen, ob eine Therapie unnötig war. War sie unnötig, wenn sie dem Patienten noch ein paar Wochen geschenkt hat? Auch hierüber sollte ein gesellschaftlicher und politischer Diskurs stattfinden.

In England etwa gilt die Maßgabe, dass eine Verbesserung der Lebensqualität oder die Verlängerung der Lebensdauer nur zu einem als angemessen befundenen Preis erfolgen darf. Dieser Preis wird auf 20.000 bis 30.000 britische Pfund pro zusätzlich gewonnenes Lebensjahr festgelegt. Auch sorgt eine solche Kosten-Nutzen-Rechnung für Unbehagen. Was einem gesunden Menschen mit Vermögen angemessen erscheinen mag, ist für Kranke ohne Vermögen vielleicht völlig unangemessen. Dennoch muss diese Debatte geführt werden. Denn ohne transparent und in breitem Diskurs überprüfte Werte verschiebt man solche Kostenrechnungen in die Krankenhäuser, an die Anbieter von Palliativmedizin oder die Krankenkassen.

Ob ein sogenanntes qualitätskorrigiertes Lebensjahr (quality adjusted life year, QALY) tatsächlich die richtige Kennzahl für eine solche Berechnung ist, ist hierzulande noch stark umstritten. Angesichts aber solcher Entwicklungen wie solcher Sterbeprognosetools ist die Diskussion darüber wichtiger denn je.

Die Entscheidung muss immer beim Arzt und Patienten liegen:

Wie auch immer die Entwicklung von medizinischen Algorithmen zur Sterbeprognose weitergeht: Es sollte sichergestellt werden, dass am Ende der Arzt als Mensch eine Empfehlung gibt oder eine Entscheidung fällt – und zwar gemeinsam mit seinem Patienten oder den Angehörigen.

Weder die Sterbeprognosen des Katers Oscar noch die der Algorithmen sind fehlerfrei. Und sie werden es auch niemals sein. Zudem „bilden sie nur das Modell eines Menschen ab, nie den Menschen selbst“, konstatiert Kevin Baum, Computerethiker der Universität des Saarlandes in der ARD-Sendung Panorama. „Was eine Maschine nicht kann, ist eine Einzelfallentscheidung zu treffen.“ Und was sie auch nicht kann, worin aber Kater Oscar besonders gut war: Gesellschaft leisten und Wärme und Trost spenden.

Dies ist der dritte Teil einer dreiteiligen Artikelserie zu Algorithmen zur Berechnung von Todesrisiken.

Hier finden Sie Teil 1 der Artikelserie: “Wie Algorithmen Menschen vor einem frühzeitigen Tod bewahren können”

Und hier Teil 2: “Optimierung der Palliativversorgung: Wenn Algorithmen den Tod vorhersagen“

Kommentar schreiben