In nordrhein-westfälischen Großstädten bekommen Streifenpolizisten zu Anfang ihrer Schicht Informationen an die Hand, in welchen Wohnbezirken ihres Einsatzgebietes erhöhte Präsenz und Aufmerksamkeit gefragt ist. Für diese Areale hat das Predictive-Policing-Computerprogramm SKALA eine erhöhte Wahrscheinlichkeit zukünftiger Kriminalität errechnet. „Solche Gebiete wurden früher auch schon gekennzeichnet und den Beamten als Orientierungshilfe an die Hand gegeben“, sagt Joachim Eschemann, der das System mitentwickelt hat und inzwischen im Düsseldorfer Innenministerium das Referat für Kriminalitätsangelegenheiten leitet. „Der entscheidende Unterschied ist, dass wir uns dabei früher ausschließlich auf von Hand ausgewertete Daten und auf das kriminalistische Gespür der Kollegen verlassen mussten“, so Eschemann. „Heute haben wir zusätzlich Software, die unsere Einschätzungen zu objektivieren hilft.“

Aus Krimis kennen wir alle das Bild der Polizei, die versucht, Serientätern auf die Spur zu kommen und sich mittels Nadeln auf einer Landkarte ein Gesamtbild von der Lage zu machen. Wer Google Maps oder ähnliche Kartendienste nutzt, wird sich nicht wundern, dass Computerprogramme bei dieser Arbeit eine enorme Erleichterung bedeuten können. Genau das tun ortsbezogene Predictive-Policing-Algorithmen: Sie verdichten Daten jüngst begangener Straftaten und weitere raumbezogene Informationen (z. B. zu Infrastruktur und Veranstaltungen) zu einem räumlichen Lagebild, das helfen soll, knappe Polizeiressourcen effizienter einzusetzen. Wenn ich nur einen Streifenwagen für einen Bezirk habe, dann kann es einen großen Unterschied machen, ob er in Straßen mit geringer oder in Straßen mit hoher Wahrscheinlichkeit für Straftaten Präsenz zeigt.

Andere Länder wie die USA, Großbritannien, die Schweiz oder Israel gehen über die in Deutschland praktizierte ortsgebundene Präventionsstrategie hinaus. Dort verarbeitet vergleichbare Software auch personenbezogene Daten, um Gefährderlisten (auch als „Heat Lists“ bekannt) zu erstellen und diese in die Präventionsarbeit zu integrieren. Das Diskriminierungspotenzial von derlei personenbezogenem Predictive Policing veranschaulicht der Dokumentarfilm „Precrime“ sehr gut. Robert McDaniel, ein junger Afroamerikaner aus Chicago und einer der Protagonisten von „Precrime“, tauchte auf einer solchen Heat List auf, nachdem sein bester Freund ermordet wurde und dieser Mord in Verbindung mit rivalisierenden Gangs gebracht wurde. Seitdem McDaniel auf der Liste steht, wird er regelmäßig von Polizisten für Präventionsgespräche aufgesucht. Wegen dieses regelmäßigen Polizeikontakts, der erst einmal keine Verhaftung zur Folge hat, ist er in den Verdacht geraten, ein Informant der Polizei zu sein. Das hatte eine regelrechte soziale Ächtung zur Folge, sein Leben ist nicht mehr dasselbe wie vorher.

Solche nicht intendierten und eventuell gar nicht vorhersehbare Folgen von Präventionsmaßnahmen für Betroffene sind ein Problem, das aus dem Einsatz von algorithmischen Analysesystemen resultieren kann. Ein anderes Problem kann aus der Tatsache erwachsen, dass die empirischen Daten, die zur Analyse herangezogen werden, im Grunde immer nur die – selten perfekte und unseren Idealvorstellungen entsprechende – Wirklichkeit abbilden. Gerade wenn aber die Daten einen bereits nicht diskriminierungsfreien Status quo repräsentieren, liegt die Gefahr einer Verstärkung dieses Effekts durch maschinelle Datenverarbeitung auf der Hand. Mit höherer Wahrscheinlichkeit treten die beschriebenen Probleme dann auf, wenn Systeme zu anderen als für die ursprünglich gedachten Zwecke genutzt werden. Und das ist leider der Fall, so werden beispielsweise für die Prävention entwickelte Instrumente international immer wieder auch zu Ermittlungszwecken eingesetzt, wie die Bertelsmann Stiftung in ihrem Arbeitspapier “Wenn Maschinen Menschen bewerten” aufgezeigt hat.

Lagebild für Deutschland

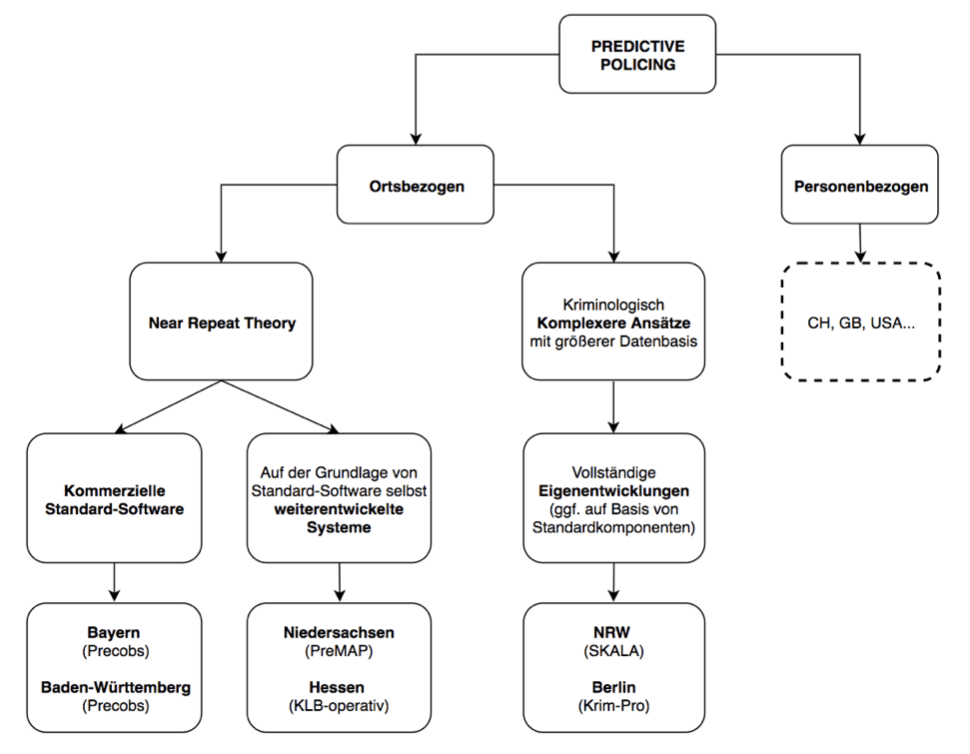

Zurück nach Deutschland. Sechs deutsche Bundesländer setzen derzeit fünf verschiedene algorithmische Systeme zur ortsbezogenen vorausschauenden Polizeiarbeit ein, bislang vornehmlich zur Prävention von Wohnungseinbrüchen. Während die Bundesländer Bayern und Baden-Württemberg mit der Software Precobs des Oberhausener Unternehmens IfmPt GmbH arbeiten, nutzen Nordrhein-Westfalen und Berlin vollständig selbst entwickelte Systeme. Die Bundesländer Hessen und Niedersachsen gehen einen Mittelweg. Sie haben Standardsoftware für ihre Zwecke weiterentwickelt. Die Mehrheit der eingesetzten Systeme basiert auf der aus der Kriminologie stammenden Near Repeat Theory. Sie besagt, dass bei Delikten wie Autodiebstahl sowie Wohnungs- und Gewerbeeinbrüchen die Wahrscheinlichkeit für weitere Taten im örtlichen Umfeld des ursprünglichen Delikts steigt.

Abbildung 1 bietet einen Überblick über den Stand der Dinge.

Abbildung 1: Situation des Predictive Policing in Deutschland (Quelle: eigene Darstellung)

Die Diskussionen über algorithmische Prozesse finden bislang meist in abgeschlossenen Zirkeln mit wenig interdisziplinärer Zusammenarbeit statt. Anders im Projekt „Algorithmen fürs Gemeinwohl“ der Stiftung Neue Verantwortung und der Bertelsmann Stiftung, das über Sektorengrenzen hinweg gemeinsam die Problemanalyse schärfen und gemeinwohlorientierte Gestaltungsprinzipien entwickeln möchte. Im April 2018 waren Vertreter aus vier der sechs betroffenen Landeskriminalämter, Entwickler, Wissenschaftler und Akteure der Zivilgesellschaft zu einem intersektoralen Workshop über die Chancen und Risiken des Predictive Policing in Deutschland zu Gast in Berlin. In diesem Beitrag teilen wir einige unserer zentralen Erkenntnisse aus diesem Workshop.

Deutsche Behörden gehen beim Einsatz von Predictive-Policing-Software umsichtig vor

Wir waren positiv überrascht, wie methodenbewusst und reflektiert die vertretenen Behörden die jeweiligen Tools getestet, implementiert und immer wieder kritisch geprüft und weiterentwickelt haben. In allen Fällen werden sie als Erweiterungen des Instrumentenkastens polizeilicher Ermittlungsarbeit und als Unterstützung der kriminalistischen Methoden angesehen. Drei Beispiele mögen den positiven Umgang mit Predictive-Policing-Systemen in den Landespolizeibehörden illustrieren:

In Nordrhein-Westfalen hat man die Qualität der Ergebnisse eines einfachen, nach vordefinierten Entscheidungsregeln operierenden Algorithmus (ein sogenannter „Entscheidungsbaum“) mit der einer Algorithmenarchitektur verglichen, die dem menschlichen Gehirn nachempfunden ist (ein sogenanntes „neuronales NetzNeuronale Netzwerke Ein Modell der Künstlichen Intelligenz, das die Arbeitsweise des menschlichen Gehirns nachahmt. Es besteht aus vielen miteinander verbundenen „Neuronen“ oder Knotenpunkten, die in Schichten angeordnet sind. Diese Netzwerke lernen durch Anpassung der Verbindungen zwischen den Neuronen, um Muster in Daten zu erkennen und daraus Vorhersagen oder Entscheidungen zu treffen.“). Grundsätzlich ist eine Vielfalt technischer Ansätze begrüßenswert, weil sich auf diese Weise die spezifischen Schwächen eines Ansatzes nicht flächig ausbreiten. Da man in Nordrhein-Westfalen keine signifikante Verbesserung der Ergebnisqualität durch das neuronale Netz festgestellt hat, ist man aufgrund der größeren Transparenz der Funktionsweise beim Entscheidungsbaum geblieben. In Baden-Württemberg hat man beim Max-Planck-Institut für ausländisches und internationales Strafrecht mit Sitz in Freiburg im Breisgau eine wissenschaftliche Evaluation des Testbetriebs in Auftrag gegeben und veröffentlicht. Sie ist weltweit die erste ihrer Art, doch selbst als der entsprechende Bericht bereits vorlag und dieser keine schwerwiegenden Kritikpunkte enthielt, ist man noch nicht in den Regelbetrieb übergangen, sondern hat eine zweite Testphase gestartet.

Damit soll nicht gesagt werden, dass bereits alle Fragen geklärt sind. Es braucht weitere systematische Studien, auch solche mit einem Langzeitdesign und mit Kontrollgruppen. Aber es gibt immerhin vielsprechende Ansätze in Deutschland, die über das hinausgehen, was in anderen Ländern an kritisch-reflektierender Herangehensweise stattfindet. Wir müssen dabei aber auch weniger offensichtliche Aspekte in den Blick nehmen, beispielsweise die Fallbearbeitungssysteme der Polizei. In ihnen werden diejenigen Daten erfasst, mit denen die Vorhersagealgorithmen später gefüttert werden. Fehler oder Ungenauigkeiten, die sich hier einschleichen, wirken sich unausweichlich negativ auf die Qualität der darauf basierenden Prognosesoftware aus.

Passive Kommunikation erzeugt unnötige Technologiemythen

Bei der vorhersagenden Polizeiarbeit gehen die Behörden nach unseren Informationen ganz überwiegend sehr umsichtig vor – nur geredet wird darüber zu wenig. Und wenn, dann meist nur auf explizite Nachfrage. Die Gründe dafür sind durchaus nachvollziehbar: Sicherheitsbehörden haben Vertraulichkeit, was ihre Arbeitsweisen und Methoden angeht, gewissermaßen im Blut. Außerdem könnte ein Zuviel an öffentlich zugänglichen Informationen über die Funktionsweise der genutzten Vorhersagealgorithmen dazu führen, dass die Systeme (etwa von Einbruchsbanden) ausgetrickst werden können. Doch Transparenz und Nachvollziehbarkeit bei algorithmischen Systemen, die für die breite Gesellschaft von großer Tragweite sind (in diesem Fall geht es schließlich um eine faire Verteilung des Gutes Sicherheit), sind absolut notwendig und kein optionaler Zusatz.

Ein Beispiel zeigt, warum: 2016 fand die amerikanische Bürgerrechtsorganisation ProPublica heraus, dass der COMPAS-Algorithmus, der in den USA häufig zur Entscheidung über die Aussetzung von Haftstrafen zur Bewährung herangezogen wird, Gefangene mit einer anderen als weißen Hautfarbe systematisch diskriminiert. Die eklatanten Mängel konnten nur ans Licht gebracht werden, weil ProPublica zuvor die Funktionsweise des Algorithmus aufwendig durch einen Nachbau (sogenanntes „Re-Engineering“) offengelegt hat.

Zudem provoziert die allzu passive Kommunikationsstrategie einen medialen und politischen Diskurs, der die Technologie mystifiziert. Das wirkt sich negativ auf die gesellschaftliche Stimmung in Fragen der vorausschauenden Polizeiarbeit im engeren Sinne sowie auf den Einsatz algorithmischer Systeme zur Steuerung und Automatisierung insgesamt aus. Denn wer wenig weiß, entwickelt viel Misstrauen. Eine repräsentative Befragung der Bertelsmann Stiftung zum Wissen über und zur Wahrnehmung von algorithmischen Systemen in der Bevölkerung hat ergeben, dass größeres Wissen zu einer ausgewogeneneren Wahrnehmung von Chancen und Risiken führt. Und natürlich vermuten auch Journalisten Fehler und Unzulänglichkeiten besonders dort, wo Behörden von sich aus zurückhaltend kommunizieren. Schnell werden dann Parallelen zum Einsatz von Predicitive Policing in den angelsächsischen Ländern gezogen (der mit dem hiesigen Einsatz überhaupt nicht vergleichbar ist), Bilder aus der populären Kultur bemüht und etwa behauptet, dass die Phantasien aus dem Kinofilm „Minority Report“ (1999) bald Wirklichkeit werden – was natürlich Unsinn ist.

Gefragt ist Systemnutzungstransparenz

Im Grunde ist hier nicht die mangelnde Transparenz der technischen Funktionsweise algorithmischer Systeme (die viel beschworene Systemintransparenz) das Problem, sondern eher etwas, das ich mit dem – zugegeben langen – Begriff Systemnutzungsintransparenz bezeichnen möchte. Eine solche liegt dann vor, wenn zwar für Experten theoretisch nachvollziehbar ist, welches System genutzt wird, wie das System an sich funktioniert, welche Daten es einbezieht und wie es zu seinen Schlussfolgerungen und Empfehlungen kommt – wenn aber all das den vom Systemeinsatz praktisch Betroffenen nicht bekannt ist.

Das betrifft auch einen sehr bedeutenden politischen Faktor: die von der Bevölkerung empfundene Sicherheit. Wenn Systeme eingesetzt werden, die die Menschen nicht verstehen, dann hat das einen tendenziell negativen Effekt auf ihr Sicherheitsgefühl. Wenn ihnen jedoch bekannt ist, wie und warum eine eingesetzte Software zur Sicherheit in ihren Bezirken beitragen kann, stärkt dies erstens das Sicherheitsgefühl, verbessert zweitens das Verhältnis von Bürgern und Polizei und kann drittens sogar dazu führen, dass Bürger die Behörden aktiv in ihrer Arbeit unterstützen. Behörden, die algorithmische Systeme einsetzen, sollten deshalb dringend Systemnutzungstransparenz herstellen und sich aktiv an der gesellschaftsweiten Kommunikation darüber beteiligen. Wie sonst soll eine Gesellschaft den Stellenwert, den solche Systeme in ihr zukünftig einnehmen sollen, und die Anforderungen, die an sie zu stellen sind, angemessen debattieren und aushandeln können?

Aktive Kommunikation bereichert gesellschaftlichen Diskurs

Im Fall des Predictive Policing ist das Fehlen einer aktiven Kommunikationsstrategie besonders irritierend, weil die durchführenden Behörden – jedenfalls nach dem, was wir herausgefunden haben – nichts zu verstecken haben. Im Gegenteil: Sie haben viel zu erzählen, und zwar nicht nur über die spezifische Herausforderung vorausschauender Polizeiarbeit, sondern auch über damit verbundene Erfahrungen allgemeinerer Art. Nordrhein-Westfalen hat beispielsweise etwas, was für staatliche Stellen derzeit aus vielerlei Gründen eine große Herausforderung darstellt: auf dem Arbeitsmarkt gefragte Programmierer und Data Scientists, um ein auf die Bedürfnisse des Landes zugeschnittenes System selbst entwickeln und betreiben zu können. Es wäre sowohl für andere Behörden als auch für Personen mit technischen Fertigkeiten, die im öffentlichen Sektor arbeiten wollen, von großem Interesse, zu erfahren, wie man in Deutschlands bevölkerungsreichsten Bundesland diesbezüglich vorgegangen ist, um ein solches Team aufzubauen.

Fazit: Durch eine aktivere Kommunikation könnten Behörden, die Predictive Policing betreiben, den so dringend benötigten gesellschaftlichen Diskurs über den zunehmenden Einsatz algorithmischer Analyse- und Entscheidungssysteme enorm bereichern und nötiges Vertrauen bei der Bevölkerung aufbauen. Gerade jetzt, da sich erst weniges im Operativbetrieb befindet, aber über vieles schon nachgedacht wird und manches in Planung ist, brauchen wir einen aufgeklärten, kritischen Diskurs aller Sektoren, an dem sich auch die Polizeidienststellen beteiligen. Anders können wir uns als Gesellschaft nicht auf Prinzipien für das Design und den Einsatz algorithmischer Systeme einigen, die dem Gemeinwohl dienen.

Die öffentliche Hand sollte hier mit bestem Beispiel vorangehen. Das wird nicht nur deutlich, wenn wir auf das schauen, was im Ausland bereits zum polizeilichen Alltag zählt, sondern auch dann, wenn wir uns das Gesamtbild hierzulande vor Augen führen: Das neue Polizeigesetz Hessens, von Bürgerrechtsorganisationen scharf kritisiert, sieht beispielsweise u. a. elektronische Fußfesseln für Gefährder vor; dasselbe Bundesland hat einen Vertrag mit dem fast schon berüchtigten US-amerikanischen Data-Analytics-Unternehmen Palantir abgeschlossen. Unsere soziotechnische Wirklichkeit wird eben nicht nur von technischen Möglichkeiten, sondern auch vom gesetzlichen Rahmen, von Verträgen und vielen anderen Faktoren bestimmt. Aufgrund der Komplexität dieses Geflechts tun wir gut daran, uns jetzt, da zumindest die technischen Instrumente der Polizeiarbeit noch recht gut überschaubar sind, intensiv damit auseinanderzusetzen und uns zu fragen, wie erweiterte technische Möglichkeiten diesen Bereich strukturell ändern werden.

Zuletzt ganz nebenbei: Wie sehr würden die vom Negativimage des in Deutschland schleppenden E-Government-Fortschritts gebeutelten Behörden insgesamt davon profitieren, wenn sichtbar würde, dass bei der Polizei mit Sachkenntnis, Behutsamkeit und Beharrlichkeit avancierte digitale Werkzeuge erfolgreich eingesetzt werden? Das wäre hier vergleichsweise leicht zu haben – und es wäre so wichtig! Denn nicht nur die vorausschauende Polizeiarbeit in Nordrhein-Westfalen stellt unter Beweis, dass der Staat auch im digitalen Zeitalter handlungsfähig sein kann.

—UPDATE 03.09.2018 —

Inzwischen haben wir ein ausführliches Policy Paper zu diesem Thema veröffentlicht, das die Gedanken noch mehr vertieft. Es kann hier heruntergeladen werden.

Dieser Text ist lizenziert unter einer Creative Commons Namensnennung 4.0 International Lizenz.

Kommentar schreiben