Die Technik der selbstfahrenden Autos schreitet rapide voran. Die Entwicklung ist nicht nur eine technische, sondern auch eine ethische Herausforderung.

Plötzlich geht es ganz schnell. Im Dezember 2018 kündigte Tesla die nächste Stufe seines Autopiloten an, der die Fahrer:innen automatisch von zu Hause bis zur Arbeit fahren kann. Google zog wenige Tage später durch den Start ihres Roboter-Taxidienstes Waymo One nach. Kurz darauf stellte die US-amerikanische National Highway Traffic Safety Administration (NHTSA) ein beschleunigtes Genehmigungsverfahren für Autos vor, die sogar auf Lenkrad und Gaspedal verzichten könnten. Auf der US-Technikmesse CES stehen die Hersteller:innen autonomer Fahrzeuge regelrecht Schlange.

Solche Schlagzeilen lassen leicht den Eindruck entstehen, wir seien nur ein paar Updates und einen Genehmigungsprozess davon entfernt, dass Algorithmen und Sensoren menschliche Autofahrer:innen vollständig ablösen. Dieser Eindruck täuscht jedoch. Expert:innen sind sich darin einig, dass es noch Jahre dauern wird, bis voll autonome Fahrzeuge zum Alltag gehören.

Fünf Stufen bis zum Robotertaxi

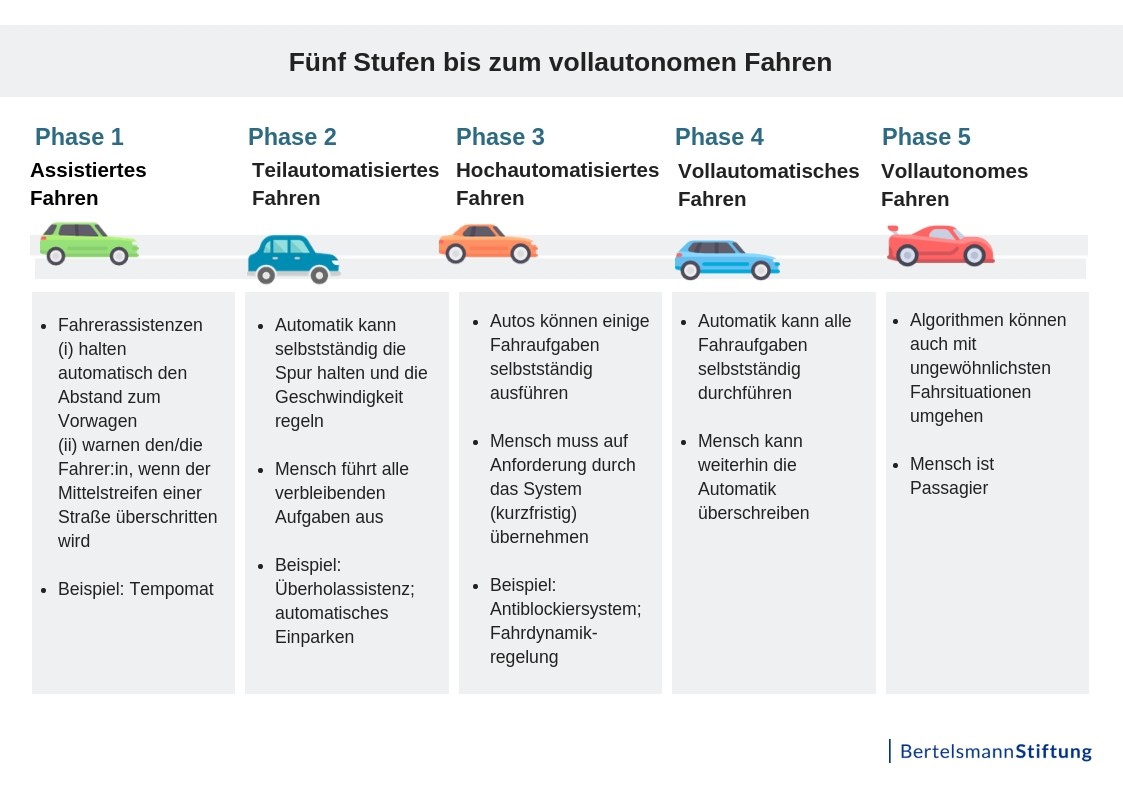

Der Weg vom assistierten zum vollautonomen Fahren ist erstaunlich lang. Die Ingenieursorganisation SAE[1] International hat die Entwicklung in fünf Phasen eingeteilt:

Phase 1 definiert ein assistiertes Fahren, zu dem beispielsweise ein Tempomat gehört, der mithilfe von Sensoren automatisch den Abstand zum Vorwagen hält; oder auch eine Automatik, die den Fahrer warnt, wenn das Fahrzeug den Mittelstreifen einer Straße überschreitet. Für alle Fahraktionen ist weiterhin der Mensch verantwortlich. Viele Autos ab der oberen Mittelklasse nutzen solche Technik schon heute.

In Phase 2 ist ein teilautomatisiertes Fahren möglich: Auf gut ausgebauten Strecken – wie zum Beispiel Autobahnen – kann die Automatik selbstständig die Spur halten und die Geschwindigkeit regeln. Das erlaubt der/dem Fahrer:in, zumindest zeitweilig ihre/seine Hände vom Steuer zu nehmen. Dennoch muss der Mensch ständig die Straße im Blick behalten.

Erst mit Phase 3, dem hochautomatisierten Fahren, kann der Mensch sich entspannt zurücklehnen und beispielsweise seine E-Mails lesen. Wenn das Auto Alarm gibt, muss die sich im Auto befindende Person aber stets bereit sein, das Steuer wieder zu übernehmen.

In Phase 4, dem vollautomatisiertem Fahren, können sich die menschlichen Fahrer:innen erstmals als Passagier:innen fühlen – selbst in kritischen Situationen behält die Automatik die Kontrolle. Trotzdem kann der Mensch die Algorithmen überstimmen. Zuweilen dient sie/er auch als Lotsin/Lotse, wenn die Automatik keine Möglichkeit findet, den vorgegebenen Weg fortzusetzen.

Mit Phase 5 ist das vollautonome Fahrerlebnis erreicht. Die Algorithmen können hierbei auch mit ungewöhnlichsten Fahrsituationen umgehen. Menschen müssen und können nicht mehr aktiv werden – ein Lenkrad wird damit obsolet.

Firmen wie die Google-Tochter Waymo häufen auf den Teststrecken in Arizona inzwischen Millionen autonom gefahrener Meilen an. Doch auch die Testfahrzeuge haben meist noch einen oder gar zwei menschliche Pilot:innen an Bord, die sicherstellen sollen, dass der Computer keine folgenschweren Fehler macht. Zudem sind die Testautos immer wieder auf denselben Strecken unterwegs und erreichen für europäische Verhältnisse nur eine eher gemächliche Geschwindigkeit.

Auch im langsamen US-Verkehr müssen die Testfahrer:innen selten auf die Bremse treten, um einen Unfall zu vermeiden. Im Gegenteil: Schon eine über die Straße wehende Plastiktüte kann die Autopiloten überfordern. Die/Der Fahrer:in wird dann aufgefordert, das Kollisionsrisiko einzuschätzen und ein Weiterfahren des Autos zu veranlassen. Auch mit unklaren Straßenmarkierungen oder Falschparker:innen kommen die Systeme nur schlecht klar. Die Fahrer:innen müssen dem Bordcomputer zu verstehen geben, dass das Fahrzeug beispielsweise eine durchgestrichene Linie überfahren darf. Denn selbstständig gegen Verkehrsregeln verstoßen sollen die Automatiksysteme nicht.

Noch ist also längst nicht sicher, ob und wann Fahrer:innen im Normalbetrieb in Deutschland die Kontrolle über ihr Fahrzeug endgültig an Algorithmen und Sensoren abgeben können.

Fiktives Experiment

Die Begeisterung für die neue Technik sorgte auch für ein Revival des sogenannten „Trolleyproblems“. In dem Gedankenexperiment sehen Beobachter:innen einen Zug, der mit einem vollbesetzten Personenzug zu kollidieren droht. Die Beobachter:innen müssen nun entscheiden: Lassen sie den Zug weiterfahren oder leiten sie ihn auf ein anderes Gleis um, auf dem gerade eine Gruppe von Gleisarbeiter:innen steht.

Dieses moralische Dilemma beschäftigt Ethiker:innen seit den 1930er Jahren, erhielt aber mit dem fortschreitenden Hype um das autonom gesteuerte Auto neue Dringlichkeit. Das Massachusetts Institute of Technology (MIT) startete 2016 eine Onlinebefragung, bei der die Teilnehmer:innen in einer Reihe von Szenarien den Schutz unterschiedlicher Personengruppen abwägen sollten. Soll ein autonomes Auto eher ältere oder jüngere Passant:innen überfahren? Sollen die Insassen des Autos geopfert werden, um Fußgänger:innen zu schonen? Wer verdient besonderen Schutz: Schwangere, Führungskräfte, Kinder, Ältere oder gar auch Haustiere wie Katzen und Hunde?

Das Ergebnis der Umfrage ist unter anderem eine internationale Vergleichsstudie zu den Wertevorstellungen der Teilnehmer:innen, welche auch außerhalb der Fachcommunity große Aufmerksamkeit erhielt. So votieren Teilnehmer:innen aus Staaten mit starken staatlichen Institutionen eher dafür, dass ein autonomes Auto weniger Rücksicht auf Menschen nimmt, die gegen die Straßenverkehrsordnung verstoßen. Nutzer:innen aus Nordamerika und einigen europäischen Staaten bevorzugen es, junge Verkehrsteilnehmer:innen zu „schonen“, während in asiatischen Staaten wie Japan, Indonesien oder Pakistan eher ältere Fußgänger:innen als „schonenswert“ priorisiert werden.

Dabei spielen solche Überlegungen für den praktischen Einsatz von autonomen Autos eine untergeordnete Rolle. Derzeit ist die Technik noch damit ausgelastet, Fußgänger:innen überhaupt zu erkennen, um eine Kollision zu vermeiden.

Auch hat die Ethik-Kommission der Bundesregierung zum autonomen Fahren bereits 2017 einen Schlussstrich unter die Debatte gezogen. In den im Juni 2017 vorgestellten 20 Grundsätzen zum autonomen Fahren ist quasi ein Verbot des Trolleyproblems enthalten. „Bei unausweichlichen Unfallsituationen ist jede Qualifizierung nach persönlichen Merkmalen (Alter, Geschlecht, körperliche oder geistige Konstitution) strikt untersagt“, heißt es in den Empfehlungen der Expertenkommission. Und weiter: Auch „eine Aufrechnung von Opfern ist untersagt.“ Sprich: Die Maschinen dürfen keine moralischen Entscheidungen treffen, sondern nur praktische: Wie vermeide ich am besten, dass es überhaupt zu einem Unfall kommt?

Die Fokussierung der Debatte auf das Trolleyproblem illustriert gleichwohl eine grundsätzliche Schwierigkeit bei der Einführung autonomer Verkehrsmittel: Obwohl viel dafür spricht, dass der breite Einsatz autonomer Fahrzeuge – deren Reaktionsgeschwindigkeit deutlich höher ist als die von Menschen – die Zahl der Verkehrsopfer wesentlich reduzieren könnte, steht die Einführung der Technik vor einem Akzeptanzproblem.

So ergab eine repräsentative Umfrage der Bertelsmann Stiftung Anfang 2017, dass 95 Prozent der Deutschen mit der Einführung des autonomen Fahrens in den kommenden Jahrzehnten rechnen. Zugleich zeigen sich 67 Prozent misstrauisch, ob dieses Ziel erstrebenswert ist. Insbesondere der Verlust der Kontrolle beim Autofahren und die Angst vor technischen Fehlern beschäftigt demnach die Deutschen. Ob man die Frage nach Leben und Tod nicht einer Maschine überlassen will, hat ein enormes politisches Potenzial. Und dies zu Recht. Hersteller:innen und Besitzer:innen dürfen die Verantwortung für die Handlungen der Maschinen nicht pauschal auf Algorithmen abwälzen.

Auf die Frage, wen ein autonomes Auto sehenden Auges überfahren soll, kann es nach dem Stand der Entwicklung nur eine Antwort geben: Niemanden – oder zumindest möglichst wenige Opfer. Ein großer Teil der Bemühungen bei der Entwicklung autonomer Fahrzeuge wird daher zu Recht in Techniken gesteckt, die eben solche Situationen vermeiden sollen. Bevor das Auto in ein moralisches Dilemma gerät, bremst es einfach ab oder fordert die Hilfe eines Menschen an. Doch in der Praxis kann das nicht restlos klappen.

Deshalb lautet die pragmatische Devise der Behörden und Industrie: Die Autopiloten müssen mindestens so gut fahren können, wie Menschen, damit sie zum „normalen Dienst“ auf der Straße zugelassen werden. Wie das erreicht werden soll, beschreiben wir im zweiten Teil unserer Artikelreihe.

[1] Society of Automotive Engineers („Verband der Automobilingenieure“).

Hier geht’s zum 2. Teil der Artikelreihe

Dieser Artikel ist lizenziert unter einer Creative Commons Namensnennung 4.0 International Lizenz.

Kommentar schreiben