Schnellere Hilfe durch algorithmenbasierte Triage: Bei der Krisenhotline Crisis Text Line (CTL), unterstützt ein algorithmisches System die Mitarbeitenden bei der Entscheidung, wie hoch das Risiko für die Hilfesuchenden ist, und verbessert so die Antwortzeit für Menschen in akuter Gefahr.

TW: Dieser Artikel befasst sich mit Krisenhotlines und handelt deshalb auch von Suizid und Selbstverletzung. Falls Dich diese sensiblen Themen derzeit belasten, ist es besser, diesen Artikel nicht zu lesen.

Es ist der 9. November 2016, ein Tag nach der historischen Wahl von Donald Trump zum 45. US-Präsidenten. Die Anfragen bei Crisis Text Line (CTL) sind auf einem Rekordhoch, die ehrenamtlichen Krisenberater:innen kommen mit der Beantwortung der Nachrichten nicht mehr hinterher. Die drei am häufigsten benutzten Wörter in den Anfragen sind „Wahl“, „verängstigt“ und „LGBTQ“. CTL ist eine 24/7-erreichbare Non-Profit-Krisenhotline, die neben den USA in Kanada, Großbritannien und Irland erreichbar ist. Anders als die meisten Hotlines dieser Art funktioniert sie nicht über Anrufe, sondern über Textnachrichten. Das soll insbesondere für Jugendliche die Barriere des ersten Kontakts abbauen.

CTL zeichnet aber noch eine weitere Besonderheit aus. Anstatt die eingehenden Nachrichten chronologisch zu beantworten und so jede um Hilfe bittende Person gleich lang warten zu lassen, verwendet CTL ein Triage-System. Das heißt, die Anrufenden werden mithilfe eines algorithmischen Systems in verschiedene Risikogruppen eingeteilt. Auf Basis der Risikogruppen wird entschieden, wem zuerst geantwortet wird. Das Ziel dieses Systems ist es, den Menschen, die mit der höchsten Wahrscheinlichkeit vorhaben, sich selbst zu verletzen oder Suizid zu begehen, auch bei hoher Nachfrage weiterhin innerhalb kürzester Zeit helfen zu können.

Die Anzahl der Nachrichtenanfragen kann stark schwanken und auch durch unvorhersehbare Ereignisse plötzlich stark ansteigen. Deshalb ist es nicht möglich, solchen erhöhten Nachrichtenanfragen schlicht durch die Einstellung von mehr Krisenberater:innen entgegenzuwirken. Außerdem hat CTL als Non-Profit-Organisation auch nicht die nötigen Ressourcen dafür.

Daher setzt CTL ein Triage-System ein, das zwischen drei Risikogruppen unterscheidet: hoch, mittel und normal. Personen mit hohem Risiko haben (1) suizidale Gedanken, (2) den Plan diese umzusetzen und (3) Zugang zu den Mitteln, diesen umzusetzen. Personen mit mittlerem Risiko haben suizidale Gedanken und/oder Gedanken über Selbstverletzung. Mit einem normalen Risiko werden alle anderen Personen bewertet.

Eine Wortanalyse entscheidet über die Risikoklassifizierung

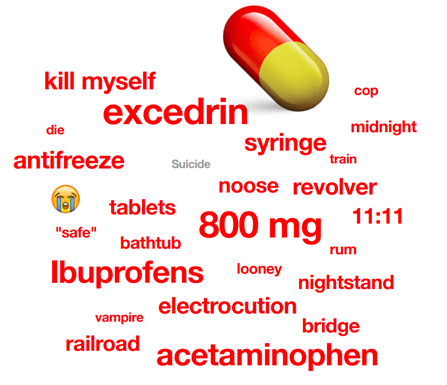

Das Besondere an diesem Triage-System ist, dass die Nachrichten automatisch von einem algorithmischen System klassifiziert werden. Diese Klassifizierung funktioniert dabei über die Analyse auf Wortebene. Wird beispielsweise das Wort „die“ (englisch für sterben) in einer Nachricht genutzt, steigt die Risikoeinschätzung für diese Nachricht. Andere Wörter haben hingegen keinen oder kaum einen Einfluss auf die Risikoeinschätzung.

Wider Erwarten hat das Wort „suicide“, zu Deutsch „Selbstmord“, einen vergleichsweise geringen Einfluss darauf, wie hoch die Risikoeinschätzung der Nachricht ausfällt. Wörter, die einen Einfluss auf die Risikoeinschätzung haben, sind sogenannte Signalwörter. Je nach genutzten Signalwörtern wird die Nachricht dann in Risikoklassen unterteilt. Entscheidend für die Qualität der Risikoklassifizierung ist also die richtige Risikoeinschätzung von Signalwörtern.

Die Signalwörter wurden dabei von CTL wie folgt bestimmt: Unter Einsatz von maschinellem Lernen wurde das System mittels eines Datensatzes trainiert, Nachrichten richtig zu klassifizieren. Dieser Datensatz bestand aus 2,8 Millionen CTL-Konversationen, die in einem Zeitraum von vier Jahren in drei Ländern geführt wurden. Diese Nachrichten wurden dann durch Krisenberater:innen in hohes, mittleres und normales Risiko eingestuft.

Interessant ist dabei, dass weniger die durch Menschen vermuteten Begriffe wie „sad“ (traurig) oder „depressed“ (deprimiert) auf suizidale Gedanken schließen lassen, sondern die stärksten Signalwörter zum Beispiel das Pillen-Emoji „?“ oder die Mengenangabe „800 mg“ sind. Wird das Pillen-Emoji in einer Nachricht verwendet, ist das Risiko, dass beispielsweise die Situation lebensbedrohlich ist 4,4 Mal höher.

Leitprinzip: mehr menschliche Berater:innen, weniger „False Negatives“ und Verzerrungen.

Bei der (Weiter)Entwicklung eines algorithmischen Systems, das über die Teilhabe von Menschen entscheidet, müssen auch immer ethische Entscheidungen getroffen werden. CTL hat für seine Arbeit drei Prinzipien festgelegt. Erstens sollen möglichst viele Menschen im Entscheidungssystem involviert sein. Das heißt zum Beispiel, dass die Krisenberater:innen immer die Möglichkeit haben, Nachrichten höher als durch das algorithmische System vorgeschlagen zu priorisieren.

Zweitens wird versucht „False Negatives“ zu minimieren, also der zu niedrigen Einschätzung des Risikos bei einer um Hilfe bittenden Person. Um dies besser feinjustieren zu können, werden die Nachrichten in einem zweistufigem Verfahren klassifiziert. Zuerst werden die Nachrichten in normales und nicht normales Risiko geteilt. In einem zweiten Schritt werden die Nachrichten mit „nicht normalem“ Risiko dann noch in die finalen Klassen hohes und mittleres Risiko geteilt.

Das dritte ethische Prinzip ist die fortlaufende Identifikation und Adressierung von demographischer Voreingenommenheit. Wird ein algorithmisches System wie bei CTL eingesetzt, das über den Zugang zu lebensrettender Hilfe (mit)entscheidet, ist es besonders wichtig, dieses regelmäßig auf mögliche algorithmische Voreingenommenheiten (BiasBias In der KI bezieht sich Bias auf Verzerrungen in Modellen oder Datensätzen. Es gibt zwei Arten: Ethischer Bias: systematische Voreingenommenheit, die zu unfairen oder diskriminierenden Ergebnissen führt, basierend auf Faktoren wie Geschlecht, Ethnie oder Alter. Mathematischer Bias: eine technische Abweichung in statistischen Modellen, die zu Ungenauigkeiten führen kann, aber nicht notwendigerweise ethische Probleme verursacht.) zu testen. Anfang 2021 wurde das System mittels einer Umfrage auf demographische Voreingenommenheit getestet. Dabei konnten die Hilfesuchenden selbst ihren demographischen Hintergrund angeben, was etwa 20 Prozent der Personen auch getan haben.

Darauf basierend wurde der Anteil des richtig erkannten hohen oder mittleren Risikos des algorithmischen Systems für die einzelnen Gruppen bestimmt. Dieser Anteil ergibt eine durchschnittliche Treffgenauigkeit des Systems von 89 Prozent. Betrachtet man nur die Gruppe „Middle Eastern, North African or Arab“, wurden hingegen nur 84 Prozent der Fälle von hohem/mittleren Risiko richtig erkannt. Das System erkennt das Risiko für Personen aus dieser Gruppe demnach um 5 Prozent schlechter als den Durchschnitt. Bei den weiteren neun Gruppen, die in dieser Untersuchung berücksichtigt wurden, lag die Trefferquote bei 89 Prozent oder höher. Auf Basis dieser Ergebnisse wurden verschiedene Schritte eingeleitet, um die Unterschiede in der Treffgenauigkeit zu adressieren.

Das System hat auch Grenzen: fehlende Kontextanalyse und fragwürdiger Datenschutz

Das System hat – abgesehen von der Trefferquote – aber auch Grenzen. Die Analyse der Texte findet rein auf Wortebene statt und lässt den Kontext der Nachrichten außen vor. Außerdem wird mit hochsensiblen Daten gearbeitet und selbst wenn die Personen ihr Einverständnis zur Weiterverarbeitung der Daten geben, tun sie das, während sie sich in einer Krisensituation befinden. Daher ist aus ethischer Sicht Vorsicht bei der Verarbeitung und Weitergabe dieser Daten geboten.

Im Januar 2022 deckte die US-amerikanische Tageszeitung Politico auf, dass CTL gesammelte Daten mit ihrer Unternehmensausgründung Loris.ai teilte. Loris.ai hilft Unternehmen dabei den Kundenservice besser zu gestalten. Ein durch maschinelles LernenMachine Learning Ein Teilbereich der KI, bei dem Systeme aus Daten lernen und sich verbessern, ohne explizit programmiert zu werden. und auf der Basis der hochsensiblen Datensätze von CTL trainiertes System unterstützt die Mitarbeitenden im Kundenservice, die Emotionen in den eingehenden Nachrichten besser zu verstehen. Das Ziel von Loris.ai ist es, Kundensupport einfühlsamer und skalierbarer zu gestalten – und damit einen Profit zu erwirtschaften.

Die Weitergabe der Daten durch die Non-Profit-Organisation CTL wurde vor allem kritisiert, weil die Datensätze nicht ausreichend anonymisiert und zu einem wirtschaftlichen Zweck eingesetzt wurden. Nach heftiger Kritik verkündete CTL nur wenige Tage später, keine Daten mehr mit Loris.ai zu teilen. Dennoch bleibt die Frage offen, wie die Weitergabe von so sensiblen Daten an ein For-Profit-Unternehmen überhaupt durch CTL genehmigt werden konnte.

Ein positives Beispiel für den gemeinwohlorientierten Einsatz von Algorithmen

Was deutlich für den Einsatz des Triage-Systems von CTL spricht, ist, dass das algorithmische System genau die Aufgaben übernimmt, in denen es gut ist: eine sehr große Menge an Entscheidungen nach den gleichen Regeln treffen. Durch den Einsatz von maschinellem Lernen konnten zudem große Mengen an zuvor gesammelten Daten ausgewertet werden. So wurden Zusammenhänge zwischen Risiko und Signalwörtern gefunden, die selbst von Expert:innen auf dem Gebiet der mentalen Gesundheit zuvor nicht vermutet worden waren.

Durch das Zusammenspiel von einem durch maschinelles Lernen trainierten algorithmischen System und ausgebildeten Krisenberater:innen kann so Menschen mit hohem und mittlerem Risiko – selbst bei zu wenig Personal für den Bedarf – in wenigen Minuten geholfen werden. Wie beispielsweise bei der US-Präsidentschaftswahl 2019: Während sich achtmal so viele Personen an CTL wendeten wie normalerweise, konnte Personen mit hohem Risiko weiterhin nach durchschnittlich 39 Sekunden geantwortet werden.

Dieser Text ist lizenziert unter einer Creative Commons Namensnennung 4.0 International Lizenz.

Kommentar schreiben