Einstieg

Basismodelle dienen als Fundament für viele verschiedene KI-Anwendungen, sei es für Chatbots, Übersetzungs- oder Bildtools. Sie können wichtige und sinnvolle (Arbeits-)Werkzeuge sein und haben in den letzten Jahren eine zentrale Rolle eingenommen. Obwohl die Systeme immer relevanter sind, besteht nach wie vor viel Intransparenz über ihre Funktionsweise und ihre Schattenseiten. Aus diesem Grund bietet diese Seite einen Überblick über das Ökosystem von KI-Basismodellen und weist auf zentrale Punkte und Herausforderungen bei ihrer Entwicklung und ihrem Einsatz hin.

Im Folgenden werden die Modelle und ihre Funktionsweisen sowie Probleme, die mit ihrer Entwicklung und ihrem Einsatz einhergehen, erklärt, um eine Übersicht über das Ökosystem „Basismodelle“ zu bieten.

Zum exemplarischen Vergleich

Die Entwicklung von KI-Basismodellen lässt sich wie ein komplexes Ökosystem verstehen, in dem alle Ebenen eng miteinander verbunden sind und wie in der Natur aufeinander aufbauen:

- Trainingsdaten bilden den „Nährboden“ – wie Mikroorganismen bereiten sie den Boden.

- Basismodelle wurzeln in diesen Daten und erkennen Muster.

- Daraus „wachsen“ vielfältige Anwendungen, wie Chatbots oder Übersetzungstools, ähnlich wie Bäume.

Dieses Bild des Ökosystems zeigt, dass jede Schicht – von den Trainingsdaten über die Basismodelle bis hin zu den Anwendungen – eine zentrale Rolle spielt und voneinander abhängig ist. Nur ein vielfältiger, gut kuratierter Nährboden ermöglicht ein starkes, fair verwurzeltes KI-Ökosystem, das positive Auswirkungen auf die Gesellschaft hat und möglichst viele Perspektiven berücksichtigt.

Wichtige Konzepte erklärt

Foundation Models: die Basis moderner KI-Anwendungen

Foundation Models, auf Deutsch auch „Basismodelle“ oder „Grundlagenmodelle“ bezeichnet, bilden das Fundament für zahlreiche KI-Anwendungen.

Basismodelle sind große KI-Modelle, die auf umfangreichen Datensätzen trainiert werden und verschiedene Aufgaben erledigen können, ohne für jede Aufgabe speziell programmiert zu werden. Anders als bei Systemen, denen Regeln explizit vorgegeben werden, „lernen“ Basismodelle diese Regeln selbstständig aus den Trainingsdaten. Dazu werden sie mit riesigen Mengen an Informationen aus dem Internet, Büchern und anderen Quellen „gefüttert“ und erkennen auf dieser Grundlage Muster und Zusammenhänge, anhand derer sie „neuen“ Output generieren bzw. erstellen können, sei es Texte oder Bilder (siehe Sprachmodell oder Bildmodell).

Wichtigste Merkmale:

- Größe: Sie bestehen oft aus Milliarden von Parametern, die die Mustererkennung und Vorhersagen des Modells ermöglichen.

- Vielseitigkeit: Ein einzelnes Modell kann für verschiedene Aufgaben eingesetzt werden.

- Transfer Learning: Das Gelernte lässt sich auf neue, unbekannte Aufgaben übertragen.

- Selbstüberwachtes Lernen: Sie lernen oft ohne menschliche Annotation der Trainingsdaten, also ohne zusätzliche Kennzeichnungen der Trainingsdaten, die ihnen die Bedeutung der Daten „erklären“ würden.

Funktionsweise

Datensammlung

Zunächst sammeln Entwickler:innen bzw. Unternehmen enorme Mengen diverser Daten, dies können zum Beispiel Millionen von Texten aus dem Internet, Büchern und Artikeln sein.

Vortraining

In dieser Phase „lernt“ das Modell grundlegende Muster und Zusammenhänge. Ein Sprachmodell erfasst beispielsweise Sprachstrukturen und kontextuelle Bedeutungen, die in vielen verschiedenen Zusammenhängen nützlich sein können.

Feature Extraktion

Bei diesem Schritt wird das Modell darauf trainiert, wesentliche Informationen aus Eingabedaten zu filtern. Bei einem Satz wie „Der alte Hund spielte fröhlich im sonnigen Park“ werden zum Beispiel Kernelemente wie Subjekt, Handlung und Kontext identifiziert.

Finetuning

Abschließend wird das vortrainierte Modell für spezifische Anwendungen optimiert. Ein allgemeines Sprachmodell könnte beispielsweise mit Organisationsdokumenten spezialisiert werden, um die Fachsprache zu erlernen und in einem Chatbot eingesetzt zu werden, der kontextbezogene Antworten auf organisationsspezifische Anfragen liefern kann.

Anwendungsbereiche

Grundlagenmodelle finden in zahlreichen Bereichen Anwendung:

Natürliche Sprachverarbeitung

Textgenerierung, Übersetzung, Sentimentanalyse, also das automatische Erkennen von Stimmungen und Meinungen. Diese Modelle nennt man auch Sprachmodelle

Computer Vision

Bilderkennung, Objektdetektion, Bildsegmentierung, also die Unterteilung eines Bildes in relevante Bereiche oder Objekte. Diese Modelle nennt man auch Bildmodelle

Multimodale Anwendungen

Text-zu-Bild-Generierung, visuelle Frage-Antwort-Systeme. Siehe Multimodale Modelle

Transformer-Architektur: Das „Gehirn“ hinter den Modellen

Transformer sind wie das „Gehirn“ der bisher beschriebenen Modelle und bilden die Architektur für neuronale Netze. Sie ermöglichen den Modellen, wichtige Informationen und Muster zu erkennen und miteinander zu verknüpfen.

Transformer werden für viele KI-Modelle verwendet, von Sprachverarbeitung bis hin zur Bildanalyse.

Kernkonzept

Transformer basieren auf dem Prinzip der „Selbstaufmerksamkeit“ (Self-Attention), um Zusammenhänge in Daten zu erkennen. Ähnlich wie ein Mensch beim Lesen wichtige Wörter besonders beachtet, kann ein Transformer die Bedeutung einzelner Elemente im Kontext des Ganzen „verstehen“.

So können sie die Bedeutung eines Elements (z. B. ein Wort oder ein Bildteil) im Kontext aller anderen Elemente verstehen.

Dies geschieht durch einen Mechanismus, indem das Modell seine Aufmerksamkeit gezielt auf die relevantesten Teile der Eingabe richtet.

Wie funktioniert das?

- Das Modell analysiert jedes Element (z. B. ein Wort) in Beziehung zu allen anderen Elementen.

- Dabei gewichtet es, wie wichtig die anderen Elemente für das Verständnis sind.

- So entstehen Verknüpfungen zwischen zusammenhängenden Elementen.

Ein Beispiel: Im Satz „Der Hund, der die Katze jagte, war groß“ erkennt das Modell:

- „war“ gehört stark zu „Hund“ (Wer war etwas? → der Hund)

- „war“ gehört auch zu „groß“ (Was war der Hund? → groß)

- Die Information über die Katze ist für „war“ weniger wichtig

Durch diese Verknüpfungen „versteht“ das Modell den Zusammenhang: Es geht um einen großen Hund.

Dieser Prozess wird für jedes Element im Text wiederholt, sodass das Modell die Bedeutung des gesamten Textes erfassen kann.

Die Trainingsdaten – das Fundament der Modell

Trainingsdaten bilden den „Nährboden“ für Basismodelle – ähnlich wie Mikroorganismen den Boden für Pflanzen bereiten. Diese Daten sind die Grundlage, aus der die Modelle Muster erkennen und lernen, Aufgaben wie Textgenerierung zu bewältigen. Die Beschaffung dieser Daten erfolgt häufig durch Web Scraping, also das automatisierte Sammeln von Informationen aus dem Internet. Der Umfang ist dabei enorm: Eines der größten Trainingsdatensets umfasst Material von 15 Millionen verschiedenen Web-Adressen.

Diese Praxis wirft jedoch rechtliche und ethische Fragen auf: Viele der genutzten Quellen sind urheberrechtlich geschützt. Ein aktuelles Beispiel ist die Klage der „New York Times“ gegen OpenAI und Microsoft wegen der unautorisierten Nutzung ihrer Inhalte zum Training von KI-Modellen. Auch verzerrte Datensätze, die zu problematischen Ergebnissen führen können, spielen eine zentrale Rolle. Mehr dazu im Kapitel “Übersehene Probleme”.

Deep Dive: Verschiedene Arten von Basismodellen erklärt

Sprachmodelle

Sprachmodelle sind spezialisierte Basismodelle, die darauf ausgelegt sind, menschliche Sprache zu „verstehen“, zu verarbeiten und zu generieren. Sie bilden das Herzstück vieler moderner Textverarbeitungstechnologien.

Kernmerkmale:

- Textverständnis: Sie können den Kontext und die Bedeutung von Wörtern und Sätzen erfassen – auf Basis statistischer Muster.

- Textgenerierung: Sie können kohärente und sinnvolle Texte erzeugen.

- Lernfähigkeit: Sie werden mit großen Mengen an Textdaten trainiert.

- Vielseitigkeit: Ein Modell kann für verschiedene sprachbezogene Aufgaben eingesetzt werden.

Funktionsweise

Sprachmodelle berechnen Wahrscheinlichkeiten für Wortsequenzen basierend auf ihren Trainingsdaten. Sie „lernen“ Muster und Strukturen der Sprache und übertragen diese auf neue Situationen, haben aber kein Verständnis für den jeweiligen Kontext. Das Konzept des „Stochastischen Papageis“, wie es von Emily Bender, Timnit Gebru, Angelina McMillan-Major und Margaret Mitchell geprägt wurde, verdeutlicht, dass diese Modelle letztlich nur sprachliche Muster nachahmen, ohne die zugrunde liegende Bedeutung zu erfassen. Wie ein Papagei wiederholen sie statistisch wahrscheinliche Kombinationen aus ihren Trainingsdaten, ohne den Inhalt wirklich zu erfassen. Diese „Nachahmung“ kann zu problematischen Ergebnissen führen wie:

- verzerrte oder unangemessene Antworten, besonders in sensiblen Bereichen

- erfundene Informationen und Quellen („Halluzinationen“)

- fehlende Verlässlichkeit bei der Faktentreue

Mehr dazu im Kapitel “Übersehene Probleme”.

Anwendungsbereiche

Sprachmodelle finden in zahlreichen Bereichen Anwendung:

- Maschinelle Übersetzung: automatische Übersetzung zwischen verschiedenen Sprachen

- Chatbots und virtuelle Assistenten: Interaktion mit Menschen in natürlicher Sprache

- Textzusammenfassung: automatische Erstellung von Zusammenfassungen längerer Texte

- Sentimentanalyse: Erkennung der Stimmung oder Meinung in Texten

Bildmodelle

Technisch gesehen handelt es sich bei Bildmodellen um Basismodelle, die darauf spezialisiert sind, visuelle Informationen zu verarbeiten, zu analysieren und zu generieren. Sie bilden die Grundlage für viele Anwendungen im Bereich Computer Vision und Bildverarbeitung.

Kernmerkmale

- Bilderkennung: Fähigkeit, Objekte, Personen oder Szenen in Bildern zu identifizieren

- Bildklassifizierung: Einordnung von Bildern in vordefinierte Kategorien.

- Objektdetektion: Lokalisierung und Identifizierung spezifischer Objekte in Bildern, wie beispielsweise eine Katze, ein Hund oder verschiedene Autos.

- Bildsegmentierung: Unterteilung eines Bildes in Regionen, beispielsweise bei einem Bild eines Stadtparks würden Segmente wie Himmel, Bäume und See entstehen.

- Bildgenerierung: Erstellung neuer Bilder basierend auf Beschreibungen oder Vorgaben.

Funktionsweise

Bildmodelle basieren oft auf neuronalen Netzwerken zur Bildgenerierung. Sie lernen Bilder schrittweise darzustellen: von einfachen Elementen wie Kanten und Texturen bis hin zu komplexen Objekten und Szenen. Ähnlich wie bei Sprachmodellen erfassen sie jedoch nicht die tatsächliche Bedeutung der Inhalte, sondern erkennen Muster und wiederholen diese auf Grundlage statistischer Wahrscheinlichkeiten aus den Trainingsdaten, ohne die semantische Bedeutung eines Bildes zu erfassen. Dadurch können sie zwar beeindruckende Ergebnisse liefern, sind aber auch anfällig dafür, Muster zu verzerren oder falsch zu interpretieren. Das passiert besonders, da Trainingsdaten oftmals einseitig oder nicht ausreichend divers sind. Das zeigt sich dann etwa bei der Generierung von Bildern, die überwiegend männliche weiße Ärzte darstellen, während andere ethnische Gruppen oder Geschlechter unterrepräsentiert sind. Mehr dazu im Kapitel “Übersehene Probleme”.

Anwendungsbereiche

- Medizinische Bildgebung: Unterstützung bei der Diagnose durch Analyse medizinischer Bilder

- Autonomes Fahren: Erkennung von Straßen, Verkehrszeichen und anderen Verkehrsteilnehmer:innen

- Sicherheit und Überwachung: Gesichtserkennung, Anomalieerkennung in Videoaufnahmen

Multimodale Modelle: Die Multitalente

Multimodale Modelle sind Systeme, die gleichzeitig auf visuelle, sprachliche und akustische Signale reagieren können. Sie „verstehen“, verarbeiten und kombinieren verschiedene Arten von Informationen, wie etwa Text, Bild und Ton.

Deshalb stellen multimodale Modelle einen weiteren Fortschritt in der Entwicklung von KI-Systemen dar, indem sie die Fähigkeiten von spezialisierten Modellen wie Sprachmodellen und Bildmodellen kombinieren.

Kernkonzept

Der zentrale Aspekt multimodaler Modelle liegt in ihrer Fähigkeit, unterschiedliche Datentypen wie Texte, Bilder, Audio und Video zu erfassen und zu interpretieren. Dies ermöglicht ein ganzheitliches und kontextreicheres Verständnis von Inhalten, das über die Möglichkeiten einzelner, spezialisierter Modelle hinausgeht.

Funktionsweise

Multimodale Modelle nutzen fortschrittliche Architekturen, die angepasst wurden, um verschiedene Eingabetypen zu verarbeiten. Sie „lernen“, wie diese verschiedenen Datenarten zusammenhängen, sodass sie Informationen übergreifend verknüpfen und analysieren können. Dabei nutzen sie die Stärken spezialisierter Modelle und können zusätzlich verschiedene Datentypen miteinander verbinden. Ein Beispiel dafür ist ein Sprachassistent, der gesprochene Sprache (Ton) in Text umwandelt und dann Informationen aus Bildern und Texten kombiniert, um eine passende Antwort zu geben.

Allerdings gelten für multimodale Modelle die gleichen Einschränkungen wie für Sprach- und Bildmodelle. Sie erkennen Muster in den Trainingsdaten und wenden diese an, ohne tatsächlich zu verstehen, was sie verarbeiten. Dies kann zu Verzerrungen oder fehlerhaften Interpretationen führen, besonders wenn die Trainingsdaten unausgewogen oder nicht repräsentativ sind (siehe verzerrte Trainingsdaten)

.

Anwendungsbereiche

Die Einsatzmöglichkeiten für multimodale Modelle sind vielfältig und umfassen:

- visuelle Frage-Antwort-Systeme, die Textfragen zu Bildern beantworten können

- Text-zu-Bild-Generierung, bei der aus textuellen Beschreibungen Bilder erzeugt werden

- Videoanalyse mit Berücksichtigung von Bild, Ton und Untertiteln

- multimodale Sentimentanalyse, die Text und Sprache kombiniert

- Robotik, wo verschiedene Sensordaten integriert werden müssen

Übersehene Probleme: Ressourcenverbrauch, Arbeitsbedingungen und verzerrte Daten

Ökologische Schattenseiten: vom Stromverbrauch bis zum Wasserbedarf

Bei der Entwicklung und dem Einsatz von KI-Modellen wird oft nur an Bits und Bites gedacht. Doch der Ressourcenverbrauch ist enorm und hat reale Konsequenzen für die Umwelt – seien es der hohe Wasserverbrauch, die Rohmaterialen und die Energie zur Herstellung der Hardware.

Ein paar Zahlen:

- Der Betrieb von ChatGPT im März 2024 hat etwa 700.000 Liter Frischwasser und so viel Energie verbraucht wie 180.000 US-Haushalte.

- Das Erzeugen eines Bildes mit einem Bildmodell verbraucht so viel Energie wie das vollständige Aufladen eines Smartphones.

- Das Training des Modells BERT erzeugte etwa so viele Emissionen, wie sie fünf Autos über ihren gesamten Produktlebenszyklus erzeugen würden.

- Ein „Gespräch“ mit ChatGPT erfordert etwa einen halben Liter Wasser.

- Für die Kühlung der Google-Rechenzentren in den USA wurden 2021 rund 12,7 Milliarden Liter Frischwasser benötigt.

Die Hauptursache für diesen Ressourcenverbrauch liegt in der Größe und Komplexität der Basismodelle: Je größer und komplexer ein Modell, desto mehr Energie, Wasser und Hardware werden benötigt. Gleichzeitig hängt der ökologische Fußabdruck auch sehr davon ab, wie effizient das Training und der Betrieb dieser Modelle gestaltet sind. Neben der Energie und dem Wasser, die für den Betrieb benötigt werden, spielt auch die Produktion der benötigten Hardware eine Rolle. Hier werden seltene Rohstoffe und Metalle verbraucht, deren Abbau und Verarbeitung wiederrum zu Umweltbelastungen- und schäden führen.

Aktuell fehlen jedoch viele konkrete Daten zum Ressourcenverbrauch von KI-Modellen, da Unternehmen oft nicht offenlegen, wie viel Energie oder Wasser in ihren Prozessen verbraucht wird. Auch die Emissionen, die während der Entwicklung entstehen, werden selten genau dokumentiert.

Wie bei den Trainingsdaten zeigt sich auch beim Ressourcenverbrauch, dass es dringend mehr Transparenz braucht. Nur so lassen sich Maßnahmen entwickeln, um die genannten Umweltbelastungen spürbar zu reduzieren – etwa durch kleinere und sparsamere Modelle sowie energieeffizientere Rechenzentren. Auch gesetzliche Vorgaben könnten hier helfen: etwa die Verpflichtung der Unternehmen zur Offenlegung ihres Ressourcenverbrauchs sowie zur energieeffizienteren und ressourcenschonenden Entwicklung und Nutzung von KI-Modellen.

Ausbeutung im Schatten der Automatisierung: die Menschen hinter den Modellen

KI-Modelle erwecken den Eindruck, vollständig automatisierte Anwendungen zu sein, doch in Wirklichkeit sind sie auf die akribische Arbeit von menschlichen Arbeitnehmer:innen angewiesen. Denn das Training von großen KI-Modellen verlangt eine Unmenge menschlicher Arbeit und die hat ihren Preis. Deswegen verlassen sich Technologiefirmen auf günstige Arbeitskräfte in Ländern, in denen Arbeiter:innen kaum vor ausbeuterischen Praktiken geschützt werden. Ihre Aufgaben bestehen darin, Daten zu labeln und KI-Ergebnisse zu überprüfen und zu bewerten. In einer Investigativrecherche wurde aufgedeckt, dass auch OpenAI auf günstige Arbeitskräfte aus dem globalen Süden zurückgreift.

Für die Entwicklung seines textbasierten Chatbots ChatGPT hat das Unternehmen Arbeiter:innen in Kenia eingesetzt, die weniger als 2 US-Dollar pro Stunde verdienten. Ihre Aufgabe war es, besonders gefährliche und schädliche Inhalte herauszufiltern. Sie sahen sich tagtäglich mit detaillierten Beschreibungen von sexuellem Kindesmissbrauch, Mord oder Selbstverletzung konfrontiert. Eine Arbeitskraft beschrieb die traumatischen Arbeitsbedingungen als „Folter“.

KI-Systeme sind zwar technologisch fortschrittlich, aber ohne menschliche Annotationen, also das Markieren und Beschreiben von Daten, wären sie nicht in der Lage, Objekte in der realen Welt zu erkennen. Die Arbeitsteilung ist global: Firmen aus wohlhabenden Ländern wie den USA und Deutschland entwickeln KI-Systeme, während die eigentliche Vorbereitung der Trainingsdaten, also etwa die annotierten Daten, von Menschen in Ländern wie Indien oder Kenia bereitgestellt werden. Diese Arbeitsteilung trägt zu einer wirtschaftlichen Ungleichheit bei: Während die hochqualifizierten und besser entlohnten Tätigkeiten der KI-Entwicklung in wohlhabenden Ländern, meist des Globalen Nordens, angesiedelt sind, wird die zeitintensive und oft geringer bezahlte Aufgabe der Datenannotation und -bereinigung an Menschen in wirtschaftlich schwächere Regionen – meist im Globalen Süden – ausgelagert, die selten von dem technischen Fortschritt, den sie ermöglichen, profitieren.

Die Frage, wie wir faire Arbeit auch beim Training von KI-Systemen sicherstellen, bleibt derzeit offen – es gibt mittlerweile aber erste Proteste und Gegenbewegungen, wie zum Beispiel die Gründung einer Gewerkschaft in Kenia zeigt.

Verzerrte Trainingsdaten

Eine weitere Herausforderung bei der Sammlung von Daten für das Training von Basismodellen ist, dass oftmals bestimmte Quellen überrepräsentiert sind und die Vielfalt von verschiedenen Kulturen, Geschlechtern und sozialen Gruppen nicht angemessen in den Daten abgebildet wird. Einseitige oder unvollständige Datengrundlagen können dann etwa dazu führen, dass im Output von KI-Modelle bestimmte Gruppen oder Perspektiven bevorzugt werden und so die Vielfalt und Komplexität der Gesellschaft nicht angemessen repräsentiert wird oder bestimmte Perspektiven marginalisiert werden. Die zum Training der Basismodelle verwendeten Daten spiegeln überwiegend westliche und patriarchale Perspektiven und Werte wider. Verzerrungen (Biases) sind also vorprogrammiert und unzählige Beispiele zeigen, dass die Modelle bestehende Vorurteile und Stereotypen nicht nur reproduzieren, sondern sogar verstärken: von Fällen geschlechterbasierter Gewalt in generativen KI-Modellen über Geschlechterbias in von Sprachmodellen generierten Empfehlungsschreiben bis hin zu rassistischen Ratschlägen und stereotypen Darstellungen von Ärzt:innen und anderen Berufsgruppen. Auch gibt es Studien, die belegen, dass von KI-Systemen generierte Verzerrungen das Verhalten einer Person nachhaltig beeinflussen können – selbst nachdem sie das Programm nicht mehr nutzt.

Die Beschaffenheit der Trainingsdaten beeinflussen also die Qualität und Fairness des gesamten Basismodell-Ökosystems. Wenn das Fundament eines Hauses schief ist, werden auch die darauf gebauten Wände wackeln. So ist es auch bei KI-Modellen: Wenn die Trainingsdaten bereits Verzerrungen und Fehler enthalten, setzen sich diese in den Anwendungen, die auf diesen Modellen basieren, fort.

Die meisten KI-Unternehmen dokumentieren nicht, wie sich ihre Trainingsdatensätze konkret zusammensetzen, was zu einer großen Intransparenz führt, da man nicht weiß, welche Daten in den Trainingsdatensätzen stecken und wie sie zusammengestellt wurden. Und es folglich auch für Entwickler:innen, Forscher:innen und andere schwierig ist, Verzerrungen zu adressieren, schädliche Inhalte aus den Daten zu entfernen oder urheberrechtlich geschützte Inhalte zu identifizieren.

Weitere Herausforderungen – und wie sie adressiert werden können

- Ethik und Fairness: Vorurteile und Ungleichheiten aus den Trainingsdaten können von dem Modell übernommen und verstärkt werden, siehe verzerrte Trainingsdaten. Um sicherzustellen, dass die Modelle fair und transparent eingesetzt werden, sollten wir uns besonders mit Bias, also Vorurteilen, unter anderem in den Daten auseinandersetzen, Fairness fördern und dafür sorgen, dass die Modelle interpretierbar und erklärbar sind.

- Datenschutz und Sicherheit: Die Verwendung urheberrechtlich geschützter Daten im Training kann rechtliche Probleme verursachen. Beim Training und Einsatz von KI-Modellen wird es wichtig sein, persönliche Daten zu schützen und Techniken zu entwickeln, um Missbrauch zu verhindern.

- Ressourcenmanagement: Sowohl das Training und als auch der Einsatz erfordern viel Rechenleistung und Energie und belasten dadurch die Umwelt erheblich, siehe Ressourcenverbrauch. Um den hohen Energie- und Rechenbedarf für das Training und Betrieb von KI-Modellen zu bewältigen, müssen Ressourcen schonender eingesetzt werden und umweltfreundlichere Technologien entwickelt werden.

- Regulierung: Um einen verantwortungsvollen Umgang mit KI zu gewährleisten, müssen rechtliche Rahmenbedingungen an die sich schnell entwickelnden Technologien angepasst und globale Standards für die Entwicklung und den Einsatz von KI etabliert werden – zum Beispiel die Offenlegung von Trainingsdaten und -methoden.

- Zuverlässigkeit und Robustheit: Man kann sich diese Modelle wie eine Black Box vorstellen: Sie liefern uns zwar Ergebnisse, aber es ist oft nicht nachvollziehbar, wie sie zu diesen gekommen sind. Um das Vertrauen in KI-Systeme zu stärken, sollte daran gearbeitet werden, dass zum einen ihre Ergebnisse konsistenter und zuverlässiger, aber auch ihre Fehlbarkeit deutlich wird. Zum anderen spielt dabei der Aufbau von Kompetenzen im Umgang mit KI eine zentrale Rolle. Dazu sollten Methoden entwickelt werden, um mit Unsicherheiten, zum Beispiel hervorgerufen durch unvollständige Daten und unbekannte Situationen, die nicht den Trainingsdaten angelegt sind, besser umgehen zu können.

Mapping: Basismodelle im exemplarischen Vergleich (Stand August 2024)

Dieser Abschnitt bietet eine exemplarische Übersicht verschiedener Basismodelle, basierend auf zentralen Kriterien:

- Ziel der Entwicklung und Anwendungsfälle

- Modellarchitektur und Größe

- Offenheit, technische Dokumentation und Interoperabilität

- Trainingsdaten, Datenqualität, Ethik und Fairness

- Datenschutz und Sicherheit

- Ressourcenverbrauch

GPT (OpenAI)

- Entwicklung

- Architektur

- Offenheit

- Trainingsdaten & Ethik

- Datenschutz

Ziel der Entwicklung:

- Vielseitige Sprachverarbeitung und -generierung: GPT wurde entwickelt, um menschenähnliche Konversationen zu führen, und bildet die Grundlage für die Anwendung „ChatGPT“, einen Chatbot, der als virtueller Assistent bei einer Vielzahl von Aufgaben unterstützen soll.

Anwendungsfälle:

- Textgenerierung, Übersetzung, Zusammenfassungen

- Konversations-KI: Kundenservice und Support, Chatbots für Websites

- Erstellung von jeglichem Content, wie das Verfassen von Artikeln oder Blog Posts

LLaMA (Meta)

- Entwicklung

- Architektur

- Offenheit

- Trainingsdaten & Ethik

- Datenschutz

Ziel der Entwicklung:

- LLaMA ist ein Forschungsmodell, das entwickelt wurde, um die Grenzen der Sprachmodellforschung zu erweitern und Zugang zu leistungsstarken Modellen für akademische Zwecke zu bieten.

Anwendungsfälle:

- Forschung

- Experimentelle Studien zur Sprachmodellierung

- Entwicklung neuer Algorithmen für Sprachverarbeitung

BLOOM (Hugging Face)

- Entwicklung

- Architektur

- Offenheit

- Trainingsdaten & Ethik

- Datenschutz

Ziel der Entwicklung:

- Bloom wurde als Open-Source-Modell entwickelt, um mehrsprachige Sprachverarbeitung und Forschung zu unterstützen.

Anwendungsfälle:

- Mehrsprachige Textgenerierung

- Übersetzung und sprachliche Analyse

- Forschung im Bereich der natürlichen Sprachverarbeitung

Claude (Anthropic)

- Entwicklung

- Architektur

- Offenheit

- Trainingsdaten & Ethik

- Datenschutz

Ziel der Entwicklung:

- Claude wurde entwickelt, um möglichst sichere und verlässliche KI-gestützte Konversationen zu ermöglichen, mit einem Fokus auf ethische KI.

Anwendungsfälle:

- Chatbots für sichere Kommunikation

- Anwendungen im Bereich Ethik und KI-Sicherheit

- Unterstützung in beratenden Rollen oder als Assistenz

PaLM (Google)

- Entwicklung

- Architektur

- Offenheit

- Trainingsdaten & Ethik

- Datenschutz

Ziel der Entwicklung:

- Die Entwicklung von PaLM zielt darauf ab, ein umfassendes Verständnis der menschlichen Sprache zu entwickeln und komplexe Aufgaben der Sprachverarbeitung zu lösen.

Anwendungsfälle:

- Fortgeschrittene Sprachverarbeitung

- Multimodale Anwendungen

- Anwendungen in der Forschung zur Sprachverarbeitung

Stable Diffusion (Stability AI)

- Entwicklung

- Architektur

- Offenheit

- Trainingsdaten & Ethik

- Datenschutz

Ziel der Entwicklung:

- Stable Diffusion wurde entwickelt, um hochwertige, generative Bilder zu erzeugen und kreative Prozesse in der digitalen Kunst zu unterstützen.

Anwendungsfälle:

- Künstlerische Bildgenerierung

- Kreative Projekte im Bereich Grafikdesign

- Experimentelle Kunst und visuelle Medien

DALL-E (OpenAI)

- Entwicklung

- Architektur

- Offenheit

- Trainingsdaten & Ethik

- Datenschutz

Ziel der Entwicklung:

- DALL-E wurde entwickelt, um aus Textbeschreibungen kreative und realistische Bilder zu generieren

Anwendungsfälle:

- Kreative Tools für Designer:innen und Künstler:innen

- Visuelle Unterstützung in Marketing und Werbung

- Experimentelle Anwendungen in der Bildgestaltung

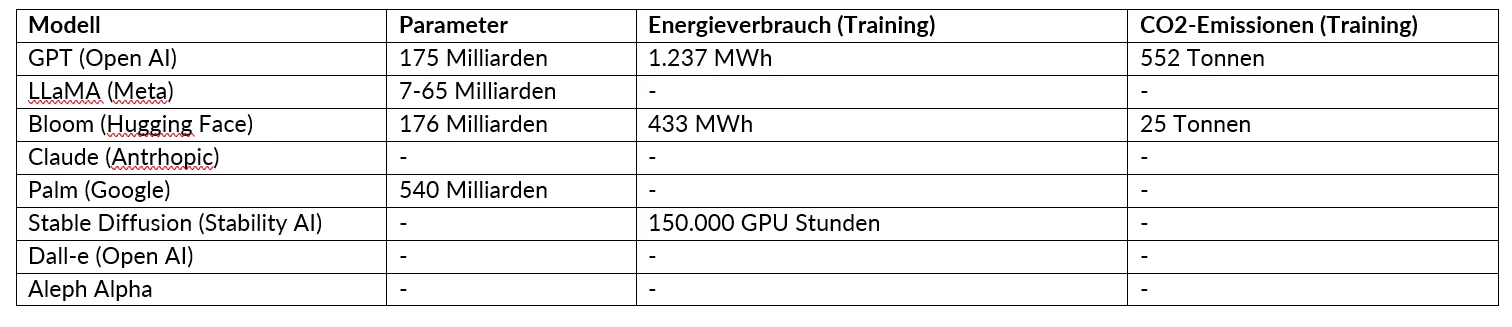

Ressourcenverbrauch (Stand August 2024)

Die Lücken in der Tabelle zeigen, dass aktuell viele konkrete Daten zum Ressourcenverbrauch von KI-Modellen fehlen, da die Unternehmen diese Informationen oft nicht offenlegen. Diese Lücken verdeutlicht den dringenden Handlungsbedarf, mehr Transparenz über die Modelle und ihre Entwicklungsprozesse zu schaffen. Weitere Informationen im Kapitel “Ökologische Schattenseiten: vom Stromverbrauch bis zum Wasserbedarf”.

Für einen besseren Vergleich der einzelnen Modelle können Sie die Vergleichstabelle als PDF herunterladen. Nutzen Sie dazu einfach die Schaltfläche „Download“.

Der Text und die Grafiken dieser Seite sind lizenziert unter der Creative Commons Namensnennung 4.0 International (CC BY 4.0) Lizenz. Den vollständigen Lizenztext finden Sie unter: https://creativecommons. org/licenses/by/4.0/legalcode.de .