Im Rahmen des Kooperationsprojektes “Algorithmen fürs Gemeinwohl” von Stiftung Neue Verantwortung und Bertelsmann Stiftung haben wir die Chancen und Risiken algorithmischer Systeme sektorübergreifend diskutiert. Nach der Auseinandersetzung mit den drei Anwendungsbereichen Predictive Policing, Robo Recruiting und Gesundheits-Apps stellt Leonie Beining in einem neuen Arbeitspapier die verschiedenen Dimensionen von Nachvollziehbarkeit algorithmischer Systeme vor.

In der US-amerikanischen Stadt Boston musste die Schulbehörde ein Projekt zur Umgestaltung der Schulbusrouten und Unterrichtszeiten wieder einstampfen, nachdem es von Seiten der Eltern zu großen Protesten gekommen war. Ein Team des Massachusetts Institute of Technology (MIT) hatte den Auftrag bekommen, mit Hilfe von Algorithmen ein neues System zu entwickeln, das eine bessere Auslastung der Busse, kürzere Fahrzeiten, weniger CO2-Emissionen, Anpassungen in den Unterrichtszeiten, insbesondere einen späteren Schulbeginn für ältere Schüler und früheres Unterrichtsende für die jüngeren, sowie insgesamt eine gerechtere Verteilung der Abfahrtzeiten zwischen privilegierten und ärmeren Schulbezirken versprach. Obwohl sich die Stadt während des Projekts stets darum bemühte, die Öffentlichkeit auf dem Laufenden zu halten, waren die Familien von den durch das algorithmische Entscheidungssystem erzeugten Veränderungen vollkommen überrascht. Es kam zu Demonstrationen und eine Petition wurde gestartet, um das neue System abzuwenden.

Das Beispiel unterstreicht, dass es für die gesellschaftliche Akzeptanz von algorithmischen Entscheidungssystemen (Algorithmic Decision Making, ADM) äußerst wichtig sein kann, ihren Einsatz und ihre Funktionsweise auch für diejenigen transparent und nachvollziehbar zu machen, die von ihnen betroffen sind.

Allgemeine Forderungen müssen konkretisiert werden

Forderungen nach Transparenz und Nachvollziehbarkeit bestimmen daher längst die politische Debatte über ADM in Deutschland sowie auf europäischer und internationaler Ebene. Auch das im Oktober 2019 vorgestellte Gutachten der Datenethikkommission identifiziert konkrete Anforderungen an die Transparenz und Nachvollziehbarkeit für Betroffene. Doch die Forderungen und Bestimmungen bleiben oftmals abstrakt. Das vorliegende Papier möchte zur Vertiefung der Debatte beitragen, indem es die Begriffe Transparenz und Nachvollziehbarkeit weiter konkretisiert. Dazu wirft es auch einen Blick in drei verschiedene Anwendungsbereiche von algorithmischer Entscheidungsfindung, die für unser gesellschaftliches Zusammenleben zentral sind und im Rahmen des Projektes vertiefend behandelt wurden: öffentliche Sicherheit, Personalwesen und Gesundheit. Wie kann Nachvollziehbarkeit hier für Bürger:innen, Bewerber:innen und Patient:innen hergestellt werden? Ziel ist es, das Thema Transparenz und Nachvollziehbarkeit an praktischen Beispielen zu erörtern und damit greifbarer zu machen. Am Ende des Papiers steht daher eine Checkliste für mehr Nachvollziehbarkeit von ADM sowie Empfehlungen für politische Entscheidungsträger und Stellen, die algorithmische Systeme einsetzen. Auf diese Weise gestaltet sich unser abschließendes Impulspapier gleichermaßen praxisnah und lösungsorientiert über die Grenzen spezifischer Anwendungsfälle hinweg.

Vielfältige Chancen von Nachvollziehbarkeit gegenüber Betroffenen

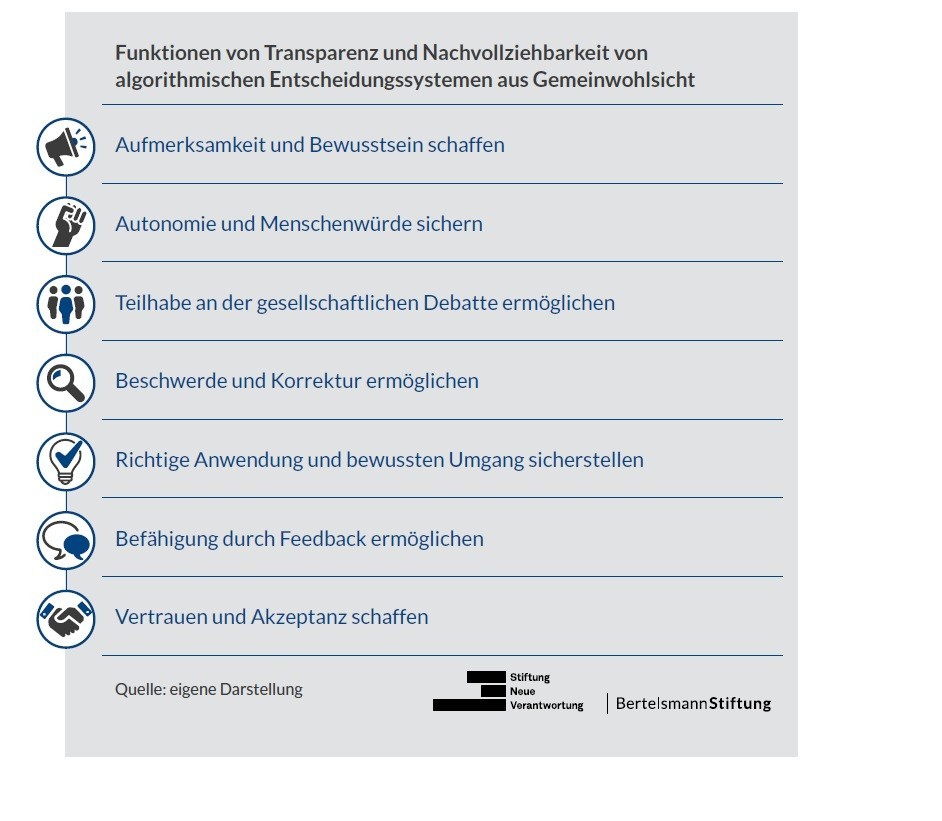

Algorithmische Systeme gegenüber Betroffenen verständlich zu machen, bringt vielfältige Chancen mit sich. Durch die Analyse der Fallbeispiele ließen sich folgende Funktionen von Transparenz und Nachvollziehbarkeit identifizieren:

Da in den verschiedenen Bereichen verschiedene Rechte und Interessen der Betroffenen berührt werden, sind auch Ziele und somit Form und Umfang der geforderten Transparenz jeweils stark unterschiedlich. Beispielsweise ist es denkbar, dass Vertrauen in Predictive Policing Systeme der Polizei vor allem voraussetzt, dass Bürger:innen genau wissen, welche Daten in das System einfließen, wofür sie eingesetzt werden und wofür nicht. Bei Gesundheits-Apps geht es vor allem darum, das richtige Maß an Vertrauen in die Qualität der automatisiert generierten Ergebnisse zu schaffen, um eine richtige Anwendung sicherzustellen. Hier gilt es, genau zu untersuchen, um welche Ziele es in den Sektoren jeweils geht und welche Form von Nachvollziehbarkeit benötigt wird, um das entsprechende Ziel zu erreichen.

Da in den verschiedenen Bereichen verschiedene Rechte und Interessen der Betroffenen berührt werden, sind auch Ziele und somit Form und Umfang der geforderten Transparenz jeweils stark unterschiedlich. Beispielsweise ist es denkbar, dass Vertrauen in Predictive Policing Systeme der Polizei vor allem voraussetzt, dass Bürger:innen genau wissen, welche Daten in das System einfließen, wofür sie eingesetzt werden und wofür nicht. Bei Gesundheits-Apps geht es vor allem darum, das richtige Maß an Vertrauen in die Qualität der automatisiert generierten Ergebnisse zu schaffen, um eine richtige Anwendung sicherzustellen. Hier gilt es, genau zu untersuchen, um welche Ziele es in den Sektoren jeweils geht und welche Form von Nachvollziehbarkeit benötigt wird, um das entsprechende Ziel zu erreichen.

Dieser Artikel ist lizenziert unter einer Creative Commons Namensnennung 4.0 International Lizenz.

Kommentar schreiben