Die Diskussion über die gesellschaftlichen Auswirkungen von Algorithmen hat an Fahrt angenommen. Neben unseren Algo.Rules wurden eine Vielzahl an Leitlinien für die ethische Gestaltung sogenannter „Künstlicher Intelligenz“ (KI) durch Akteure aus Wirtschaft, Zivilgesellschaft, Wissenschaft und Politik veröffentlicht. Offen bleibt aktuell jedoch die Frage, wie die darin enthaltenen Prinzipien konkret umgesetzt werden sollen. In Kooperation mit der gemeinnützigen Normierungsorganisation VDE schließen wir diese Lücke und erklären in einem neuen Arbeitspapier, wie KI-Ethikprinzipien in die Praxis überführt werden können.

Mit der zunehmenden Nutzung algorithmischer Systeme in allen Lebensbereichen hat auch die Diskussion über einen „Europäischen Weg“ für den Einsatz Künstlicher Intelligenz an Dynamik gewonnen. Menschengerechte und vertrauenswürdige KI sind die Schlagworte, mit denen politische Akteure in Deutschland und auf europäischer Ebene diesen Weg beschreiben. Dazu wurde eine Vielzahl an ethischen Leitlinien für die Gestaltung von KI und algorithmischen Systemen veröffentlicht, denen bestimmte Prinzipien wie Gerechtigkeit, Transparenz und Robustheit gemeinsam sind.

Auch die Bertelsmann Stiftung hat mit den Algo.Rules im April 2019 neun Prinzipien für die ethische Entwicklung und den Einsatz algorithmischer Systeme vorgestellt. Die Regeln sollen bereits bei der Entwicklung der Systeme mitgedacht und „by design“ implementiert werden. Wie viele andere Initiativen steht das Algo.Rules-Projekt nun vor der Herausforderung, die Leitlinien in der Praxis zur Anwendung zu bringen.

Allgemeine ethische Prinzipien müssen messbar gemacht werden!

Dazu müssen allgemeine ethische Prinzipien messbar gemacht werden. Denn es gibt viele unterschiedliche Verständnisse für Begriffe wie Transparenz und Gerechtigkeit. Dies führt dazu, dass KI-entwickelnden Unternehmen die nötige Orientierung fehlt und eine wirksame Kontrolle der algorithmischen Systeme nicht möglich ist. Diese fehlende Konkretisierung ist aktuell eines der größten Hindernisse für die Entwicklung gemeinwohlorientierter KI.

In Kooperation mit der gemeinnützigen Normierungsorganisation VDE hat die Bertelsmann Stiftung daher die interdisziplinäre AI Ethics Impact Group ins Leben gerufen. Ihr gemeinsam entwickeltes Arbeitspapier „AI Ethics: From Principles to Practice – An interdisciplinary framework to operationalise AI ethics“ schließt diese Lücke und erklärt, wie KI-Ethikprinzipien europaweit operationalisiert und in die Praxis überführt werden können. In der AI Ethics Impact Group kamen Expert:innen aus den Bereichen Informatik, Philosophie, Ingenieurs- und Sozialwissenschaften zusammen. Beteiligt waren unter anderem Wissenschaftler:innen des Algorithmic Accountability Labs der TU Kaiserslautern, des Höchstleistungsrechenzentrum der Uni Stuttgart, des Instituts für Technikfolgenabschätzung und Systemanalyse (ITAS) in Karlsruhe, des Instituts für Philosophie der TU Darmstadt, des Internationalen Zentrums für Ethik in den Wissenschaften (IZEW) der Uni Tübingen und des Thinktanks iRights.Lab.

Ein Ethik-Label für KI-Systeme setzt Anreize über Regulierung hinaus

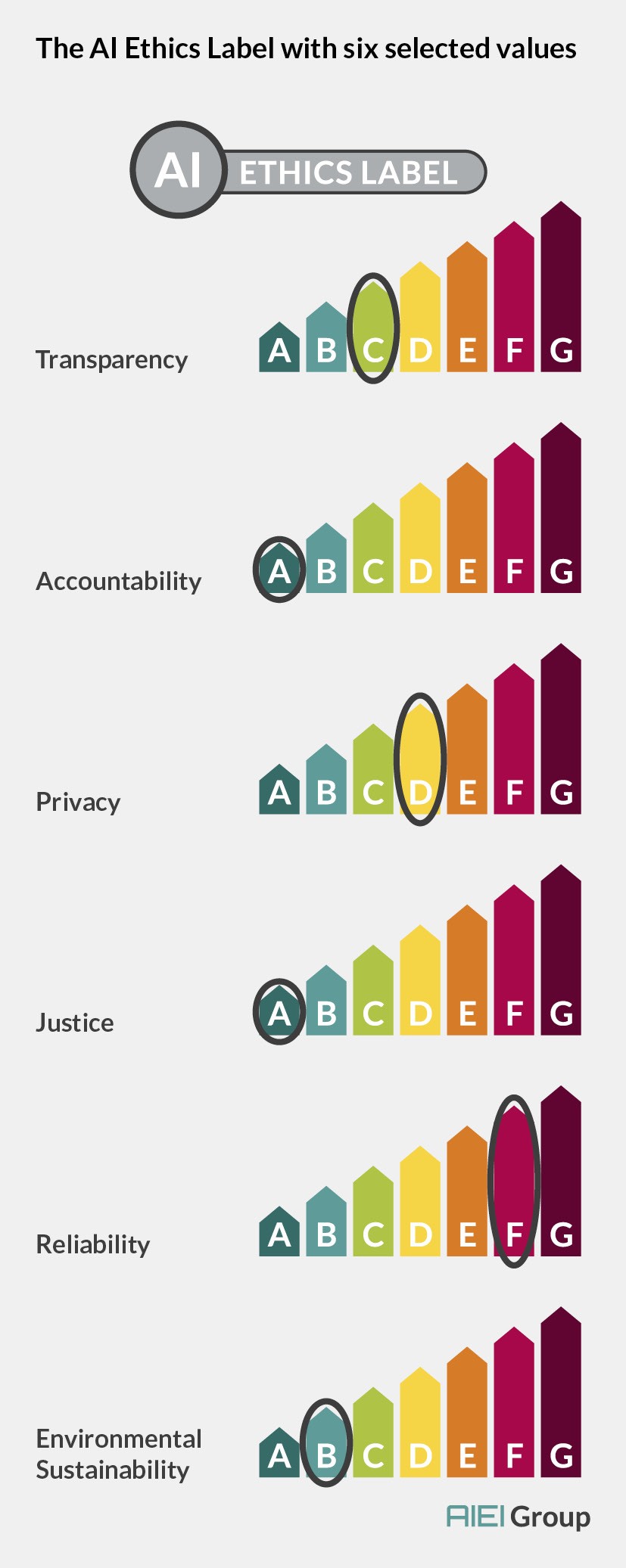

Zentrales Element des Papiers ist der Vorschlag eines Ethik-Labels für KI-Systeme. Solch ein Label bietet – ähnlich wie beim Energieeffizienzlabel für Elektrogeräte – KI-entwickelnden Organisationen die Möglichkeit, die Qualität ihrer Produkte nach außen zu kommunizieren. Für Konsumenten und KI-einsetzende Organisationen macht das Label die auf dem Markt zur Verfügung stehenden Produkte besser vergleichbar und schafft einen schnellen Überblick, ob ein algorithmisches System die im Anwendungsfall nötigen ethischen Anforderungen erfüllt. So kann über rechtlich vorgegebene Grenzen hinaus eine ethische Entwicklung von KI gefördert werden. Als mögliche Bestandteile des KI-Ethiklabels schlägt das Papier, basierend auf einer Metanalyse von über 100 KI-Ethikrichtlinien, die Werte Transparenz (transparency), Verantwortlichkeit (accountability), Schutz der Privatsphäre (privacy), Gerechtigkeit (justice), Verlässlichkeit (reliability) und Nachhaltigkeit (environmental sustainability) vor.

Bei dem vorgeschlagenen Label handelt es sich nicht um ein einfaches Ja/Nein-Prüfsiegel, sondern um eine abgestufte Kennzeichnung relevanter Eigenschaften eines Systems:

Das WKIO-Modell konkretisiert allgemeine Werte

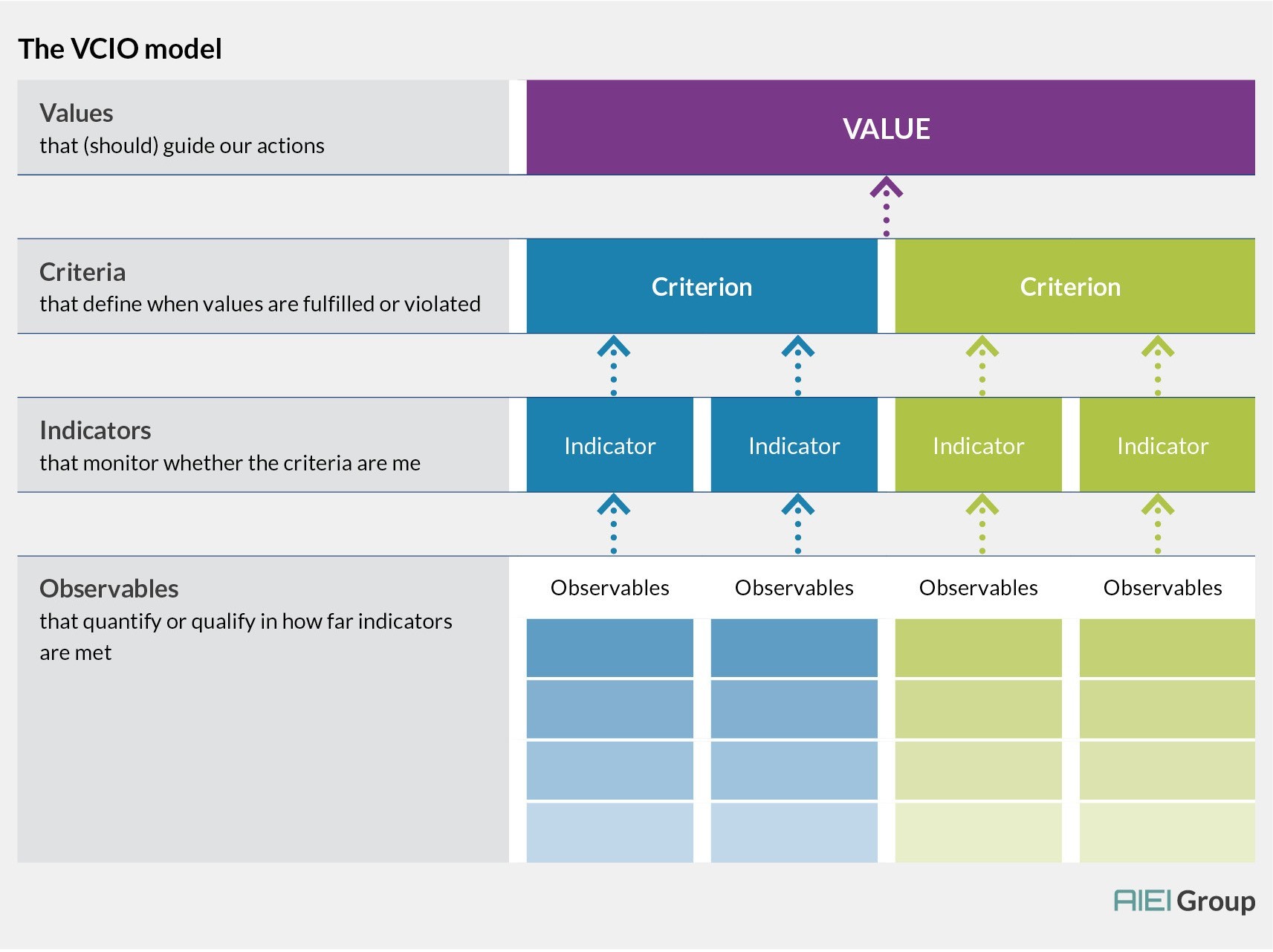

Welche Anforderungen zum Erreichen einer bestimmten Stufe notwendig sind, kann vorab mithilfe des sogenannten WKIO-Modells bestimmt werden. Das Modell bildet die methodische Basis für den Vorschlag der AI Ethics Impact Group und kann dabei helfen, allgemeine Werte durch die Aufschlüsslung in Kriterien, Indikatoren und schlussendlich messbare Observablen zu konkretisieren, um deren Umsetzung so überprüfbar zu machen. Demonstriert wird die Anwendung des WKIO-Modells im Papier anhand der Werte Transparenz, Verantwortlichkeit und Gerechtigkeit.

Die Grafik zeigt, wie im WKIO Model Werte, Kriterien, Indikatoren und Observablen zusammen wirken.

Die Wirkung algorithmischer Systeme hängt nicht nur von technischen Fragen, sondern auch von ihrer organisationalen Einbettung ab. Daher sollten sowohl Anforderungen an das technische System (System-Standards) als auch an den Prozess seiner Entwicklung und Einbettung (Prozess-Standards) definiert werden. Beim „Transparenz“-Wert kann beispielsweise gefordert werden, dass bei gleichbleibender Genauigkeit ein möglichst einfach erklärbares KI-System genutzt wird, dass alle Betroffenen über die Funktionsweise eines Systems informiert und dass die zur Verfügung gestellten Informationen zielgruppengerecht aufbereitet werden.

Die Risiko-Matrix hilft bei Klassifizierung von KI-Anwendungsfällen

Welche Stufe auf dem Ethik-Label als „ethisch akzeptabel“ gilt, ist vom konkreten Anwendungsfall abhängig. Ein Algorithmus, der aufgrund seiner Komplexität im Bereich Transparenz nur die Bewertung D erreicht, kann beispielsweise in der Landwirtschaft ausreichen. Wird dasselbe System mit personenbezogenen Daten im Gesundheitssektor angewendet und, muss nach einer Alternative mit besserer Bewertung gesucht werden.

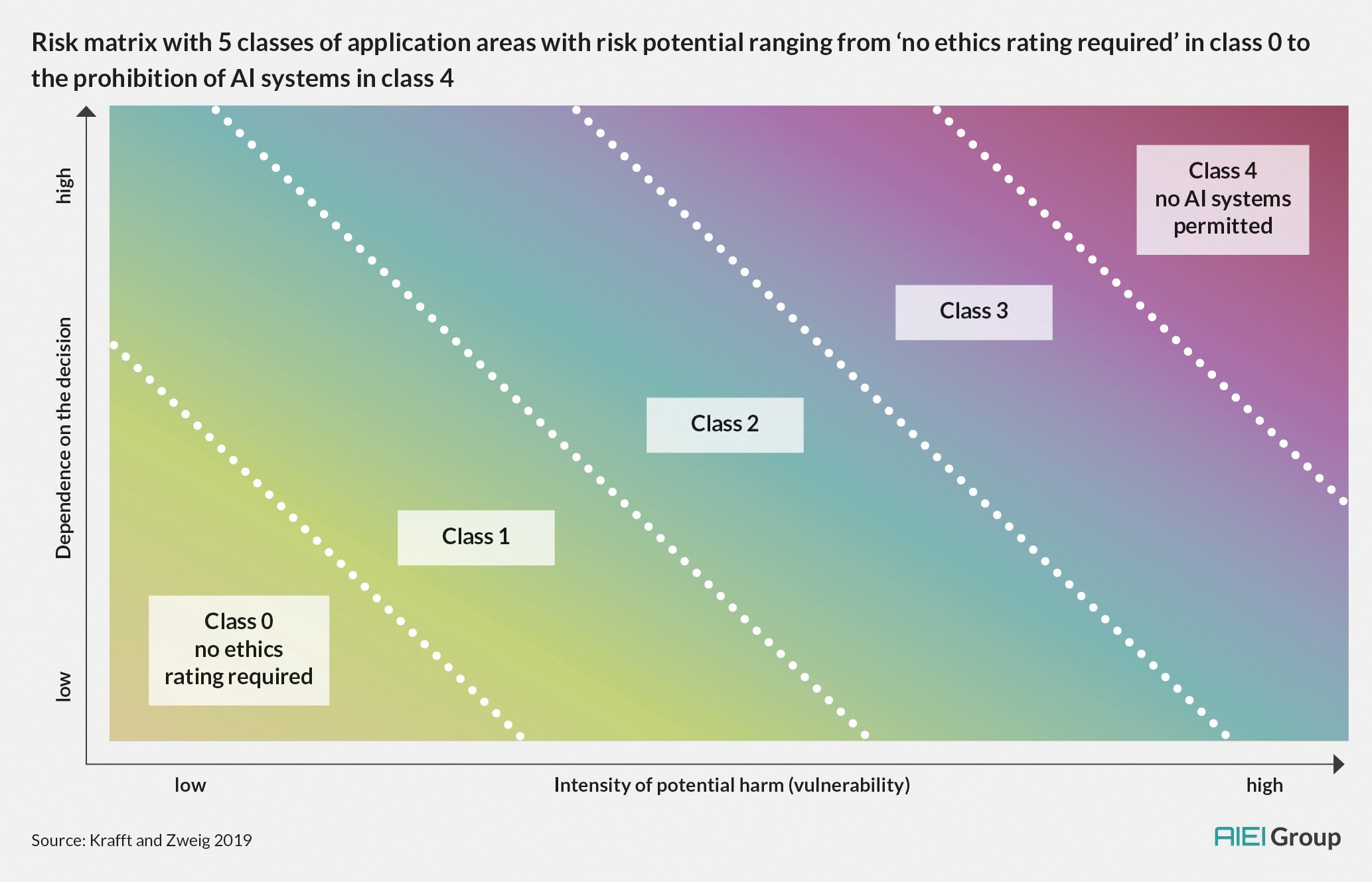

Mit der „Risiko-Matrix“ stellt das Papier einen Ansatz zur Klassifizierung verschiedener Anwendungskontexte vor. Statt einer binären Einteilung in Hochrisiko und Nicht-Hochrisikofälle (wie etwa im KI-Weißbuch der EU-Kommission vorgeschlagen), nutzt die Risiko-Matrix einen zweidimensionaler Ansatz, der der gegebenen Vielfalt verschiedener Anwendungsfälle besser gerecht wird. Als Dimensionen für die Klassifizierung schlägt das Papier die Intensität des potenziellen Schadens (X-Achse) und die Abhängigkeit der betroffenen Person(en) von der jeweiligen Entscheidung (Y-Achse) vor. Die Intensität des potenziellen Schadens berücksichtigt sowohl das Ausmaß der Verletzung von individuellen Grundrechten, die Anzahl der betroffenen Personen, sowie mögliche negative Auswirkungen auf die Gesellschaft als Ganzes, beispielsweise wenn demokratische Meinungsfindungsprozesse betroffen sind. Die Abhängigkeit der betroffenen Person(en) hängt unter anderem von der Möglichkeit ab, sich einer Entscheidung zu entziehen, ein anderes System wählen oder eine bestehende Entscheidung hinterfragen zu können.

Wir empfehlen eine Aufteilung in fünf Risiko-Klassen (siehe Grafik). Während Klasse 0 keine ethischen Überlegungen zur KI erfordert und bei Anwendungsfällen in Klasse 4 keine KI-Systeme eingesetzt werden sollten, müssen die konkreten Ansprüche an die Klassen 1, 2 und 3 mit Hilfe des WKIO-Modells ausdifferenziert werden.

Diese Systematik kann durch politische Akteure und Kontrollbehörden genutzt werden, um Anforderungen an KI-Systeme zu konkretisieren und eine wirksame Kontrolle zu ermöglichen. Organisationen, die algorithmische Systeme in ihrer Arbeit einsetzen wollen, können das Modell nutzen, um Kriterien für die Beschaffung der Software zu definieren.

Ein Werkzeugkasten für die weitere Arbeit an der KI-Ethik

Die in dem Arbeitspapier vorgestellten Lösungsansätze – vom Ethik-Label über das WKIO-Modell bis hin zur Risiko-Matrix – sind in ihrer aktuellen Fassung noch praktisch zu erproben und auch inhaltlich weiter zu detaillieren. Es handelt sich um Vorschläge, die dabei helfen sollen, die dringend notwendige Übertragung allgemeiner KI-Ethikprinzipien in die Praxis zu beschleunigen. Politische, Verwaltung und Standardsetzungsorganisationen sollten das Papier als Werkzeugkasten begreifen, welcher in partizipativen und interdisziplinären Prozessen weiter spezifiziert und reflektiert werden muss.

Wir freuen uns, auch zukünftig weiterhin Teil dieser Debatte zu bleiben!

Dieser Artikel ist lizenziert unter einer Creative Commons Namensnennung 4.0 International Lizenz.

Kommentar schreiben